Source: The Conversation – in French – By Domenico Vicinanza, Associate Professor of Intelligent Systems and Data Science, Anglia Ruskin University

Après un demi-siècle de gains réguliers en puissance de calcul, l’informatique entre dans une nouvelle ère. La miniaturisation ne suffit plus : les progrès dépendent désormais de l’architecture, de l’énergie et de logiciels optimisés.

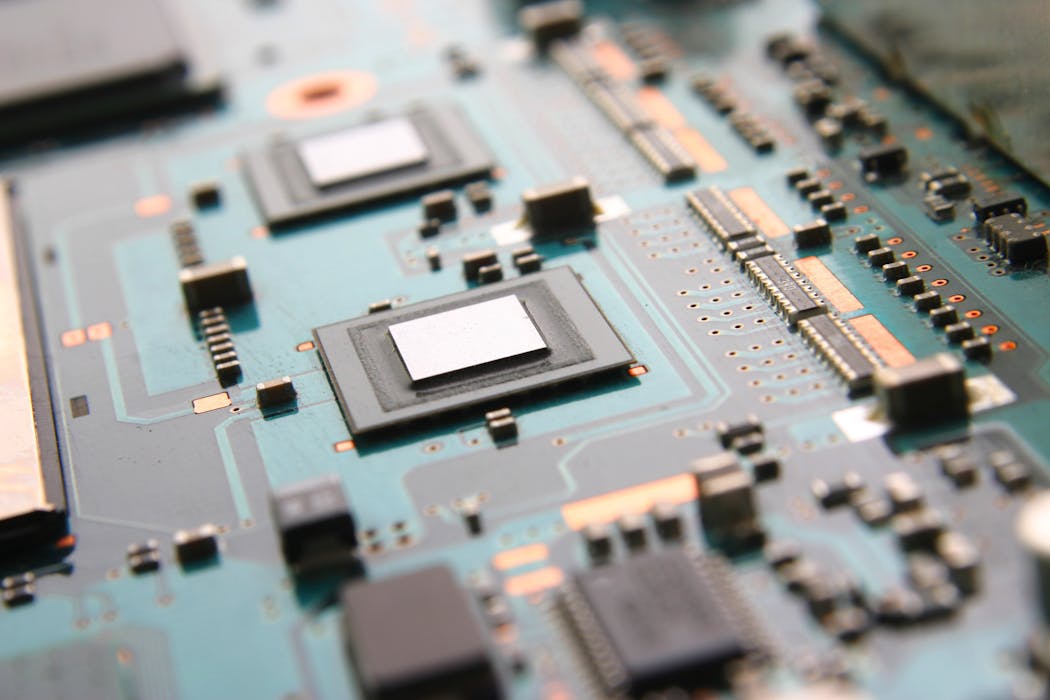

Pendant un demi-siècle, l’informatique a progressé de manière rassurante et prévisible. Les transistors – ces dispositifs qui servent à contrôler le passage des signaux électriques sur une puce informatique – sont devenus de plus en plus petits, ce qui permet d’en amasser davantage sur une seule puce. En conséquence, les puces ont gagné en rapidité, et la société a intégré ces avancées presque sans s’en rendre compte.

Ces puces plus rapides ont offert une puissance de calcul accrue en permettant aux appareils d’exécuter les tâches plus efficacement. On a ainsi vu les simulations scientifiques s’améliorer, les prévisions météorologiques gagner en précision, les images devenir plus réalistes, puis les systèmes d’apprentissage automatique émerger et se développer. Tout se passait comme si la puissance de calcul obéissait à une loi naturelle.

La fin des certitudes

Ce phénomène a pris le nom de loi de Moore, d’après l’homme d’affaires et scientifique Gordon Moore. Elle résumait l’observation empirique selon laquelle le nombre de transistors sur une puce doublait approximativement tous les deux ans. Cela permettait aussi de réduire la taille des appareils et alimentait en conséquence la miniaturisation.

Ce sentiment de certitude et de prévisibilité a désormais disparu, non pas parce que l’innovation se serait arrêtée, mais parce que les hypothèses physiques qui la soutenaient autrefois ne sont plus valables.

Qu’est-ce qui remplace alors l’ancien modèle d’augmentation automatique des performances ? La réponse ne tient pas à une seule avancée technologique, mais à plusieurs stratégies qui se superposent.

De nouvelles approches

L’une d’elles repose sur de nouveaux matériaux et de nouvelles architectures de transistors. Les ingénieurs améliorent encore leur conception afin de limiter les pertes d’énergie et les fuites électriques indésirables. Ces évolutions apportent des gains plus modestes et plus progressifs qu’autrefois, mais elles permettent de mieux maîtriser la consommation énergétique.

Une autre approche consiste à modifier l’organisation physique des puces. Au lieu de disposer tous les composants sur une surface plane unique, les puces modernes empilent de plus en plus les éléments les uns sur les autres ou les rapprochent davantage. Cela réduit la distance que doivent parcourir les données, ce qui permet de gagner à la fois en temps et en énergie.

Le changement le plus important est sans doute la spécialisation. Au lieu de confier toutes les tâches à un unique processeur polyvalent, les systèmes modernes combinent différents types de processeurs. Les unités de traitement traditionnelles, ou CPU, assurent le contrôle et la prise de décision. Les processeurs graphiques sont des unités de calcul très puissantes, conçues à l’origine pour répondre aux exigences du rendu graphique dans les jeux vidéo et d’autres usages. Les accélérateurs d’IA (du matériel spécialisé qui accélère les tâches liées à l’intelligence artificielle) se concentrent sur l’exécution en parallèle d’un très grand nombre de calculs simples. Les performances dépendent désormais de la manière dont ces composants fonctionnent ensemble, plutôt que de la vitesse de chacun pris isolément.

Des technologies expérimentales

Parallèlement à ces évolutions, les chercheurs explorent des technologies plus expérimentales, notamment les processeurs quantiques (qui exploitent les principes de la physique quantique) et les processeurs photoniques, qui utilisent la lumière plutôt que l’électricité.

Il ne s’agit pas d’ordinateurs polyvalents, et ils ont peu de chances de remplacer les machines classiques. Leur intérêt réside dans des domaines très spécifiques, comme certains problèmes d’optimisation ou de simulation, pour lesquels les ordinateurs traditionnels peinent à explorer efficacement un grand nombre de solutions possibles. En pratique, ces technologies doivent être envisagées comme des coprocesseurs spécialisés, utilisés de manière ciblée et en complément des systèmes traditionnels.

Pour la plupart des usages informatiques du quotidien, les progrès des processeurs conventionnels, des systèmes de mémoire et de la conception logicielle resteront bien plus déterminants que ces approches expérimentales.

Pour les utilisateurs, l’ère post-Moore ne signifie pas que les ordinateurs cesseront de s’améliorer. Cela veut juste dire que les progrès se manifesteront de manière plus inégale et plus dépendante des usages. Certaines applications — comme les outils fondés sur l’IA, le diagnostic, la navigation ou la modélisation complexe — pourraient connaître de vraies avancées, tandis que les performances généralistes progresseront plus lentement.

Nouvelles technologies

Lors de la conférence Supercomputing SC25 à Saint-Louis, plusieurs systèmes hybrides associant CPU (processeurs), GPU (processeurs graphiques) et technologies émergentes — comme les processeurs quantiques ou photoniques — ont été présentés comme des prolongements concrets de l’informatique classique. Pour l’immense majorité des usages quotidiens, ce sont toutefois les progrès des processeurs traditionnels, des mémoires et des logiciels qui continueront d’apporter les gains les plus significatifs.

On note un intérêt croissant pour les dispositifs quantiques et photoniques comme coprocesseurs, et non comme remplaçants. Ils sont particulièrement utiles pour des problèmes très spécifiques, comme l’optimisation ou le routage complexes, où les machines classiques seules peinent à trouver des solutions efficaces.

Dans ce rôle d’appoint, ils offrent un moyen crédible d’allier la fiabilité de l’informatique classique à de nouvelles techniques de calcul, élargissant ainsi les capacités des systèmes.

Un nouveau récit

La suite n’est pas une histoire de déclin, mais un processus de transformation et d’évolution permanentes. Les progrès en informatique reposent désormais sur la spécialisation des architectures, une gestion rigoureuse de l’énergie et des logiciels conçus en tenant pleinement compte des contraintes matérielles. Le risque est de confondre complexité et inéluctabilité, ou narratifs marketing et problèmes réellement résolus.

L’ère post-Moore impose une relation plus réaliste avec l’informatique : la performance n’est plus un acquis automatique lié à la miniaturisation des transistors, mais un résultat qu’il faut concevoir, justifier et payer – en énergie, en complexité et en compromis.

![]()

Domenico Vicinanza ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. La loi de Moore ayant atteint ses limites, que nous réserve l’avenir de l’informatique ? – https://theconversation.com/la-loi-de-moore-ayant-atteint-ses-limites-que-nous-reserve-lavenir-de-linformatique-274553