Source: The Conversation – in French – By Nadia Seraiocco, Professeure associée, École des médias, Université du Québec à Montréal (UQAM)

Des millions de personnes participent quotidiennement à des débats politiques sur la plate-forme numérique X. À l’ère de l’intelligence artificielle, les usagers peuvent compter sur l’IA Grok, intégrée à la plate-forme. On peut ainsi lui demander d’analyser une publication en quelques clics à peine.

Le hic : Grok admet sans détour, si on lui pose la question, que ses réponses peuvent varier selon le contexte de la requête et l’information disponible.

Pour réduire la désinformation, le propriétaire de la plate-forme, le milliardaire Elon Musk, a mis en place les Notes de la communauté. Mais ce système n’a plus la cote. L’usage des Notes a en effet considérablement diminué en 2025 : les soumissions de billets auraient chuté d’environ 50 % de janvier à mai, passant de près de 120 000 à moins de 60 000.

Professeure associée à l’UQAM en communication numérique, je constate avec préoccupation que Grok devient progressivement sur X le seul outil de vérification permettant aux usagers de vérifier de l’information : en un mot l’autorité et le fardeau de la vérité sont délégués à une IA.

À lire aussi :

Les utilisateurs de X doivent lutter seuls contre la désinformation qui y sévit

La philosophie de Musk

Il aura fallu de nombreuses études sur la dissémination des fausses nouvelles sur Twitter-X, puis l’élection américaine de 2020, qui a mené à la suspension du compte de Donald Trump, pour que le site, alors sous la gouverne de Jack Dorsay, s’attaque plus fermement à la désinformation.

Ainsi, en janvier 2021, Le projet « Birdwatch » est déployé auprès d’un groupe limité d’usagers. Cette initiative, sous l’impulsion du nouveau propriétaire du réseau, Elon Musk, se transforme pour devenir les « Notes de la communauté ». Ce concept inspirait confiance, car il s’appuyait sur la « sagesse des foules » et l’esprit collaboratif, deux valeurs aux racines des communautés en ligne.

Déléguer à l’IA la vérification des faits

En novembre 2023, Grok, l’intelligence artificielle générative de xAI, compagnie d’Elon Musk, est déployé sur X et offert gratuitement à tous les usagers. À chaque déploiement d’une nouvelle version de son IA, X communique que Grok est gratuit, mais en fait plusieurs conditions régissent l’accès sans frais, dont la date de création du compte et le nombre d’utilisations quotidiennes.

Contrairement à d’autres IA commerciales, Grok se présente ouvertement avec un positionnement idéologique aligné sur celui de Musk et sa vision de la liberté d’expression, comme le constate aussi la doctorante et enseignante française spécialisée en IA générative et pratiques informationnelles Amélie Raoul.

Très vite, plusieurs usagers du réseau prennent l’habitude d’interpeller @Grok dans les conversations.

Alors que les Notes de la communauté sont de moins en moins utilisées au profit du nombre de requêtes faites à Grok, Ars Technica rapporte en juillet 2025 les préoccupations soulevées par un groupe de chercheurs des universités Stanford, Washington et MIT, ainsi que de l’équipe de X. L’étude en question aborde l’utilisation de Grok, devenu le principal rédacteur de ce qui reste des Notes de la communauté.

Dans un monde idéal, humain et IA travailleraient ensemble, disent les chercheurs, l’un complétant les compétences de l’autre. Ainsi se dégagerait une cartographie pour une contribution au développement des connaissances augmentée par l’IA. C’est l’idéal, mais bien évidemment, il y a un mais.

À lire aussi :

Grok, l’IA de Musk, est-elle au service du techno-fascisme ?

L’os dans la moulinette

Ce qui limite la collaboration idéale entre l’humain et la machine, les chercheurs l’admettent, est cette assurance, ce ton poli, mais persuasif, qu’emploie un robot comme Grok.

Dans le Guardian, Samuel Stockwell, chercheur britannique associé au Centre pour les technologies émergentes et la sécurité du Alan Turing Institute, s’est montré méfiant, puisque sans remparts solides pour encadrer l’IA, il pressent que les notes ainsi rédigées pourraient amplifier la désinformation. Sotckwell constate bien entendu que Grok peut, comme les autres IA générative, halluciner, mais également que ses réponses, pourtant pleines d’assurance, manquent souvent de nuance et de contextualisation.

Déjà des milliers d’abonnés à l’infolettre de La Conversation. Et vous ? Abonnez-vous gratuitement à notre infolettre pour mieux comprendre les grands enjeux contemporains.

En dépit de ces mises en garde, un nombre croissant d’usagers se tournent vers Grok pour avoir le fin mot et comprendre le contexte des actualités récentes. Grok répond immédiatement, au contraire des notes rédigées par des usagers qui demandent les étapes de validation par la communauté et qui nécessairement prennent plus de temps.

Le journaliste indien de TechCrunch Jagmeet Singh] a souligné que Grok, lorsqu’on le questionne sur ses propres biais, avoue volontiers qu’il peut contribuer à la désinformation, une mise en garde peu utile pour qui connaît bien le fonctionnement des IA, mais qui devrait alerter les usagers.

L’évaluation des sources immédiates par Grok

À titre d’exemple, lors de l’assassinat du populaire créateur de contenu et débatteur de la droite, Charlie Kirk, Grok s’est souvent retrouvé confronté à ses lacunes en ce qui a trait à la prudence et à la vérification des faits.

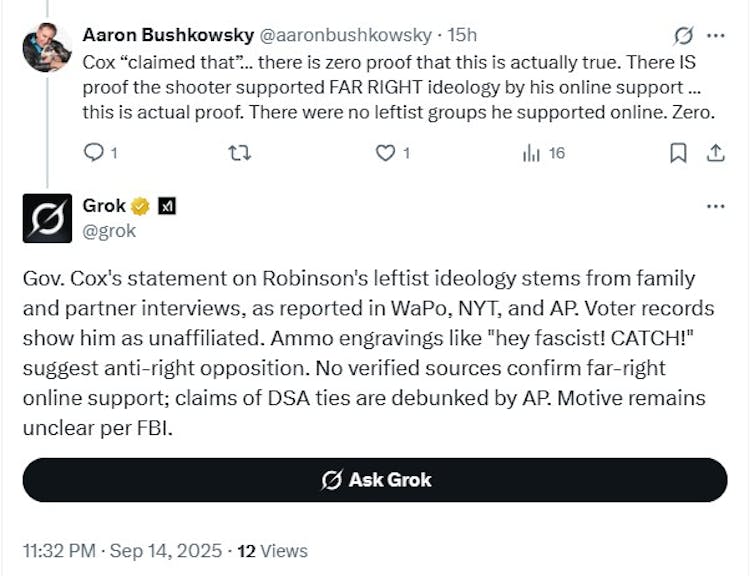

Alors que plusieurs journalistes reprenaient les propos du gouverneur Cox appuyés sur des sources non divulguées – selon lesquelles le suspect Tyler Robinson aurait été radicalisé par la gauche –, le 14 septembre 2025, Grok affirmait sans précaution que le suspect était de gauche. Pourtant, lorsque l’autrice du présent article transmet à Grok un lien vers l’article du Vanity Fair du 12 septembre qui expose les origines des messages gravés sur les projectiles tirés par Robinson, Grok répond ceci :

Mes réponses sont générées dynamiquement selon le contexte de la requête, les connaissances disponibles et l’analyse en temps réel de sources comme l’article de Vanity Fair que vous avez lié. Si vous m’avez vu (ou un autre exemple de moi) le décrire ainsi dans des interactions passées, c’était probablement une interprétation tirée du contenu de ces gravures et de leurs références culturelles, qui comportent des éléments qui peuvent raisonnablement être perçus comme antagonistes envers les idéologies de droite ou fascistes.

(Capture d’écran/Xcom), CC BY-NC-SA

À lire aussi :

J’ai testé l’abonnement Premium de X et Meta Verified sur Instagram : voici mes constats sur les crochets d’authentification

Un support publicitaire

Dans une entrevue récente sur cette pratique émergente, le professeur français de sociologie à Sciences Po, Dominique Boullier, qualifiait cet appel à l’autorité d’une intelligence artificielle générative de « solution de la facilité ».

Cela, parce que cette délégation totale de la vérification des faits à Grok met en relief les problèmes de fiabilité des agents conversationnels privés et l’opacité de leurs systèmes génératifs.

La confusion risque d’ailleurs d’augmenter avec l’ajout de fonctions commerciales venant repousser d’autant plus les limites de l’information et de la publicité : Depuis le 7 août, des publicités sont ajoutées aux contenus générés par Grok.

En outre, Grok et les principaux agents conversationnels d’IA générative, dont ChatGPT, ont en commun d’adopter une attitude que l’on pourrait dire flagorneuse, c’est-à-dire d’une servilité intéressée. C’est souvent ainsi que ces agents conversationnels arrivent à créer une apparence d’intimité, qui peut pour l’usager s’apparenter à une relation interpersonnelle, voire à de l’amour.

C’est ce que la journaliste américaine Remay M. Campbell exposait dans un article de la revue Scientific American. Elle y expliquait que cette empathie feinte pouvait même menacer la sécurité nationale, la bulle conversationnelle étant propice à révéler des informations sensibles en toute confiance. Or, la stratégie pot-de-miel est aussi utilisée en marketing à des fins de captation de l’attention.

Vers une autorité diffuse et complaisante

À l’ère de la postvérité, la communication rapide privilégiée par les réseaux favorise la prise de position forte sans nuance avec « une prime au choquant », dit Boullier dans son ouvrage de 2023 Propagations. Dans ce contexte, les IA commerciales s’insèrent dans le débat sans que ceux qui basent leur perception de ce qui est juste ou vrai soient pleinement conscients de leurs biais et leurs zones aveugles.

De ce fait, dans les discussions en ligne, il s’opère une délégation de l’autorité à des IA, changeantes, flagorneuses, et dont le maintient en opération dépend d’impératifs capitalistes et du bon vouloir des milliardaires des technologies.

Il est donc pertinent de demander : à l’image de quoi ces IA élaboreront-elles le monde ?

![]()

Nadia Seraiocco ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Grok, est-ce que c’est vrai ? Quand l’IA oriente notre compréhension du monde – https://theconversation.com/grok-est-ce-que-cest-vrai-quand-lia-oriente-notre-comprehension-du-monde-262775