Source: The Conversation – in French – By Olasunkanmi Habeeb Okunola, Senior Research Associate, United Nations University – Institute for Environment and Human Security (UNU-EHS), United Nations University

Lors du sommet mondial sur le climat de 2025, la COP30, qui s’est tenu à Belém, au Brésil, une décision a eu des conséquences majeures pour l’Afrique. Les pays se sont mis d’accord sur un nouvel ensemble d’indicateurs pour mesurer les progrès.

Les « indicateurs d’adaptation de Belém » ont été élaborés au cours d’un processus de deux ans mené par les Nations unies.

Bien que le nom puisse sembler technique, l’idée est simple. Pour la première fois, les pays disposent désormais d’un moyen commun de déterminer si le monde s’adapte réellement mieux aux effets du changement climatique. L’adaptation au climat consiste à prendre des mesures pour se préparer et faire face aux effets du changement climatique. Ces effets comprennent les inondations, les sécheresses, les vagues de chaleur, l’érosion côtière, les pertes de récoltes et les déplacements de populations liés au climat.

Les indicateurs de Belém

Alors, que sont exactement les indicateurs de Belém et comment fonctionnent-ils ?

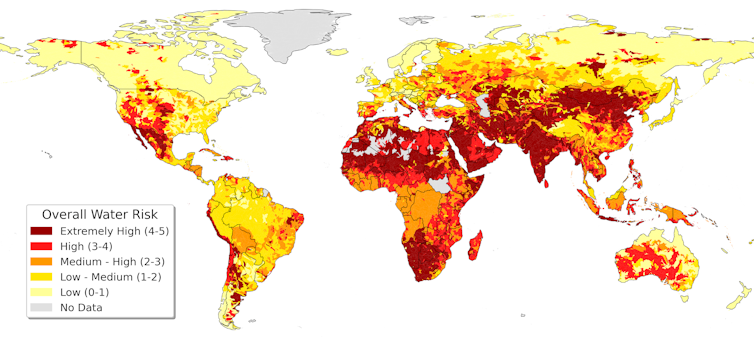

Il s’agit d’un nouvel ensemble de 60 mesures simples qui aident les pays à suivre leur niveau d’adaptation au changement climatique. Ils examinent les éléments qui affectent la vie quotidienne des populations. Il s’agit notamment de la sécurité de l’approvisionnement en eau, des systèmes alimentaires, de la santé, du logement, des systèmes d’alerte précoce, des écosystèmes et des économies locales. Au lieu de se concentrer uniquement sur les politiques écrites sur papier, les indicateurs examinent si les communautés deviennent réellement plus sûres et mieux à même de faire face aux inondations, aux sécheresses, aux vagues de chaleur et aux autres menaces climatiques.

Les indicateurs sont regroupés en thèmes clés, tels que :

-

réduire les risques climatiques : systèmes d’alerte précoce, préparation aux catastrophes

-

renforcer la résilience : systèmes de santé, sécurité alimentaire et hydrique

-

protéger les écosystèmes : forêts, zones humides et zones côtières

-

soutenir les personnes vulnérables : genre, handicap, groupes autochtones

-

suivre les finances et les ressources : comment les fonds destinés à l’adaptation sont acheminés vers les communautés.

Ensemble, ces 60 mesures offrent aux pays un moyen commun de comprendre et de suivre les progrès réalisés et les domaines dans lesquels un soutien est nécessaire de toute urgence.

Pendant des années, l’adaptation a été abordée en termes généraux, souvent sans mesures claires des progrès réalisés. Les indicateurs de Belém visent à changer cela en fournissant un langage commun pour décrire ce qu’implique la résilience et si les populations, en particulier les plus vulnérables, deviennent plus sûres.

En tant que spécialiste de la réduction des risques de catastrophe et de l’adaptation au changement climatique, j’ai examiné les nouveaux indicateurs de Belém et leur pertinence pour l’Afrique. Ils représentent une étape importante à l’échelle mondiale, mais leur succès dépendra d’un financement solide, d’une conception inclusive et d’une mise en œuvre localement ancrée Avec la COP32 qui se tiendra à Addis-Abeba, l’Afrique peut contribuer à transformer ces indicateurs d’ambition en impact réel.

Read more:

Climat : les pays africains se préparent à donner un coup d’accélérateur

Pourquoi est-ce important pour l’Afrique ?

L’Afrique subit certaines des conséquences climatiques les plus graves au monde. Dans l’ouest et le centre de l’Afrique, les inondations ont déplacé des centaines de milliers de personnes. Parallèlement, une chaleur record dans tout le Sahel met à rude épreuve les systèmes de santé, de production alimentaire et de systèmes d’énergie.

Dans le même temps, les communautés africaines trouvent leurs propres solutions, qu’il s’agisse de systèmes d’alerte précoce locaux, de projets basés sur la nature, de groupes d’épargne communautaires ou de pratiques agricoles innovantes.

Mais jusqu’à présent, il n’existait aucun moyen global de reconnaître ces efforts, de suivre les progrès ou d’identifier les endroits où l’aide est la plus nécessaire. Les indicateurs de Belém commencent à combler cette lacune.

Pour l’Afrique, c’est important. Trop souvent, les moyennes nationales masquent de fortes inégalités. Elles cachent des écarts entre les zones rurales et urbaines, entre les familles riches et pauvres, et entre les groupes exposés à des menaces climatiques très différentes. Mettre l’accent sur l’équité permet d’éviter que les personnes les plus exposées ne soient ignorées.

Mais les indicateurs ne sont pas parfaits

Si l’adoption des indicateurs d’adaptation de Belém constitue une avancée majeure, ils ne sont toutefois pas, à mon avis, l’outil abouti dont le monde a besoin.

De nombreux négociateurs, observateurs et experts techniques ont noté que plusieurs éléments ont été édulcorés lors des dernières phases de négociation, rendant certains indicateurs plus généraux ou moins précis que prévu initialement. D’autres nécessitent des informations que de nombreux pays africains ne sont pas encore en mesure de collecter régulièrement, faute de systèmes ou de ressources.

Les pays manquent souvent de données fiables sur les dommages annuels causés par les effets du changement climatique, tels que les inondations ou les sécheresses. Ils ne disposent pas toujours d’évaluations locales permettant d’identifier les communautés les plus exposées et les raisons de cette exposition. En outre, ils ont du mal à vérifier si les fonds alloués à l’adaptation parviennent réellement aux personnes qui en ont besoin.

Ces défis ne remettent pas en cause la valeur du cadre. Ils mettent plutôt en évidence une réalité pratique : s’accorder sur des indicateurs mondiaux n’est qu’une première étape. Pour les rendre significatifs, mesurables et équitables, en particulier pour les pays confrontés aux risques climatiques les plus élevés, il faudra les affiner davantage. C’est pourquoi la prochaine phase de travail est d’une grande importance.

Deux ans pour agir : de Belém à Addis-Abeba

Afin de renforcer les indicateurs, les pays se sont mis d’accord sur ce qu’on appelle la «Vision Belém-Addis», un processus de deux ans visant à affiner le cadre et à le rendre plus pratique. Le moment est symbolique : la COP32, en 2027, se tiendra à Addis-Abeba, en Éthiopie. Le monde s’attend à ce que les indicateurs soient plus clairs, plus faciles à utiliser et mieux adaptés aux différentes régions d’ici là.

Ce parcours de deux ans, de Belém à Addis, offre une opportunité unique à l’Afrique. La COP32 sera le premier véritable test pour déterminer si ces indicateurs peuvent aider les pays à évaluer et à communiquer les progrès réalisés en matière d’adaptation.

L’Afrique peut montrer la voie, et non se contenter de suivre

La contribution de l’Afrique sera essentielle pour deux raisons.

Premièrement, les défis climatiques du continent sont divers et évoluent rapidement. Les solutions qui fonctionnent dans un domaine peuvent ne pas fonctionner dans un autre. Cette diversité fait de l’Afrique le meilleur terrain d’essai pour les indicateurs mondiaux qui visent à refléter la complexité du monde réel.

Deuxièmement, l’Afrique est déjà une source d’innovation. La préparation communautaire aux catastrophes, les systèmes de connaissances autochtones, les services d’information climatique locaux et les stratégies de gestion de la mobilité climatique offrent des enseignements dont le monde peut tirer parti. Ces expériences devraient être intégrées dans le cadre des indicateurs, plutôt que d’être considérées comme des éléments secondaires.

Mais pour que l’Afrique puisse jouer ce rôle, elle aura besoin d’aide.

Une étape importante, mais le travail reste à faire

Les indicateurs d’adaptation de Belém apportent au monde ce qui lui manquait depuis longtemps : une approche commune, compréhensible et ciblée pour discuter de l’adaptation, axée sur ce qui importe le plus, à savoir la sécurité et le bien-être des populations. Mais ils ne sont pas une solution définitive. Ils sont un point de départ.

Avec la COP32 qui se tiendra à Addis-Abeba, l’Afrique a une occasion rare d’influer sur la prochaine génération d’outils d’adaptation mondiaux et de s’assurer qu’ils fonctionnent pour ceux qui vivent en première ligne du changement climatique.

Si le voyage de Belém à Addis est utilisé à bon escient, le monde sera mieux outillé pour construire des sociétés résilientes. Sinon, un temps précieux aura été perdu dans une décennie où chaque année compte.

![]()

Olasunkanmi Habeeb Okunola est chercheur principal à l’Institut pour l’environnement et la sécurité humaine (UNU-EHS) de l’Université des Nations Unies. Il a reçu de nombreuses bourses de recherche axées sur l’adaptation au changement climatique et la réduction des risques de catastrophe.

– ref. Adaptation climatique : pourquoi les indicateurs de Belém comptent pour l’Afrique – https://theconversation.com/adaptation-climatique-pourquoi-les-indicateurs-de-belem-comptent-pour-lafrique-273635