Source: The Conversation – in French – By Aubrée David-Chapy, Chercheuse associée au centre Roland-Mousnier, Sorbonne Université

À partir du Moyen Âge, l’éducation des filles fait l’objet d’une grande attention dans la noblesse et, dans une moindre mesure, les milieux bourgeois.

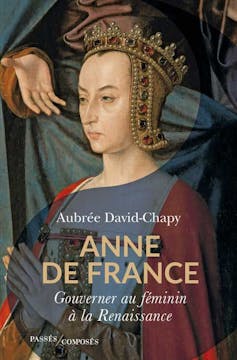

Le manuscrit original des Enseignements, rédigés au XVe siècle par la fille aînée du roi Louis XI, Anne de France, duchesse du Bourbonnais et d’Auvergne, destinés à sa fille de 12 ans, Suzanne de Bourbon, récemment réapparu sur le marché de l’art, nous éclaire sur les valeurs essentielles transmises aux princesses de la Renaissance.

Alors qu’on le croyait perdu depuis plus d’un siècle, le manuscrit original des Enseignements, d’Anne de France (1461-1522), destinés à sa fille Suzanne de Bourbon (1491-1521) a resurgi sur le marché de l’art au printemps 2025, et vient d’être classé « trésor national » par le ministère de la culture.

Historiens et historiens de l’art le pensaient égaré dans les fonds de la bibliothèque de Saint-Pétersbourg (Russie) qui était en sa possession depuis la fin du XVIIIe siècle environ. Il se trouvait en fait dans la collection particulière de Léon Parcé (1894-1979), érudit et passionné de Blaise Pascal (1623-1662), qui l’avait acquis des autorités soviétiques dans les années 1930.

La nouvelle de la réapparition de ce manuscrit réjouit historiens, historiens de l’art et de la littérature, qui ne le connaissaient que par une copie du XIXᵉ siècle et qui espèrent pouvoir l’étudier dans les prochaines années. Mais quelle est au juste la spécificité de ces Enseignements ?

Anne de France, une femme de pouvoir

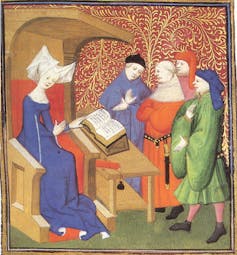

The British Library Board, Harley 4431, f.259v, via Wikimédia

L’éducation des filles constitue depuis le Moyen Âge un enjeu fondamental dans les milieux nobiliaires et, dans une moindre mesure, bourgeois. Comme les garçons, elles sont les destinataires de manuels de savoir-vivre appelés « miroirs » qui contiennent une multitude de préceptes moraux et de conseils pour la vie quotidienne.

Le Livre pour l’enseignement de ses filles, du chevalier de La Tour Landry, ou encore les enseignements de saint Louis à sa fille Isabelle de Navarre figurent au rang des plus connus.

Au XVe siècle, la femme de lettres Christine de Pizan rédige des miroirs à l’intention des princes, des princesses et, plus largement, des femmes de toutes conditions. Son Livre des trois vertus constitue un modèle dans lequel puiser.

Cependant, les Enseignements, d’Anne de France, qui se placent dans cette filiation littéraire, ont ceci de particulier qu’ils sont l’œuvre d’une mère pour sa fille, ce qui est assez unique. Surtout, Anne de France n’est pas une femme parmi d’autres : fille du roi Louis XI (1461-1483), c’est aussi la sœur de Charles VIII (1483-1498). Cette « fille de France » est l’une des femmes de pouvoir les plus puissantes du royaume, entre la fin du Moyen Âge et du début de la Renaissance.

Anne de France s’est imposée sur la scène politique dès les années 1480, en assurant une sorte de régence pour son frère Charles, aux côtés de son époux Pierre de Beaujeu. Dotée d’une grande expérience de la politique, de la cour et d’une grande culture, dont témoignent ses nombreuses références à Aristote et à saint Augustin, elle rédige les Enseignements à [s]a fille vers 1503-1505.

Il s’agit d’un moment charnière dans sa vie familiale. Tout juste veuve, celle qui n’est autre que duchesse de Bourbonnais et d’Auvergne, s’apprête à marier sa fille à Charles de Bourbon-Montpensier, connu plus tard sous le nom de connétable de Bourbon. Sans doute Anne s’est-elle inspirée des miroirs cités précédemment, conservés dans la bibliothèque des ducs de Bourbon, à Moulins.

La rédaction de ce miroir fait passer la princesse de la pratique à la théorie. En effet, en raison de son statut de fille de roi, Anne s’est illustrée depuis les années 1480 comme éducatrice de très nombreux princes et princesses envoyées par leurs familles à la cour de France pour recevoir un enseignement de premier plan. Outre son propre frère Charles qu’elle forme à son futur métier de roi, elle se voit confier Marguerite d’Autriche (tante de Charles Quint et régente des Pays-Bas), Louise de Savoie (mère de François Ier et première régente officielle du royaume de France), Philippe de Gueldre, duchesse de Lorraine, ou encore Diane de Poitiers toutes promises à un brillant avenir politique.

L’idéal de la princesse, parangon de vertu et de bonne éducation

C’est donc une femme d’expérience qui prend la plume pour s’adresser à Suzanne de Bourbon au tout début du XVIe siècle. Pour justifier son entreprise, elle évoque « la parfaite amour naturelle » qu’elle éprouve à l’égard de sa fille, alors âgée d’une douzaine d’années. Le manuscrit d’une centaine de feuillets dont elle fait don à Suzanne est enluminé et composé des Enseignements, suivis de l’Histoire du siège de Brest, bref opuscule dont Anne est également l’auteur.

Le contenu des Enseignements n’est en rien révolutionnaire, bien au contraire, il s’inscrit dans une tradition médiévale héritée du Miroir des Dames, de Durand de Champagne, et des écrits de Christine de Pizan.

Anne de France rappelle en premier lieu à sa fille son état de créature faible, marquée par le péché originel (comme toute créature humaine, homme ou femme) et la nécessité de dompter et de dépasser ses faiblesses naturelles afin de faire son salut sur terre.

C’est le principal objet de toute existence chrétienne. Pour cela, Suzanne devra s’efforcer d’acquérir la vertu qui se décline en de nombreuses qualités : prudence, piété, bonne renommée, courtoisie, humilité, maîtrise de soi, etc.

« Il n’est rien plus délectable à voir en femme noble que vertueux savoir »,

poursuit Anne. La vie doit ainsi s’ancrer dans la connaissance et la vérité, qui rapprochent de la sagesse, tout éloignant de la « folie » tant redoutée.

Destinée à être une femme de haut rang et à évoluer dans les milieux de cour, Suzanne devra savoir s’y comporter sans faire défaut à ses origines. Plus encore, il lui faudra se méfier de la fausseté ambiante de la cour, lieu du mensonge, du faux-semblant et de la trahison, qui représentent autant de pièges quotidiens à éviter.

Comme épouse, la princesse devra demeurer fidèle à sa propre lignée, « à son sang », tout en s’attachant fidèlement à son époux, se montrant notamment capable de le seconder en cas d’absence de ce dernier.

Les Enseignements expriment l’idéal de la princesse, parangon de vertu et de bonne éducation, selon Anne de France. Fruit d’années d’expérience du pouvoir et de la cour, ce miroir se présente comme un modèle de piété, de morale et de vertu destiné, certes, à sa fille mais, plus largement, à toutes les dames et demoiselles évoluant dans la sphère aulique.

C’est ce qui explique sa diffusion rapide dans le royaume de France, dès le premier quart du XVIe siècle, au sein des plus hautes franges de la société. Sous une forme imprimée, les Enseignements rejoignent par exemple les bibliothèques de Marguerite de Navarre, sœur du roi François Ier (1515-)1547), de Diane de Poitiers (1500-1566) puis de la puissante souveraine Catherine de Médicis (reine de France de 1547 à 1559, ndlr). C’est dire l’importance accordée par ses comparses aux conseils de celle qui fut l’une des plus puissantes femmes de la première Renaissance.

![]()

Aubrée David-Chapy ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. L’art d’éduquer les princesses de la Renaissance : ce que nous apprennent les « Enseignements » d’Anne de France – https://theconversation.com/lart-deduquer-les-princesses-de-la-renaissance-ce-que-nous-apprennent-les-enseignements-danne-de-france-264906