Source: The Conversation – in French – By Sonia Félix-Naix, Professeure agrégée d’anglais Membre du CIRPaLL (Centre Interdisciplinaire de Recherche sur les Patrimoines en Lettres et Langues), Université d’Angers

En octobre 2024, Joe Biden, alors encore président, présentait des excuses historiques aux peuples autochtones des États-Unis, dans la lignée des démarches entreprises par le Canada et par l’Australie en 2008. Un an plus tard, le retour de Donald Trump à la Maison Blanche a marqué un net revirement. Depuis janvier 2025, la nouvelle administration s’emploie à démanteler les avancées obtenues sous Biden et à imposer son propre récit national. Alors que les excuses de 2024 semblaient ouvrir la voie à un dialogue durable, la dynamique actuelle met un frein au processus de réparation historique et alimente les inquiétudes au sein des communautés autochtones.

–

Les excuses officielles présentées, le 25 octobre 2024, aux populations autochtones d’Amérique du Nord par le président Joe Biden, au-delà du baroud d’honneur de fin de mandat, ont inscrit les États-Unis dans un mouvement global de réparation des injustices historiques héritées de la colonisation, entamé dans d’anciennes colonies britanniques comme l’Australie et le Canada dès les années 1970.

Après l’Australie et le Canada en 2008, les États-Unis ont à leur tour reconnu le placement forcé de milliers d’enfants autochtones dans des pensionnats d’État pendant des dizaines d’années, et ainsi commencé à faire une place aux populations amérindiennes dans le récit national.

La reconnaissance des « générations volées » en Australie

En Australie, les Aborigènes sont, depuis l’indépendance du pays en 1901 et la construction d’une nation australienne blanche (politique « White Australia » de restriction de l’immigration non européenne), les grands oubliés de l’histoire du pays.

L’anthropologue australien W. E. H. Stanner aborde la problématique de l’exclusion des peuples autochtones de l’histoire du pays lors d’une conférence en 1968 consacrée au « grand silence australien » concernant l’histoire des Aborigènes en Australie depuis la colonisation britannique, à ce « culte de l’oubli » pratiqué à l’échelle nationale. Dès lors, le débat s’invite tant chez les historiens australiens que dans l’opinion publique, interrogeant la place des peuples autochtones dans le récit national.

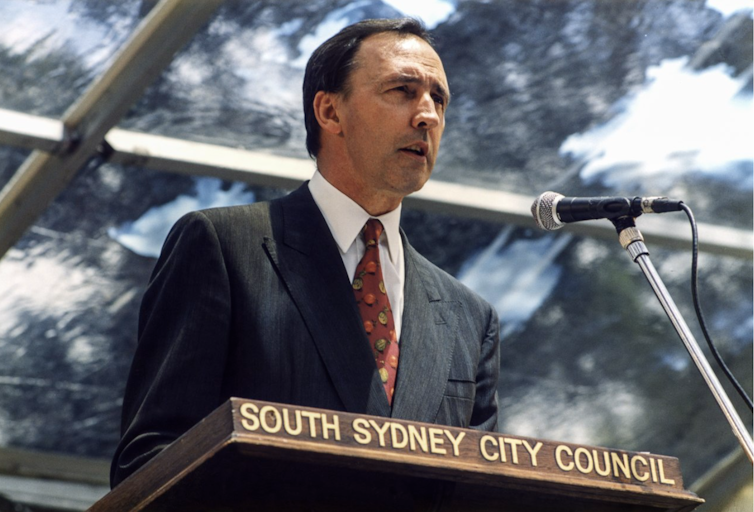

L’année 1992 marque un tournant dans l’attitude observée par le gouvernement australien face aux peuples aborigènes : le premier ministre Paul Keating reconnaît la responsabilité des Australiens non aborigènes dans les crimes commis contre les populations autochtones depuis le début de la colonisation du pays lors du désormais célèbre discours de Redfern.

John Paoloni

Quelques années plus tard, en 1995, le procureur général d’Australie demande l’ouverture d’une enquête nationale sur le placement forcé de milliers d’enfants aborigènes dans des internats religieux gérés par des missionnaires (les « mission schools ») entre les années 1910 et 1970.

Les résultats de l’enquête, publiés en 1997 dans le rapport « Bringing them home », font l’effet d’une bombe dans l’opinion publique australienne, jusqu’alors largement ignorante des souffrances infligées aux familles aborigènes. Les Australiens prennent la mesure de ce que leurs gouvernements successifs ont fait subir aux familles aborigènes : enlèvements d’enfants, adoptions forcées, mauvais traitements, crimes. Jusque dans les années 1970, des milliers d’enfants furent ainsi placés dans les écoles des missionnaires : on les appelle les « générations volées » (« stolen generations »).

Si ces générations volées laissent à partir de la fin du XXe siècle une trace indélébile dans l’histoire du pays qui ne peut désormais plus être ignorée, il faudra cependant attendre 2008 pour que des excuses officielles soient enfin présentées aux Aborigènes par le premier ministre Kevin Rudd.

Les excuses officielles du gouvernement canadien aux Premières Nations

2008 est également l’année des excuses officielles du gouvernement canadien aux populations autochtones du Canada (les Premières Nations, Métis et Inuits) par la voix du premier ministre Stephen Harper.

Ces excuses font suite à la plus grande procédure de recours collectif (« class action ») engagée dans l’histoire du Canada, qui aboutit à l’Indian Residential Schools Settlement Agreement, en 2006, puis à la création d’une commission de réconciliation (Truth and Reconciliation Commission), en 2015. Au Canada, on estime à 150 000 le nombre d’enfants placés dans les pensionnats d’État (« residential schools ») en un peu plus d’un siècle.

De nouvelles excuses officielles sont présentées quelques années plus tard, en 2021, par le premier ministre Justin Trudeau, à l’attention des survivants des pensionnats de la province du Newfoundland et du Labrador, province exclue du discours de Harper en 2008, et de leurs familles.

Le discours de Trudeau intervient alors que le pays est secoué par des révélations macabres liées au traitement inhumain des enfants des Premières Nations dans les pensionnats d’État : au printemps 2021, les restes de 215 enfants sont identifiés sur le site d’une ancienne école de Colombie-Britannique.

À lire aussi :

La découverte d’un charnier d’enfants autochtones rappelle au Canada un sombre passé

D’autres étapes ont jalonné la prise de conscience de l’administration canadienne sur le sort des enfants des Premières Nations, leur octroyant au XXIe siècle une place et une visibilité dans la vie politique et dans le paysage médiatique du pays. Ainsi, les conclusions d’une grande enquête nationale sur les nombreuses disparitions de jeunes filles amérindiennes, publiées en 2019, dressent une liste de recommandations intimant le gouvernement à intégrer les cultures et langues autochtones dans la culture nationale, à mettre en place des actions de réparations et à éduquer le public et les médias.

À lire aussi :

L’action collective réglée, il ne faut pas oublier les histoires des survivants des pensionnats autochtones

Au Canada, comme en Australie, la parole se libère et les histoires se racontent. Afin de s’assurer que l’histoire des Premières Nations ne retombe pas dans l’oubli, des ressources pédagogiques nationales ont été créées à destination des enseignants canadiens pour leur permettre d’intégrer cette part de l’histoire du pays dans leur enseignement.

Le processus de réparation des injustices historiques aux États-Unis

Après la colonisation des territoires nord-américains par les Européens, entamée au début du XVIIe siècle, et surtout de l’expansion des États-Unis entre 1803 et 1890 (la « conquête de l’Ouest »), on estime à environ 240 000 la population survivante d’Amérindiens (Native Americans) à la fin du XIXe siècle.

Décimés par les maladies européennes, les déplacements forcés, les massacres et les guerres, les Amérindiens sont relocalisés de force dans des réserves, sur des territoires souvent stériles et inhospitaliers, forcés à la sédentarisation, et leurs enfants envoyés dans des écoles gérées d’abord par les communautés religieuses et les paroisses, puis par l’État fédéral états-unien.

Entre les années 1870 et 1970, des dizaines de milliers d’enfants autochtones furent placés dans des pensionnats gérés par l’État fédéral (boarding schools). Comme en Australie et au Canada, les enfants y étaient la plupart du temps placés de force et sans le consentement de leurs parents. L’objectif affiché était de « civiliser » les enfants autochtones afin de permettre leur assimilation dans la société blanche américaine.

Il faudra attendre 1978 et l’Indian Child Welfare Act pour que les Amérindiens puissent retrouver leur droit fondamental à décider de l’éducation de leurs enfants. Comme l’a répété le président Biden dans son discours du 25 octobre 2024, cette histoire-là n’est pas enseignée dans les écoles.

Aux États-Unis, le processus de réparation des injustices historiques concernait jusqu’alors les Noirs américains, descendants des millions d’esclaves importés d’Afrique du XVIIe au XIXe siècle, et non les Amérindiens. Il était grand temps de briser le silence assourdissant qui a entouré l’histoire des populations autochtones nord-américaines pendant plus de deux siècles, comme l’a reconnu le président Biden : « Cela aurait dû être fait depuis longtemps. »

À travers le pays apparaissent ainsi les témoignages tant attendus d’un processus de reconnaissance de la face sombre de l’histoire de la conquête de l’Ouest, d’une volonté de réparation, d’une volonté aussi d’en finir avec le mythe du bon cow-boy et du mauvais Indien, créé au XIXe siècle et encore très vivace pendant la majeure partie du XXe siècle. En témoignent l’exposition sur le massacre de Sand Creek (ré)ouverte fin 2022 au musée de l’histoire du Colorado de Denver, ou la mise à jour, la même année, de la section consacrée aux peuples et cultures indigènes du musée d’histoire naturelle de Houston, effectuée en partenariat avec des conseillers issus de tribus amérindiennes.

Sonia Félix-Naix_, Fourni par l’auteur

Un an après : l’histoire états-unienne selon Trump

Les excuses officielles présentées par Joe Biden posèrent la première pierre d’un processus de reconnaissance des souffrances et injustices imposées aux Amérindiens et de leur place dans l’histoire des États-Unis, participant ainsi à une réécriture globale de l’histoire de la colonisation, une histoire alimentée à la fois par de nouvelles considérations pré- et post-coloniales, une histoire différente de celle, hégémonique, jusqu’alors écrite par les colons européens et leurs descendants.

Mais un an plus tard, l’écriture de l’histoire des États-Unis a pris une nouvelle direction avec l’administration Trump. En effet, dans un décret signé le 27 mars 2025 et intitulé « Restoring Truth and sanity to American history » (« Restauration de la vérité et du bon sens dans l’histoire américaine »), le président Trump accuse l’administration Biden d’avoir promu « l’idéologie corrosive » d’un « mouvement révisionniste » qui chercherait à construire une histoire « raciste, sexiste et oppressive » de la nation.

En quelques mois, les pages sombres de l’histoire états-unienne doivent disparaître des sites Internet fédéraux, des monuments et parc nationaux, des grands musées. L’Amérique blanche chrétienne reprend le contrôle sur un récit national qu’elle veut façonner à l’image de ses mythes et en accord avec sa propre version de l’histoire.

![]()

Sonia Félix-Naix ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Un an après les excuses de Biden, les droits des peuples autochtones aux États-Unis à nouveau fragilisés sous Trump – https://theconversation.com/un-an-apres-les-excuses-de-biden-les-droits-des-peuples-autochtones-aux-etats-unis-a-nouveau-fragilises-sous-trump-265812