Source: The Conversation – (in Spanish) – By Rob Morris, Professor of Physics, School of Science and Technology, Nottingham Trent University

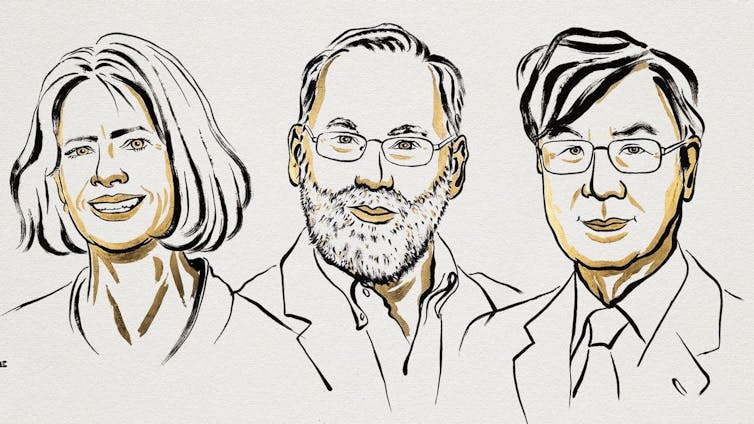

El Premio Nobel de Física 2025 ha sido otorgado a tres científicos por el descubrimiento de un efecto que tiene aplicaciones en dispositivos médicos y computación cuántica.

John Clarke, Michel Devoret y John Martinis llevaron a cabo una serie de experimentos hace unos 40 años que terminaron moldeando nuestra comprensión de las extrañas propiedades del mundo cuántico. Es un premio muy oportuno, ya que en 2025 se cumple el centenario de la formulación de la mecánica cuántica.

En el mundo microscópico, una partícula puede a veces atravesar una barrera y aparecer al otro lado. Este fenómeno se denomina efecto túnel cuántico. Los experimentos de los galardonados demostraron el efecto túnel en el mundo macroscópico, es decir, el mundo visible a simple vista. Y corroboraron que podía observarse en un circuito eléctrico experimental.

El efecto túnel cuántico tiene posibles aplicaciones futuras en la mejora de la memoria de los teléfonos móviles y ha sido importante para el desarrollo de los qubits, que almacenan y procesan información en ordenadores cuánticos. También tiene aplicaciones en dispositivos superconductores, capaces de conducir la electricidad con muy poca resistencia.

John Clarke, nacido en Gran Bretaña, es profesor de Física en la Universidad de California, Berkeley. Michel Devoret nació en París y es profesor F. W. Beinecke de Física Aplicada en la Universidad de Yale. John Martinis es profesor de Física en la Universidad de California, Santa Bárbara.

¿Qué es el efecto túnel cuántico?

El efecto túnel cuántico es un fenómeno contraintuitivo por el cual las diminutas partículas que componen todo lo que podemos ver y tocar pueden aparecer al otro lado de una barrera sólida, que en otras circunstancias se esperaría que las detuviera.

Desde que se propuso por primera vez, en 1927, se ha observado en partículas muy pequeñas y es responsable de nuestra explicación de la desintegración radiactiva de átomos grandes en átomos más pequeños y en algo bautizado como partícula alfa. Sin embargo, también se predijo que podríamos ver este mismo comportamiento en cosas más grandes: es lo que se denomina efecto túnel cuántico macroscópico.

¿Cómo podemos ver el efecto túnel cuántico?

La clave para observar este efecto túnel macroscópico es algo llamado unión Josephson, que consiste en una especie de un cable roto sofisticado. El cable no es un cable típico como el que se utiliza para cargar el teléfono, sino que es un tipo especial de material conocido como superconductor. Un superconductor no tiene resistencia, lo que significa que la corriente puede fluir a través de él indefinidamente sin perder energía. Los superconductores se utilizan, por ejemplo, para crear campos magnéticos muy fuertes en los escáneres de resonancia magnética (RM).

¿Cómo nos ayuda esto a explicar este extraño comportamiento de túnel cuántico? Si colocamos dos cables superconductores uno al lado del otro, separados por un aislante, creamos nuestra unión Josephson. Normalmente se fabrica en un solo dispositivo que, con unos conocimientos básicos de electricidad, no debería conducir la electricidad. Sin embargo, gracias al túnel cuántico, podemos ver que la corriente puede fluir a través de la unión.

Los tres galardonados demostraron el efecto túnel cuántico en un artículo publicado en 1985 (es habitual que transcurra tanto tiempo antes de que se concedan los premios Nobel). Anteriormente se había sugerido que el efecto túnel cuántico estaba causado por una avería en el aislante. Los investigadores comenzaron enfriando su aparato experimental hasta una fracción de grado del cero absoluto, la temperatura más fría que se puede alcanzar.

El calor puede proporcionar a los electrones de los conductores la energía suficiente para atravesar la barrera. Por lo tanto, tendría sentido que cuanto más se enfriara el dispositivo, menos electrones escaparan. Sin embargo, si se produce el efecto túnel cuántico, debería haber una temperatura por debajo de la cual el número de electrones que escapan ya no disminuiría. Los tres galardonados descubrieron precisamente esto.

¿Por qué es importante?

En aquel momento, los tres científicos intentaban demostrar mediante experimentos esta teoría en desarrollo sobre el efecto túnel cuántico macroscópico. Incluso durante el anuncio del premio de 2025, Clarke restó importancia al descubrimiento, a pesar de que ha sido fundamental en muchos avances que se encuentran a la vanguardia de la física cuántica actual.

La computación cuántica sigue siendo una de las oportunidades más interesantes que se vislumbran para un futuro próximo y es objeto de importantes inversiones en todo el mundo. Esto conlleva mucha especulación sobre los riesgos para nuestras tecnologías de cifrado.

También resolverá en última instancia problemas que están fuera del alcance incluso de los superordenadores más grandes de la actualidad. Los pocos ordenadores cuánticos que existen hoy en día se basan en el trabajo de los tres premios Nobel de Física de 2025 y, sin duda, serán objeto de otro premio Nobel de Física en las próximas décadas.

Ya estamos aprovechando estos efectos en otros dispositivos, como los dispositivos superconductores de interferencia cuántica (SQuID), que se utilizan para medir pequeñas variaciones en los campos magnéticos de la Tierra, lo que nos permite encontrar minerales bajo la superficie. Los SQuID también tienen usos en medicina: pueden detectar los campos magnéticos extremadamente débiles que emite el cerebro. Esta técnica, conocida como magnetoencefalografía o MEG, puede utilizarse, por ejemplo, para encontrar el área específica del cerebro desde la que emanan las crisis epilépticas.

No podemos predecir si tendremos ordenadores cuánticos en nuestros hogares, o incluso en nuestras manos, ni cuándo. Sin embargo, una cosa es segura: la velocidad de desarrollo de esta nueva tecnología se debe en gran parte a los ganadores del premio Nobel de Física de 2025, que demostraron el efecto túnel cuántico macroscópico en circuitos eléctricos.

![]()

Rob Morris no recibe salario, ni ejerce labores de consultoría, ni posee acciones, ni recibe financiación de ninguna compañía u organización que pueda obtener beneficio de este artículo, y ha declarado carecer de vínculos relevantes más allá del cargo académico citado.

– ref. Premio Nobel de Física a los experimentos pioneros que allanaron el camino para las computadoras cuánticas – https://theconversation.com/premio-nobel-de-fisica-a-los-experimentos-pioneros-que-allanaron-el-camino-para-las-computadoras-cuanticas-266986