Source: The Conversation – France (in French) – By Carole Avignon, Maîtresse de conférences en Histoire du Moyen Age, Université d’Angers

Au Moyen Âge, le terme « bâtard » ne vaut pas toujours stigmatisation. D’ailleurs, il n’acquiert une pleine valeur d’insulte qu’à partir du XIXe siècle. Par le passé, les expériences sociales de filiations illégitimes sont bien plus complexes qu’on ne l’imagine aujourd’hui, ainsi que le met en évidence le programme de recherche « Filiations, identité, altérité médiévales ».

C’est l’histoire d’un Live Twitch programmé en avril 2025 par la très respectable émission « De l’eau dans le gaz », proposée par Terre des sciences, acteur reconnu de l’écosystème de la médiation scientifique dans les Pays de la Loire.

Puisque le pari de notre programme de recherche Filiations, identité, altérité médiévales (Fil_IAM), soutenu de 2020 à 2025 par l’Agence nationale de la recherche (ANR), fut de proposer le développement d’un prototype de jeu vidéo pour partager des résultats de recherche, pourquoi ne pas mobiliser en effet le canal de partage d’expériences des gamers, la chaîne Twitch ?

Il fallut toutefois en passer par quelques précautions spécifiques au média en ligne, avec ses stratégies de modération propres à l’univers des réseaux sociaux. Nous avons ainsi évité de laisser le mot « bâtard » dans les titres, il nous a fallu prévenir les auditeurs de s’abstenir de commenter le « live » en utilisant le mot « bâtard »…

Dès que les interlocuteurs n’étaient pas expressément acculturés aux champs de recherche en sciences humaines et sociales, voilà que parler de « bâtards », même au Moyen Âge, suscitait une prévention spontanée, une inquiétude, assez vite résolue certes, mais bel et bien palpable…

Tous les quinze jours, nos auteurs plongent dans le passé pour y trouver de quoi décrypter le présent. Et préparer l’avenir. Abonnez-vous gratuitement dès aujourd’hui !

Cette expérience fait ressortir une forme de malentendu, un hiatus entre les canaux usuels de la connaissance historique (colloques, publications universitaires) et les espaces grand public au sein desquels chercheurs et chercheuses peuvent être conviés à partager leurs recherches.

Cela nous invite à réfléchir aux modes de transmission de la science, à la manière dont peuvent se télescoper les codes et les imaginaires de différentes époques et donc au recul et à la remise en perspective qu’apporte la recherche. Que peut nous apporter au XXIe siècle la connaissance des logiques de filiation au Moyen Âge ?

Une grille de lecture complexe

L’anecdote montre que la connotation injurieuse du vocable a la peau dure ! Sans doute aussi le très grand public n’est-il pas toujours bien au clair avec ce que faire de l’histoire veut dire. Car, ici, il s’agit d’étudier en historienne ou historien un statut social, celui des « bâtards », des « fils et filles illégitimes », des « enfants naturels », une variable d’identité, fruit d’une construction juridique enracinée dans les enjeux normatifs et politiques des IXe– XIIIe siècles (celle de l’illégitimité de la filiation).

Il s’agit de considérer les trajectoires sociales de celles et de ceux qui pâtissent des incapacités juridiques et sociales induites qui se déclinent en exclusion du périmètre de l’« hereditas » (incapacité à hériter de ses ascendants – géniteurs non mariés, et à transmettre en dehors des liens construits dans le mariage légitime), exclusion de l’accès aux ordres sacrés de l’Église, de bien des métiers et corporations attachés à l’honorabilité, héritée, de leurs membres, etc.

Mais ce panel d’incapacités ne réduit pas à lui seul la possible grille de lectures de ce que l’illégitimité de la filiation ou « bastardie » a fait aux sociétés médiévales de l’Europe latine.

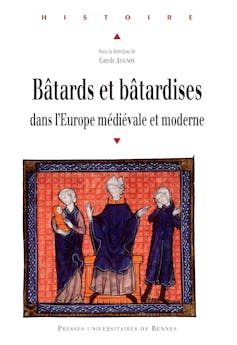

Depuis 2012, j’anime en tant que médiéviste des programmes pluridisciplinaires de recherche pour explorer ce que la filiation illégitime fait à la parenté et comment s’exprime la bâtardise. Avec une quarantaine de spécialistes d’histoire, d’histoire du droit, de démographie historique, de littérature, de civilisation, de linguistique, nous avons proposé en 2016 un cadre problématique dans Bâtards et bâtardises dans l’Europe médiévale et moderne, aux Presses universitaires de Rennes. Nous y avons abordé ce que la bâtardise nous révèle des sociétés passées, ses régimes juridiques, la place des bâtards dans les sociétés d’Ancien Régime, entre stigmatisation, discrimination et intégration.

Parmi les contributions, celle de la professeure des sciences du langage à l’Université Savoie Mont-Blanc Dominique Lagorgette permettait de dresser un panorama des sens et des usages de « bastards » ainsi que de l’expression souvent associée « fils à putain » dans un corpus de textes du Moyen Âge, littéraires et non littéraires. Il s’agissait d’étudier la manière dont ce mot pouvait parcourir l’échelle axiologique. La conclusion était que « bastard » n’avait pas acquis sa valeur d’insulte avant le XIXe siècle, « insulte par ricochet, insultant autrui mais blessant le récepteur ».

Entre stigmatisation et épithète d’honneur

Bien sûr, la potentielle connotation sexuelle de l’usage du mot à fin d’invective n’était pas ignorée dans certains contextes d’énonciation. Bien sûr, la « macule » de « géniture », comme pouvait s’exprimer aussi le fait de ne pas être né de parents mariés conformément aux attentes normatives socialement construites du temps, établissait les soubassements d’un discours sur la souillure et la tache.

C’est sur cette tache qu’est construit le titre choisi par la spécialiste de la bâtardise à l’époque moderne, Sylvie Steinberg, quand elle publie en 2016 un ouvrage de référence pour étudier « par-delà droit et théologie […] la dimension vécue des liens entre enfants et parents ».

À lire aussi :

Non, les enfants n’étaient pas négligés au Moyen Âge : la preuve par l’éducation

La « semence maudite » dénoncée dans le Deutéronome (pour ceux qui ne sont pas alors les « bâtards » du Moyen Âge, pas même encore les « fils de prêtres ») est réinterprétée de texte en texte, déployant les champs sémantiques de l’impureté, de la corruption, de l’incomplétude.

De même le « defectus natalium » qui définit une « irrégularité » dans l’accès à l’ordination des prêtres induit-il une « altération » de la qualité de la naissance comme un « vitium » du corps, ou une incomplétude. De même la promotion pastorale de l’honorabilité du mariage canonique a-t-elle pu être portée par le travail sur le langage de la couche (nuptiale) sans souillure, le « thorus immaculatus » de l’Épître aux Hébreux (Hé., 13).

Mais toute mobilisation du terme « bâtard » ne vaut pas stigmatisation au Moyen Âge. Il sait fonctionner comme un titre, presque une épithète d’honneur dans certaines configurations, en particulier dans les groupes nobiliaires. L’ouvrage de Marie-Lise Fieyre sur les bâtards des Bourbon pourra enrichir la recherche sur les bâtards dans les lignages nobiliaires et princiers.

Un besoin d’historicité

Avec le programme Fil_IAM, il s’agit de renouveler les grilles de lecture des bâtardises médiévales, en mobilisant aussi les apports méthodologiques des « disability studies ». Ainsi l’on saisit des scripts d’incapacité, les enjeux des opérations administrativo-politiques de réhabilitation des fils et filles marqués par une altération de la qualité de leur naissance et plus ou moins entravés dans leur insertion sociale selon d’autres variables (groupe social d’appartenance du père, de la mère, genre, place dans la fratrie, etc.).

Le malentendu s’entend : « bâtards » vaut insulte cuisante aujourd’hui, mais les historiennes et historiens peuvent se saisir de cet objet, en tant qu’il pourrait être effectivement la marque d’une insulte, mais, aussi, en tant qu’il pourrait ne pas l’être…

Les malentendus persistants ont eu le mérite de révéler le besoin d’historicité, de dissémination de savoirs historiques, notamment liés aux époques médiévales, auprès de tous les publics.

Le prototype de jeu vidéo Cap ou pas Cap ? Bandes de bâtards a pour objectif d’éclairer quelques-unes des mécaniques sociales des XIIIe– XVe siècles.

Le titre a été pensé en clin d’œil aux défis de cours d’école (puisque le jeu est pensé en particulier pour prolonger quelques séances de cours d’histoire de 5e), mais aussi pour ouvrir un espace d’interrogations à partager.

Afin de prolonger l’expérience, le programme a également produit une série de podcasts, pour mieux comprendre ce que c’est que faire de l’histoire aujourd’hui, et de l’histoire médiévale en particulier, autour des bâtardes et bâtards du Moyen Âge.

![]()

Carole Avignon a reçu des financements de l’Université d’Angers (soutien de la commission recherche pour son premier programme de recherche F-illégitime) et de l’ANR au titre du programme JCJC (pour le programme Fil_IAM: ANR-19-CE41-0004) et au titre du programme ANR SAPS (UA-Class)

– ref. Parler des bâtards du Moyen Âge en historiens du XXIᵉ siècle : faut-il cacher ce mot que l’on ne saurait voir ? – https://theconversation.com/parler-des-batards-du-moyen-age-en-historiens-du-xxi-siecle-faut-il-cacher-ce-mot-que-lon-ne-saurait-voir-257278