Source: – By Roxanne Panchasi, Associate Professor, Department of History, Simon Fraser University

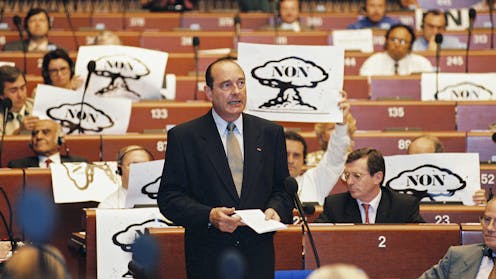

(European Parliament)

Le 13 juin 1995, le président Jacques Chirac annonçait la reprise des essais nucléaires dans le Pacifique Sud. La population de la Polynésie française attend encore une juste indemnisation pour les préjudices subis. En 2021, le président Macron a reconnu que la France avait une « dette » envers le peuple de Maō’hui Nui, appelant à l’ouverture d’archives clés. Une commission d’enquête parlementaire s’est emparée du sujet.

Ces derniers mois, la viabilité de l’arsenal nucléaire français a fait la une des journaux, entraînant des discussions sur un « parapluie nucléaire » français qui pourrait protéger ses alliés sur le continent européen. Face à la guerre entre la Russie et l’Ukraine, et aux déclarations du président russe Vladimir Poutine concernant la possibilité de déployer des armes nucléaires dans ce conflit, la question quant à la meilleure manière de défendre l’Europe crée une urgence inédite depuis l’époque la plus tendue de la guerre froide.

Malgré ses capacités nucléaires plus solides, les États-Unis, sous l’ère Donald Trump, semblent moins engagés dans la défense de leurs alliés de l’OTAN. Les débats sur le parapluie nucléaire français mis à part, ces discussions – combinées à l’augmentation des dépenses militaires dans le monde entier et à la résurgence des craintes d’une guerre nucléaire – rendent l’histoire française de la préparation nucléaire et de ses essais d’armes, douloureusement contemporaine.

Le 13 juin 1995, le président Jacques Chirac a annoncé que la France allait reprendre ses essais nucléaires dans le Pacifique Sud. Quelques semaines seulement après son élection, Jacques Chirac a mis fin à un moratoire de trois ans sur les essais que son prédécesseur, François Mitterrand, avait mis en place en avril 1992.

Jacques Chirac a insisté sur le fait que cette nouvelle série d’essais nucléaires était essentielle à la sécurité nationale de la France et au maintien de l’indépendance de sa force de dissuasion nucléaire. Les huit essais prévus au cours des mois suivants fourniraient, selon lui, les données nécessaires pour passer des explosions réelles à de futures simulations informatiques. Il a également déclaré que cela permettrait à la France de signer le Traité d’interdiction complète des essais nucléaires (CTBT) interdisant toutes les explosions nucléaires, à des fins militaires ou autres, d’ici à l’automne 1996.

L’histoire des essais nucléaires en France

L’annonce faite par Jacques Chirac en juin 1995, suivie de la première nouvelle explosion en septembre de la même année, a suscité une vive opposition de la part des groupes écologistes et des pacifistes, ainsi que des protestations allant de Paris à Papeete, à travers la région Pacifique et dans le monde entier.

Des représentants des autres puissances nucléaires mondiales ont exprimé leur inquiétude face à la décision de la France de mener de nouveaux essais si près de l’entrée en vigueur d’une interdiction complète. Les gouvernements de l’Australie, de la Nouvelle-Zélande et du Japon ont également manifesté leur ferme opposition, en publiant des déclarations diplomatiques, ainsi qu’en appelant au boycott des produits français et en mettant en œuvre d’autres mesures de rétorsion.

Une posture défensive a constitué un pilier de la politique française en matière d’armement nucléaire depuis l’entrée du pays dans le club atomique en 1960, avec la détonation de « Gerboise Bleue », une bombe de 70 kilotonnes, à Reggane, en Algérie. Les trois essais atmosphériques suivants ainsi que les treize essais souterrains réalisés au Sahara ont entraîné de graves conséquences sanitaires et environnementales à long terme pour les populations de la région.

En 1966, le programme d’essais nucléaires de la France fut transféré à Maō’hui Nui, connue sous le nom colonial de « Polynésie française ».

Au cours des 26 années suivantes, 187 détonations nucléaires et thermonucléaires françaises supplémentaires furent réalisées, en surface et en souterrain, sur les atolls pacifiques de Moruroa et Fangataufa. Ces essais ont exposé la population locale à des niveaux dangereux de radiation, contaminé les réserves alimentaires et en eau, endommagé les coraux ainsi que d’autres formes de vie marine.

Ces expériences – ainsi que les six dernières détonations souterraines menées par la France en 1995 et 1996 – ont laissé un héritage toxique pour les générations futures.

Des préjudices persistants, une indemnisation insuffisante

Lorsque Jacques Chirac a exposé ses raisons pour la nouvelle série d’essais nucléaires de la France devant une salle pleine de journalistes réunis au palais de l’Élysée en juin 1995, il a insisté sur le fait que ces essais prévus, ainsi que toutes les détonations nucléaires françaises, n’avaient absolument aucune conséquence écologique.

Aujourd’hui, nous savons que cette affirmation était bien plus qu’inexacte. Il s’agissait d’un mensonge fondé sur des données et des conclusions qui ont gravement sous-estimé les effets néfastes du programme d’essais nucléaires français sur la santé des soldats français et du personnel non militaire présents sur les sites, sur les habitants des zones environnantes, ainsi que sur les environnements où ces explosions ont eu lieu.

Du lundi au vendredi + le dimanche, recevez gratuitement les analyses et décryptages de nos experts pour un autre regard sur l’actualité. Abonnez-vous dès aujourd’hui !

Plus récemment, lors des Jeux olympiques de Paris 2024, il était difficile de ne pas ressentir l’évidente contradiction entre la « Polynésie française » en tant que paradis touristique et lieu idyllique pour les compétitions de surf, et celle d’un territoire marqué par l’injustice persistante envers les victimes des essais nucléaires – une réalité qui met en lumière l’histoire de l’impérialisme nucléaire de la France dans la région.

En 2010, le gouvernement français a adopté la loi Morin censée répondre à la souffrance des personnes gravement affectées par les radiations lors des détonations nucléaires françaises entre 1960 et 1996.

Le nombre de personnes ayant obtenu une reconnaissance et une indemnisation reste insuffisant, en particulier en Algérie. Sur les 2 846 demandes déposées – émanant seulement d’une fraction des milliers de victimes estimées – un peu plus de 400 personnes à Maō’hui Nui et une seule en Algérie ont été indemnisées depuis 2010.

En 2021, le président Emmanuel Macron a reconnu que la France avait une « dette » envers le peuple de Maō’hui Nui. Il a depuis appelé à l’ouverture d’archives clés liées à cette histoire, mais de nombreux efforts restent à faire sur tous les fronts.

Les conclusions d’une récente commission parlementaire française sur les effets des essais dans le Pacifique, dont la publication est prévue prochainement, pourraient contribuer à une plus grande transparence et à une meilleure justice pour les victimes à l’avenir.

À Maʻohi Nui, les demandes de reconnaissance et de réparation sont étroitement liées au mouvement indépendantiste, tandis que l’impact et l’héritage des explosions nucléaires en Algérie restent une source de tensions persistantes avec la France, d’autant plus liée à son passé colonial.

L’avenir du traité d’interdiction des essais nucléaires

En janvier 1996, la France a procédé à son dernier essai nucléaire en faisant exploser une bombe de 120 kilotonnes sous terre dans le Pacifique Sud. En septembre de la même année, elle a signé le Traité d’interdiction complète des essais nucléaires (TICE), rejoignant les États-Unis, la Russie, le Royaume-Uni, la Chine et 66 autres États non dotés d’armes nucléaires dans leur engagement à ne plus effectuer d’explosions nucléaires, quel qu’en soit le motif.

Près de 30 ans plus tard, le TICE n’est toujours pas entré en vigueur. Bien que la majorité des signataires l’aient ratifié, la Chine, l’Égypte, l’Iran, Israël et les États-Unis figurent parmi les neuf pays qui ne l’ont pas encore fait. Par ailleurs, la Russie a retiré sa ratification en 2023. Parmi les principaux non-signataires se trouvent l’Inde, la Corée du Nord et le Pakistan – trois États dotés de l’arme nucléaire ayant mené leurs propres essais depuis 1996.

En raison de ces exceptions majeures à l’interdiction des essais, les perspectives d’un projet aussi ambitieux que le Traité sur l’interdiction des armes nucléaires de 2017, qu’aucun État possédant l’arme nucléaire n’a signé à ce jour, restent pour le moins incertaines.

![]()

Roxanne Panchasi a reçu des financements du Conseil de recherches en sciences humaines du Canada (CRSH).

– ref. Trente ans après les derniers essais nucléaires français en Polynésie, un héritage toxique – https://theconversation.com/trente-ans-apres-les-derniers-essais-nucleaires-francais-en-polynesie-un-heritage-toxique-258994