Source: The Conversation – France in French (2) – By Michael Falk, Senior Lecturer in Digital Studies, The University of Melbourne

Des mythes antiques à la tête parlante du pape, de Prométhée aux algorithmes modernes, l’intelligence artificielle (IA) puise dans notre fascination intemporelle pour la création et le pouvoir de la connaissance.

Il semble que l’engouement pour l’intelligence artificielle (IA) ait donné naissance à une véritable bulle spéculative. Des bulles, il y en a déjà eu beaucoup, de la tulipomanie du XVIIe siècle à celle des subprimes du XXIe siècle. Pour de nombreux commentateurs, le précédent le plus pertinent aujourd’hui reste la bulle Internet des années 1990. À l’époque, une nouvelle technologie – le World Wide Web – avait déclenché une vague d’« exubérance irrationnelle ». Les investisseurs déversaient des milliards dans n’importe quelle entreprise dont le nom contenait « .com ».

Trois décennies plus tard, une autre technologie émergente déclenche une nouvelle vague d’enthousiasme. Les investisseurs injectent à présent des milliards dans toute entreprise affichant « IA » dans son nom. Mais il existe une différence cruciale entre ces deux bulles, qui n’est pas toujours reconnue. Le Web existait. Il était bien réel. L’intelligence artificielle générale, elle, n’existe pas, et personne ne sait si elle existera un jour.

En février, le PDG d’OpenAI, Sam Altman, écrivait sur son blog que les systèmes les plus récents commencent tout juste à « pointer vers » l’IA dans son acception « générale ». OpenAI peut commercialiser ses produits comme des « IA », mais ils se réduisent à des machines statistiques qui brassent des données, et non des « intelligences » au sens où on l’entend pour un être humain.

Pourquoi, dès lors, les investisseurs sont-ils si prompts à financer ceux qui vendent des modèles d’IA ? L’une des raisons tient peut-être au fait que l’IA est un mythe technologique. Je ne veux pas dire par là qu’il s’agit d’un mensonge, mais que l’IA convoque un récit puissant et fondateur de la culture occidentale, celui des capacités humaines de création. Peut-être les investisseurs sont-ils prêts à croire que l’IA est pour demain, parce qu’elle puise dans des mythes profondément ancrés dans leur imaginaire ?

Le mythe de Prométhée

Le mythe le plus pertinent pour penser l’IA est celui de Prométhée, issu de la Grèce antique. Il en existe de nombreuses versions, mais les plus célèbres se trouvent dans les poèmes d’Hésiode, la Théogonie et les Travaux et les Jours, ainsi que dans la pièce Prométhée enchaîné, traditionnellement attribuée à Eschyle.

Prométhée était un Titan, un dieu du panthéon grec antique. C’était aussi un criminel, coupable d’avoir dérobé le feu à Héphaïstos, le dieu forgeron. Dissimulé dans une tige de fenouil, le feu fut apporté sur Terre par Prométhée, qui l’offrit aux humains. Pour le punir, il fut enchaîné à une montagne, où un aigle venait chaque jour lui dévorer le foie.

Le don de Prométhée n’était pas seulement celui du feu ; c’était celui de l’intelligence. Dans Prométhée enchaîné, il affirme qu’avant son don, les humains voyaient sans voir et entendaient sans entendre. Après celui-ci, ils purent écrire, bâtir des maisons, lire les étoiles, pratiquer les mathématiques, domestiquer les animaux, construire des navires, inventer des remèdes, interpréter les rêves et offrir aux dieux des sacrifices appropriés.

Le mythe de Prométhée est un récit de création d’un genre particulier. Dans la Bible hébraïque, Dieu ne confère pas à Adam le pouvoir de créer la vie. Prométhée, en revanche, transmet aux humains une part du pouvoir créateur des dieux.

Hésiode souligne cet aspect du mythe dans la Théogonie. Dans ce poème, Zeus ne punit pas seulement Prométhée pour le vol du feu ; il châtie aussi l’humanité. Il ordonne à Héphaïstos d’allumer sa forge et de façonner la première femme, Pandore, qui déchaîne le mal sur le monde. Or le feu qu’Héphaïstos utilise pour créer Pandore est le même que celui que Prométhée a offert aux humains.

Wikimedia

Les Grecs ont avancé l’idée que les humains sont eux-mêmes une forme d’intelligence artificielle. Prométhée et Héphaïstos recourent à la technique pour fabriquer les hommes et les femmes. Comme le montre l’historienne Adrienne Mayor dans son ouvrage Gods and Robots, les Anciens représentaient souvent Prométhée comme un artisan, utilisant des outils ordinaires pour créer des êtres humains dans un atelier tout aussi banal.

Si Prométhée nous a donné le feu des dieux, il semble logique que nous puissions utiliser ce feu pour fabriquer nos propres êtres intelligents. De tels récits abondent dans la littérature grecque antique, de l’inventeur Dédale, qui créa des statues capables de prendre vie, à la magicienne Médée, qui savait rendre la jeunesse et la vigueur grâce à ses drogues ingénieuses. Les inventeurs grecs ont également conçu des calculateurs mécaniques pour l’astronomie ainsi que des automates remarquables, mues par la gravité, l’eau et l’air.

Le pape et le chatbot

Deux mille sept cents ans se sont écoulés depuis qu’Hésiode a consigné pour la première fois le mythe de Prométhée. Au fil des siècles, ce récit a été repris sans relâche, en particulier depuis la publication, en 1818, de Frankenstein ; ou le Prométhée moderne de Mary Shelley.

Mais le mythe n’est pas toujours raconté comme une fiction. Voici deux exemples historiques où le mythe de Prométhée semble s’être incarné dans la réalité.

Gerbert d’Aurillac fut le Prométhée du Xe siècle. Né au début des années 940 de notre ère, il étudia à l’abbaye d’Aurillac avant de devenir moine à son tour. Il entreprit alors de maîtriser toutes les branches du savoir connues de son temps. En 999, il fut élu pape. Il mourut en 1003 sous son nom pontifical de Sylvestre II.

Des rumeurs sur Gerbert se répandirent rapidement à travers l’Europe. Moins d’un siècle après sa mort, sa vie était déjà devenue légendaire. L’une des légendes les plus célèbres, et la plus pertinente à l’ère actuelle de l’engouement pour l’IA, est celle de la « tête parlante » de Gerbert. Cette légende fut racontée dans les années 1120 par l’historien anglais Guillaume de Malmesbury dans son ouvrage reconnu et soigneusement documenté, la Gesta Regum Anglorum (Les actions des rois d’Angleterre).

Gerbert possédait des connaissances approfondies en astronomie, une science de la prévision. Les astronomes pouvaient utiliser l’astrolabe pour déterminer la position des étoiles et prévoir des événements cosmiques, comme les éclipses. Selon Guillaume, Gerbert aurait mis son savoir en astronomie au service de la création d’une tête parlante. Après avoir observé les mouvements des étoiles et des planètes, il aurait façonné une tête en bronze capable de répondre à des questions par « oui » ou par « non ».

Gerbert posa d’abord la question : « Deviendrai-je pape ? »

« Oui », répondit la tête.

Puis il demanda : « Mourrai-je avant d’avoir célébré la messe à Jérusalem ? »

« Non », répondit la tête.

Dans les deux cas, la tête avait raison, mais pas comme Gerbert l’avait prévu. Il devint bien pape et évita judicieusement de partir en pèlerinage à Jérusalem. Un jour cependant, il célébra la messe à la basilique Sainte-Croix-de-Jérusalem à Rome. Malheureusement pour lui, la basilique était alors simplement appelée « Jérusalem ».

Gerbert tomba malade et mourut. Sur son lit de mort, il demanda à ses serviteurs de découper son corps et de disperser les morceaux, afin de rejoindre son véritable maître, Satan. De cette manière, il fut, à l’instar de Prométhée, puni pour avoir volé le feu.

Wikimedia

C’est une histoire fascinante. On ne sait pas si Guillaume de Malmesbury y croyait vraiment. Mais il s’est bel et bien efforcé de persuader ses lecteurs que cela était plausible. Pourquoi ce grand historien, attaché à la vérité, aurait-il inséré une légende fantaisiste sur un pape français dans son histoire de l’Angleterre ? Bonne question !

Est-ce si extravagant de croire qu’un astronome accompli puisse construire une machine de prédiction à usage général ? À l’époque, l’astronomie était la science de la prédiction la plus puissante. Guillaume, sobre et érudit, était au moins disposé à envisager que des avancées brillantes en astronomie pourraient permettre à un pape de créer un chatbot intelligent.

Aujourd’hui, cette même possibilité est attribuée aux algorithmes d’apprentissage automatique, capables de prédire sur quelle publicité vous cliquerez, quel film vous regarderez ou quel mot vous taperez ensuite. Il est compréhensible que nous tombions sous le même sortilège.

L’anatomiste et l’automate

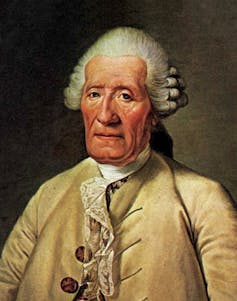

Le Prométhée du XVIIIe siècle fut Jacques de Vaucanson, du moins si l’on en croit Voltaire :

Le hardi Vaucanson, rival de Prométhée,

Semblait, de la nature imitant les ressorts

Prendre le feu des cieux pour animer les corps.

Wikimedia

Vaucanson était un grand mécanicien, célèbre pour ses automates, des dispositifs à horlogerie reproduisant de manière réaliste l’anatomie humaine ou animale. Les philosophes de l’époque considéraient le corps comme une machine – alors pourquoi un mécanicien n’aurait-il pu en construire une ?

Parfois, les automates de Vaucanson avaient aussi une valeur scientifique. Il construisit par exemple un « Flûteur automate » doté de lèvres, de poumons et de doigts, capable de jouer de la flûte traversière de façon très proche de celle d’un humain. L’historienne Jessica Riskin explique dans son ouvrage The Restless Clock que Vaucanson dut faire d’importantes découvertes en acoustique pour que son flûtiste joue juste.

Parfois, ses automates étaient moins scientifiques. Son « Canard digérateur » connut un immense succès, mais se révéla frauduleux. Il semblait manger et digérer de la nourriture, mais ses excréments étaient en réalité des granulés préfabriqués dissimulés dans le mécanisme.

Vaucanson consacra des décennies à ce qu’il appelait une « anatomie en mouvement ». En 1741, il présenta à l’Académie de Lyon un projet visant à construire une « imitation de toutes les opérations animales ». Vingt ans plus tard, il s’y remit. Il obtint le soutien du roi Louis XV pour réaliser une simulation du système circulatoire et affirma pouvoir construire un corps artificiel complet et vivant.

Wikimedia

Il n’existe aucune preuve que Vaucanson ait jamais achevé un corps entier. Finalement, il ne put tenir la promesse que soulevait sa réputation. Mais beaucoup de ses contemporains croyaient qu’il en était capable. Ils voulaient croire en ses mécanismes magiques. Ils souhaitaient qu’il s’empare du feu de la vie.

Si Vaucanson pouvait fabriquer un nouveau corps humain, ne pourrait-il pas aussi en réparer un existant ? C’est la promesse de certaines entreprises d’IA aujourd’hui. Selon Dario Amodei, PDG d’Anthropic, l’IA permettra bientôt aux gens « de vivre aussi longtemps qu’ils le souhaitent ». L’immortalité semble un investissement séduisant.

Sylvestre II et Vaucanson furent de grands maîtres de la technologie, mais aucun des deux ne fut un Prométhée. Ils ne volèrent nul feu aux dieux. Les aspirants Prométhée de la Silicon Valley réussiront-ils là où leurs prédécesseurs ont échoué ? Si seulement nous avions la tête parlante de Sylvestre II, nous pourrions le lui demander.

![]()

Michael Falk a reçu des financements de l’Australian Research Council.

– ref. Du chatbot du pape au canard de Vaucanson, les croyances derrière l’intelligence artificielle ne datent pas d’hier – https://theconversation.com/du-chatbot-du-pape-au-canard-de-vaucanson-les-croyances-derriere-lintelligence-artificielle-ne-datent-pas-dhier-272357