Source: The Conversation – in French – By Xénia Philippenko, Maîtresse de conférences en Géographie humaine, Université Littoral Côte d’Opale

À quelle hauteur la mer va-t-elle s’élever à cause du changement climatique ? On peut répondre à cette question en moyenne, avec des estimations et en prenant des hypothèses, mais fournir une réponse précise à l’échelle d’une commune littorale donnée n’a rien d’évident. Plutôt que de répondre par les chiffres, certains projets misent sur d’autres outils, mêlant pédagogie, interactivité et narration.

L’océan fait partie des milieux les plus impactés par le changement climatique. L’élévation du niveau de la mer, en particulier, soumet les populations côtières à des défis toujours plus importants. Par exemple, la salinisation des sols, des sous-sols et des nappes phréatiques ou l’augmentation des risques du submersion sur les littoraux.

En France, de nombreux élus, gestionnaires, entreprises ou habitants du littoral se questionnent sur l’ampleur du phénomène : de combien de centimètres le niveau de la mer va-t-il monter ?

Or, cette hausse dépend de nombreux facteurs. Les scientifiques se demandent comment expliquer un phénomène aussi complexe et entouré d’incertitudes. Comment traduire les données issues des modèles climatiques en outils compréhensibles, utiles et engageants pour le grand public, les décideurs, ou les enseignants ?

C’est le défi que relèvent de nombreux chercheurs et communicants, en développant des dispositifs de « traduction des données », ou data translation : rendre lisible la science sans la trahir.

Le projet européen PROTECT, auquel nous avons participé, porte sur la cryosphère continentale (l’ensemble des glaces sur les continents) et l’élévation du niveau de la mer.

Le site interactif Sea Level Projection Tool, développé dans ce cadre, illustre parfaitement ce concept. Produit par une équipe pluridisciplinaire de scientifiques, informaticiens, communicants, designers et illustrateurs, et rédigé en anglais pour s’adresser à un large public européen et international, il s’appuie sur trois approches complémentaires : la pédagogie, l’interactivité et la narration concrète.

Expliquer avec pédagogie l’élévation du niveau de la mer

Le niveau de la mer évolue sous l’effet de nombreux facteurs. Certains sont environnementaux et directement liés au changement climatique : la fonte des glaciers et des calottes glaciaires (ces vastes masses de glace qui recouvrent des régions entières, comme le Groenland ou l’Antarctique), ainsi que la dilatation thermique des océans provoquée par la hausse des températures entraînent une augmentation du volume de l’eau.

D’autres facteurs sont d’ordre géologique, comme l’affaissement ou le soulèvement localisé des terres émergées. Les causes climatiques, enfin, dépendent directement des décisions politiques : selon que l’on s’oriente vers une transition avec moins d’émissions ou bien vers un futur qui priorise la croissance économique, les trajectoires futures du niveau de la mer varieront considérablement.

Le site Sea Level Projection Tool propose d’expliquer ces différents phénomènes dans un glossaire illustré. Celui-ci s’appuie sur les définitions du Groupe d’experts intergouvernemental sur l’évolution du climat (Giec), mais il propose également d’autres formats plus facilement compréhensibles pour le grand public.

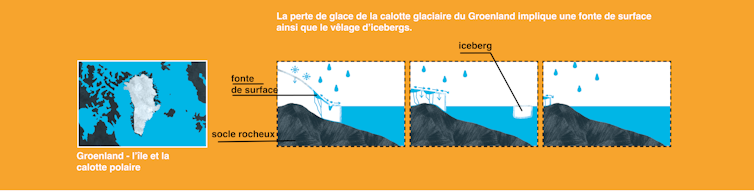

Une illustratrice spécialisée en sciences, Clémence Foucher, a réalisé des visuels facilitant la compréhension des phénomènes liés à l’élévation du niveau de la mer. Par exemple, la dilatation thermique (c’est-à-dire, le fait que la hausse de température engendre une augmentation du volume de l’eau) ou la fonte des glaciers et des calottes glaciaires.

Clémence Foucher/Sea Level Projection Tool, Fourni par l’auteur

Ces illustrations nourrissent un cours illustré où l’on découvre les principaux contributeurs aux variations du niveau marin ainsi que les processus physiques associés – fonte, vêlage (séparation d’une masse de glace formant des icebergs), etc.

À chaque fois que cela est possible, une vidéo explicative est également proposée pour approfondir le sujet en moins de cinq minutes.

À lire aussi :

Une nouvelle méthode pour évaluer l’élévation du niveau de la mer

Développer l’aspect ludique et interactif

Pour mieux comprendre les causes et les impacts de la montée du niveau de la mer, le site propose un outil interactif qui permet à chacun de simuler les effets de différentes composantes : fonte des glaciers, expansion thermique des océans, etc. Chacun de ces phénomènes affecte le niveau marin de façon différente selon les régions du globe.

Par exemple, la fonte du Groenland provoque une redistribution de masse si importante qu’elle modifie la gravité terrestre, entraînant une montée des eaux plus marquée dans des régions éloignées de la source de fonte.

De même, certaines zones, comme le nord de l’Europe, s’élèvent encore aujourd’hui sous l’effet de la fonte des glaces en Europe à la fin de la dernière glaciation, tandis que d’autres, comme certaines côtes américaines, s’enfoncent.

En jouant avec ces différents paramètres, les utilisateurs peuvent explorer comment leurs effets se combinent et pourquoi certaines zones sont plus touchées que d’autres. Une manière ludique et pédagogique de s’approprier une réalité complexe, aux conséquences très concrètes.

Des narratifs pour raconter l’impact de la montée des eaux

Comprendre l’élévation du niveau de la mer est un premier pas important. Mais cela reste souvent déconnecté de la réalité des individus, qui ont du mal à se représenter ses conséquences concrètes.

Une section du site propose ainsi des cas fictifs, s’inspirant de situations réellement vécues dans trois pays différents : la France, les Pays-Bas et les Maldives.

Les conséquences liées à l’élévation du niveau de la mer sont assez similaires quelle que soit la région du monde (inondations, érosion, salinisation des sols et des nappes d’eau), mais chaque pays fait face à des défis particuliers et choisit de s’y adapter de manière différente.

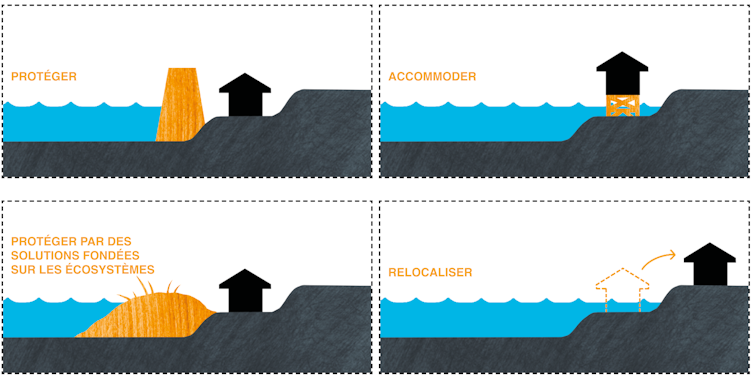

Les scientifiques distinguent plusieurs types de mesures d’adaptation à l’élévation du niveau de la mer :

-

maintenir le trait de côte en place en le protégeant ou gagnant même du terrain sur la mer,

-

adapter les infrastructures, par exemple à travers des maisons sur pilotis qui résistent mieux aux inondations ;

-

accompagner les processus naturels, à travers des solutions fondées sur la nature

-

ou à travers une relocalisation des infrastructures laissant le trait de côte reculer.

Clémence Foucher/Sea Level Projection Tool, Fourni par l’auteur

Les trois cas d’études choisis reprennent le même format : une présentation des enjeux (infrastructures, habitations, activités économiques, etc.), les choix de scénarios d’élévation du niveau de la mer – à court, moyen ou long terme et plus ou moins pessimiste – et enfin les solutions d’adaptation envisagées ou déjà mise en place.

Aux Pays-Bas par exemple, les enjeux sont très forts : un quart du territoire étant déjà sous le niveau marin et la culture de lutte contre la mer est ancienne. Le choix est donc fait de protéger les espaces littoraux par de lourdes infrastructures, comme des barrières estuariennes. Ces infrastructures sont tout à la fois des écluses, des ponts, des digues et des routes.

Clémence Foucher/Sea Level Projection Tool, Fourni par l’auteur

Aux Maldives, la survie du pays insulaire est menacée face à l’élévation du niveau de la mer. De nombreuses solutions se développent : protection par des digues, accommodation des bâtiments, construction de nouvelles îles plus hautes, voire de maisons flottantes.

En France, dans certains territoires, les enjeux restent relativement limités ; ce qui permet d’ouvrir des espaces à la mer en reculant les infrastructures. Par exemple, la commune de Quiberville-sur-Mer, recule son camping pour le mettre à l’abri des inondations.

Ces trois exemples illustrent la diversité des situations, ainsi que la nécessité de bien comprendre le phénomène d’élévation du niveau de la mer et de choisir le scénario adapté à sa situation pour déterminer les mesures d’adaptation.

À lire aussi :

Élévation du niveau de la mer : quels littoraux voulons-nous pour demain ?

Comprendre pour mieux agir face

Face à un phénomène global aux causes multiples et aux conséquences variables en fonction des régions, la compréhension de l’élévation du niveau de la mer ne saurait se limiter à une seule courbe ou à quelques chiffres. Elle nécessite d’explorer des données complexes, d’articuler des scénarios incertains, et surtout de rendre ces connaissances accessibles à celles et ceux qui devront s’y adapter.

Le Sea Level Projection Tool incarne cette démarche de data translation, en combinant rigueur scientifique, narration accessible, interactivité et dimension territoriale. Il s’adresse aussi bien aux citoyens curieux qu’aux enseignants, aux décideurs ou aux jeunes générations, en leur offrant les clés pour mieux comprendre les choix qui s’offrent à nous. Car plus que jamais, comprendre le changement, c’est déjà s’y préparer.

Les auteurs adressent leurs remerciements à Aimée Slangen, à l’équipe informatique du BRGM et à Clémence Foucher.

![]()

Xénia Philippenko a reçu des financement du programme de recherche et d’innovation Horizon 2020 de l’Union européenne dans le cadre de la convention de subvention n° 869304, dans le cadre du programme de recherche PROTECT.

Anne Chapuis a reçu des financement du programme de recherche et d’innovation Horizon 2020 de l’Union européenne dans le cadre de la convention de subvention n° 869304, dans le cadre du programme de recherche PROTECT.

Gaël Durand a reçu des financements du programme de recherche et d’innovation Horizon 2020 de l’Union européenne dans le cadre de la convention de subvention n° 869304, dans le cadre du programme de recherche PROTECT.

Gonéri Le Cozannet a reçu des financements du programme de recherche et d’innovation Horizon 2020 de l’Union européenne dans le cadre de la convention de subvention n° 869304, dans le cadre du programme de recherche PROTECT.

Rémi Thiéblemont a reçu des financements du programme de recherche et d’innovation Horizon 2020 de l’Union européenne dans le cadre de la convention de subvention n° 869304, dans le cadre du programme de recherche PROTECT.

– ref. Élévation du niveau de la mer : comment « traduire » la science pour la rendre accessible et utile à tous ? – https://theconversation.com/elevation-du-niveau-de-la-mer-comment-traduire-la-science-pour-la-rendre-accessible-et-utile-a-tous-258723