Source: The Conversation – France in French (2) – By Sean McMahon, Reader in Astrobiology, University of Edinburgh

Les analyses d’une roche trouvée sur Mars par le rover Perseverance ont été publiées hier dans la revue Nature. Si ces taches auraient pu être créées par une activité microbienne, ces observations ne sont en fait que le début d’une longue enquête… qui nécessite de ramener la roche sur Terre.

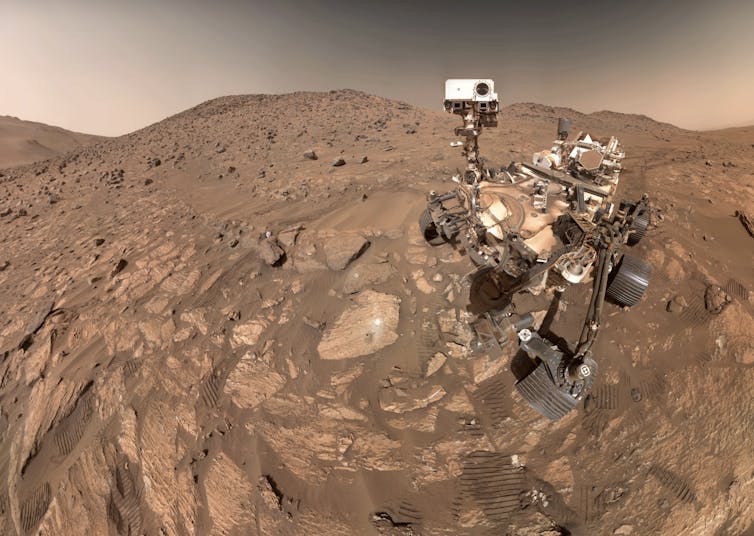

Il y a un peu plus d’un an, la NASA a fait une grande annonce : le rover Perseverance, qui explore la surface de Mars, avait trouvé des signes potentiels d’une vie ancienne sur Mars. Les détails de cette découverte ont maintenant été évalués par les pairs et publiés dans la revue Nature. Un article qui, malgré sa formulation plutôt modeste, pourrait finalement s’avérer être l’un des plus importants de l’histoire des sciences.

Pour faire court : ces traces pourraient être des signes de vie passée, mais il faudrait ramener les échantillons sur Terre pour en être sûrs. Le rover Perseverance a collecté et analysé un fragment de la roche en question… il ne reste plus qu’à aller le chercher.

Et une mission visant à se rendre sur Mars, à récupérer les échantillons de roche collectés par Perseverance et à les ramener sur Terre a été élaborée par la NASA et l’Agence spatiale européenne — ceci inclut l’échantillon de roche qui fait l’objet de l’étude publiée dans Nature. Mais cette mission, Mars Sample Return, rencontre des difficultés en raison de l’augmentation des coûts de la mission ([ndlr : et le budget proposé en mars 2025 par le président Trump n’inclut pas cette mission]).

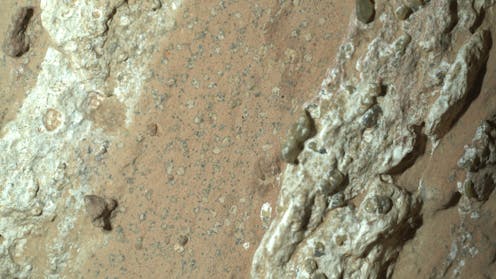

Au milieu de l’année 2024, le rover Perseverance a découvert un bloc de mudstone ancien, une roche sédimentaire composée à l’origine d’argile ou de boue, surnommée Cheyava Falls, qui se distingue par sa teinte rouge brique. Cette roche a été déposée par l’eau il y a environ quatre milliards d’années.

Alors que la plupart des roches martiennes sont rouges à cause d’une couche de poussière d’oxyde de fer, Cheyava Falls est rouge jusqu’à son cœur : l’oxyde de fer se trouve dans la roche elle-même.

Plus intriguant encore, Cheyava Falls est parsemée de douzaines de minuscules taches pâles, de tailles généralement inférieures à un millimètre. Ces taches sont bordées d’un minéral sombre, riche en phosphore, qui apparaît également sous forme de minuscules points dispersés entre les autres taches et que l’on appelle « graines de pavot ». Ce minéral plus sombre est associé à des traces d’anciens composés organiques : des composés qui contiennent du carbone et qui sont essentiels à la vie sur Terre… mais qui existent également en l’absence de vie et d’activité biologique.

Quel est le rapport avec la vie ?

Tous les organismes vivants sur Terre collectent l’énergie grâce à des réactions d’oxydoréduction (réactions redox) qui transfèrent des électrons entre des substances chimiques appelées réducteurs (qui cèdent des électrons) et d’autres, appelées oxydants (qui les acceptent).

Sur Terre par exemple, dans les cellules animales, des structures appelées « mitochondries » transfèrent des électrons du glucose (un réducteur) à l’oxygène (un oxydant). Certaines bactéries vivant dans les roches utilisent d’autres types de composés organiques à la place du glucose et, à la place de l’oxygène, de l’oxyde ferrique (un type d’oxyde de fer aux quel il manque trois électrons par rapport au métal fer).

NASA JPL-Caltech

Lorsque l’oxyde ferrique est réduit en un autre oxyde de fer appelé oxyde ferreux (il ne manque plus que deux électrons par rapport au métal fer), il devient soluble dans l’eau. Il peut ensuite être dispersé ou réagir pour former de nouveaux minéraux, de couleur plus claire.

Il en résulte que de nombreuses roches et sédiments rouges sur Terre contiennent de petites taches blanchies, appelées « taches de réduction », qui ressemblent de manière frappante à celles trouvées à Cheyava Falls.

Sur Mars, Perseverance a également repéré des caractéristiques blanchies encore plus évocatrices de taches de réduction sur un site appelé Serpentine Rapids. Malheureusement, le rover n’y a passé que trop peu de temps pour les analyser et n’a prélevé aucun échantillon.

Le nouvel article développe des résultats présentés lors de la Lunar and Planetary Science Conference de Houston (États-Unis) en mars 2025, avec plus de détails. Pour être publiés dans Nature, les résultats ont été évalués par des pairs (d’autres chercheurs spécialistes du domaine), ce qui ajoute du crédit à l’annonce de la NASA. Ainsi, la nouvelle publication confirme que les taches pâles sont associées à des matières organiques et qu’elles contiennent du fer ferreux et du soufre, plus précisément un minéral de sulfure de fer.

L’interprétation la plus plausible est que des réactions d’oxydoréduction se sont produites à l’intérieur de la roche après sa formation. Elles ont transféré des électrons des matières organiques vers l’oxyde ferrique et le sulfate, ce qui a produit les zones décolorées, où l’oxyde ferrique est réduit en oxyde ferreux.

NASA JPL-Caltech

Le point crucial est que ces réactions, en particulier la réduction des sulfates, ne se produisent normalement pas aux températures relativement basses auxquelles la roche de Chevaya Falls a été soumise au cours de son histoire… à moins que des microbes ne soient intervenus pour aider la réaction à se produire. L’oxydation microbienne de la matière organique peut également produire des minéraux phosphatés, comme ceux trouvés à Cheyava Falls.

Si nous ne ramenons pas les échantillons dans des laboratoires sur Terre, nous ne pourrons pas savoir ce qui s’est réellement passé à Cheyava Falls il y a quatre milliards d’années.

Mais malgré cela, pour l’instant, nous n’avons pas identifié d’explication « non-biologique » (qui n’implique pas d’organisme vivant) qui soit entièrement satisfaisante et rende compte de l’ensemble des observations faites par Perseverance. Le nouvel article détaille ces potentielles explications, en examinant les possibilités une par une.

Mais quoi qu’il en soit, en astrobiologie, l’absence d’explication non biologique ne marque pas la fin de la recherche de vie, mais plutôt… son commencement. L’histoire nous enseigne que lorsque nous ne trouvons pas d’explication non biologique à un phénomène, ce n’est généralement pas parce qu’il n’y en a pas… c’est simplement parce que nous n’y avons pas encore pensé.

À lire aussi :

Comment cherche-t-on des traces de vie sur Mars ?

Que va-t-il se passer maintenant ?

Tout d’abord, les astrobiologistes du monde entier doivent étudier quelles réactions d’oxydoréduction impliquant le fer, le soufre, les composés organiques et le phosphate auraient pu se produire, avec ou sans organismes vivants, dans des conditions similaires à celles de Cheyava Falls.

Ensuite, la NASA et d’autres agences spatiales devront faire preuve d’un leadership audacieux dans le cadre de la mission Mars Sample Return. Oui, cela coûtera cher, peut-être des dizaines de milliards de dollars, mais le résultat pourrait être la découverte scientifique la plus importante jamais réalisée.

À lire aussi :

La politique spatiale de la Chine déjoue-t-elle le narratif imposé par les Etats-Unis ? Une conversation avec Isabelle Sourbès-Verger

![]()

Sean McMahon a reçu des financements de la NASA par le passé.

– ref. Mars : les nouveaux résultats de la NASA démontrent-ils des signes de vie passée ? – https://theconversation.com/mars-les-nouveaux-resultats-de-la-nasa-demontrent-ils-des-signes-de-vie-passee-265084