Source: The Conversation – in French – By Clémentin Rachet, Architecte, chercheur (laboratoire CRENAU), Ecole Nationale Supérieure d’Architecture de Nantes

Alors que les commerces quittent progressivement les centres-villes, écrivaines et écrivains semblent fascinés par les supermarchés. À chaque extrêmité de l’échiquier politique, d’Annie Ernaux à Michel Houellebecq, la littérature contemporaine leur voue un culte surprenant. Comment expliquer cet intérêt soudain, et visiblement consensuel, pour ces lieux du quotidien ?

Le supermarché en particulier, et les espaces de consommation en général, attisent depuis l’avènement de la société de consommation les regards les plus acerbes et les désirs les plus inavoués. Alors que Françoise Sagan inaugurait l’ouverture du premier hypermarché de France en 1963, écrivaines et écrivains contemporains ne s’y sont visiblement pas trompés et investissent dûment, au sein de leurs romans, l’ensemble des « temples » de la consommation moderne.

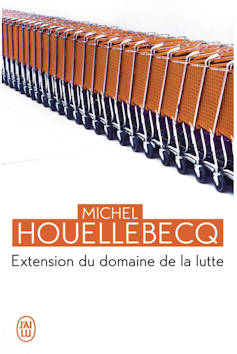

Folio

Le supermarché (ou l’hypermarché) est, en effet, progressivement devenu digne d’intérêt. Annie Ernaux y consacre même un livre en 2014 – journal intime à l’hypermarché Auchan du centre commercial des Trois-Fontaines, à Cergy (Essonne) – sur la couverture duquel (dans sa version poche) trône un caddie orange. Le début de Regarde les lumières mon amour (2014) prend des allures de revendication, voire de slogan manifeste. Dès les premières pages, l’écrivaine y explique les raisons de son entreprise :

« Pour raconter la vie, la nôtre, aujourd’hui, c’est donc sans hésiter que j’ai choisi comme objet les hypermarchés. J’y ai vu l’occasion de rendre compte d’une pratique réelle de leur fréquentation, loin des discours convenus souvent teintés d’aversion que ces prétendus non-lieux suscitent et qui ne correspondent en rien à l’expérience que j’en ai. »

Rappelons que le sociologue Marc Augé a précisément fait des espaces de la consommation l’un des trois piliers de ses « non-lieux empiriques », aux côtés des espaces de circulation et de communication. Si Ernaux semble douter d’une telle affectation et vouloir désamorcer, loin des discours dépréciateurs et moralisateurs, les effets répulsifs qui l’accompagnent habituellement, c’est que le super/hyper symbolise de nombreux paradoxes : à la fois attractif et repoussant, dénigré et massivement fréquenté, il est définitivement ambigu.

Il faut dire que nous passons un temps non négligeable dans les supermarchés. Pour l’écrivaine, ils méritent de fait la plus grande attention de la part de celles et ceux chargés d’en fabriquer les représentations :

« Nous choisissons nos objets et nos lieux de mémoire ou plutôt l’air du temps décide de ce dont il vaut la peine qu’on se souvienne. Les écrivains, les artistes, les cinéastes participent de l’élaboration de cette mémoire. Les hypermarchés, fréquentés grosso modo cinquante fois l’an par la majorité des gens depuis une quarantaine d’années en France, commencent seulement à figurer parmi les lieux dignes de représentation. »

L’esthétisation du supermarché

Si cette dignité apparaît comme circonstancielle – le modèle de la grande distribution qui date des années 1960, est relativement récent –, gageons qu’elle perdure. Car les enseignes commerciales tâchent continuellement de réinventer leur offre, aussi conscientes que l’autrice de l’importance qu’elles occupent depuis soixante ans dans notre quotidien.

Si les centres-villes se vident de leurs commerces dans la plupart des villes intermédiaires, perdant ainsi des lieux de sociabilité qui faisaient le sel de l’expérience urbaine, c’est que les centres commerciaux s’exposent comme un « centre-ville d’un nouveau genre », en accueillant, au-delà d’une offre commerciale défiant toute concurrence, des programmes urbains, des cinémas ou des cafés notamment. Les hyper/super et les centres commerciaux sont-ils devenus le « bistrot de la France périurbaine » ? Toutes les études convergent : on compte un hypermarché, en France, tous les vingt kilomètres en moyenne. En quittant sciemment la centralité, voilà qu’il l’aurait définitivement remplacée.

J’ai lu.

Rares sont donc les lieux que l’on fréquente aussi régulièrement qu’un supermarché. Michel Houellebecq ne cesse de le démontrer depuis la publication de ses premiers textes, à l’orée des années 1990. Dans sa poésie ou dans ses essais, le supermarché occupe une place de choix. Le poème « Hypermarché, Novembre », qui ouvre le recueil la Poursuite du bonheur (1991) – et donc, d’une certaine manière, l’entrée en littérature de Houellebecq – devance même la sortie du premier roman de l’auteur, Extension du domaine de la lutte (1994), dont la couverture du format poche présente une enfilade de caddies sur fond blanc. D’une certaine manière, chez Houellebecq, le supermarché anticipe le roman.

Dans sa géographie éclatée des supermarchés, de Limoges à Paris en passant par la Normandie ou l’Espagne, l’écrivain n’oublie jamais de signifier à quel point les supermarchés demeurent les seuls territoires capables d’émerveiller des personnages à qui l’espace urbain ne procure qu’angoisse ou désolation :

« Un hypermarché Casino, une station-service Shell demeuraient les seuls centres d’énergie perceptibles, les seules propositions sociales susceptibles de provoquer le désir, le bonheur, la joie. »

Si Ernaux et Houellebecq apparaissent comme les figures de proue de cette entreprise d’esthétisation du supermarché, leurs consœurs et leurs confrères ne sont pas en reste : de Laurent Mauviginer dans Ce que j’appelle oubli (2011) à Marie-Hélène Lafon dans Nos vies (2017), en passant par Célestin de Meeûs et sa Mythologie du .12 (2024), ou, de l’autre côté de l’Atlantique, par Bret Easton Ellis chez qui « la consommation et le paraître sont présentés comme l’éthos de l’Amérique riche et blanche », les supermarchés revêtent des imaginaires et des représentations riches et variés dans la littérature contemporaine. Les personnages y projettent des ersatz de domesticité.

En estompant sciemment les limites entre les activités domestiques et la consommation de masse, auteurs et autrices expriment les relations, mouvantes, qui opèrent entre les individus et nos lieux de consommation ordinaire.

Temples de la consommation

Le supermarché rassemble ; il crée du consensus. Il reste respectivement perçu chez Houellebecq et chez Ernaux comme « émerveillement du monde » et comme « grand rendez-vous de l’humain ». Le supermarché frise donc avec le métaphysique, voire le mystique. Au narrateur de Sérotonine (2019) de déclarer :

« Je n’avais jamais, à mon âge, mis les pieds dans un centre Leclerc. Je fus ébloui. »

L’éblouissement confine au religieux.

Et comme il en est d’usage dans les églises, Annie Ernaux se demande dans Regarde les lumières mon amour s’il est autorisé de photographier l’intérieur des lieux. L’autrice questionne, en creux, leur inintérêt architectural.

La littérature n’est du reste pas la seule à s’éprendre du supermarché. On connaît notamment l’affection que lui porte le photographe anglais Martin Parr :

Si le champ de la création s’y intéresse de manière exponentielle, le super/hyper tarde à opérer une mue significative dans l’imaginaire collectif, encore associé à un rituel hebdomadaire ou quotidien au mieux déprimant, au pire anxiogène, sous les néons blafards et les musiques de fond des grandes enseignes commerciales génériques.

Généralement construits sans ambition créative, selon des modèles reproductibles, les super/hyper n’ont pas meilleure presse chez les architectes. Ils sont même à l’origine d’une expression devenue courante. La fameuse « esthétique de supermarché » que certains se plaisent à employer à l’envi pour désigner la pauvreté d’un paysage ou d’un bâtiment, renvoyant dès que possible les super/hyper à la laideur dont ils souffrent déjà dans nos représentations courantes. Mais, à en croire les écrivaines et les écrivains, la fascination prend plutôt racine ailleurs : dans la simplicité réconfortante d’un programme quotidien, utopie du proche et du familier. Dans un monde globalisé, le supermarché représente visiblement l’un des derniers refuges de sociabilité et l’illusoire espoir d’un possible foyer.

Cet article est publié dans le cadre de la série « Regards croisés : culture, recherche et société », publiée avec le soutien de la Délégation générale à la transmission, aux territoires et à la démocratie culturelle du ministère de la culture.

![]()

Clémentin Rachet ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Le supermarché, source d’inspiration pour la littérature contemporaine – https://theconversation.com/le-supermarche-source-dinspiration-pour-la-litterature-contemporaine-263576