Source: The Conversation – (in Spanish) – By Elba Astorga, Editora de Economía, The Conversation

Aprovechando que estamos en esos días en los que todos estamos haciéndonos propuestas de mejora para el nuevo año, quiero proponerles una serie de buenos artículos que les pueden ayudar a reflexionar sobre cuál es su relación con el trabajo y cuál les gustaría que fuera: ¿agobiado?, ¿tecnoestresado?, ¿quemado?, ¿desinteresado?

Un experto nos plantea tres preguntas:

-

¿Disfrutamos cuando estamos al límite de una fecha de entrega?

-

¿Nos gusta trabajar en distintos proyectos, aunque sepamos que muy posiblemente no podremos conseguir las metas?

-

¿Solemos poner el trabajo por encima de nuestra salud por las recompensas que ofrece?

Tres respuestas positivas nos acercan peligrosamente al diagnóstico de adicción al estrés.

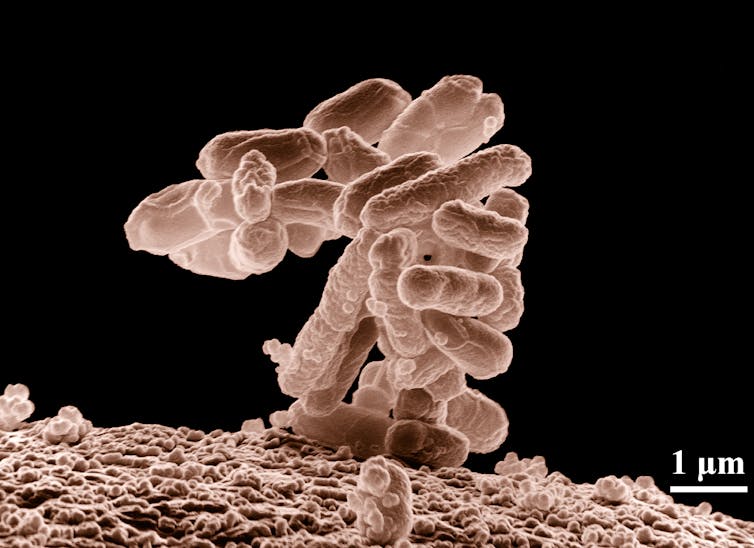

Aunque pueda darnos una sensación de alerta y emoción y nos haga sentir vivos, esa efervescencia viene dada por el cortisol (la hormona del estrés) que, si permanece constante, puede acabar afectando nuestro corazón y nuestro sistema inmunitario y, además, provocarnos envejecimiento prematuro. ¿Una buena noticia? Actividad física, alimentación sana y un buen patrón de sueño ayudan a desengancharnos.

El entorno laboral puede ser fuente de estrés para muchos. Bien por sobrecarga de trabajo, por tener un jefe o unos compañeros tóxicos o, en el peor de los casos, por todos esos factores juntos. Y los efectos negativos no repercuten solo en el afectado, sino también en la propia empresa pues, en ambientes estresantes, cae la productividad y aumentan las bajas y las ausencias.

Los niveles de estrés en el entorno laboral vienen determinados no solo por las características del trabajo sino también por las de las personas. Las mujeres trabajadoras, que suelen llevar también la carga de la mochila doméstica, se muestran más estresadas que sus compañeros de trabajo que realizan las mismas funciones que ellas.

En 1981, Rubén Blades cantaba: “Te están buscando unos tipos que cuando niños sus mamás no los querían y ahora de adultos viven repartiendo bofetás”.

Esas bofetás pueden ser literales o figuradas pero, en cualquier caso, son propias de personas tóxicas. Sean compañeros de trabajo o jefes que –bien por inmadurez emocional, envidia, competitividad mal gestionada o problemas en el diseño y organización de las funciones– hacen comentarios hirientes, critican, acosan y no apoyan ni ayudan cuando se les necesita.

¿Cómo afrontar esta fuente de estrés laboral?: poniendo límites, buscando el apoyo de otros colegas que no sean tóxicos, reconociendo y poniendo en valor las cosas buenas que pueda tener el trabajo, hablando de lo que está pasando con gente cercana (amigos, familiares) o con profesionales de la salud mental. Y aferrándose a la tríada prodigiosa para el control del estrés: movimiento, buena alimentación, buen patrón de sueño.

La buena noticia es que hay jefes que ejercen un liderazgo positivo en sus equipos. Y esos favorecen la salud física y mental de las personas trabajadoras y, además, mejoran la satisfacción laboral (lo que redunda en positivo en la productividad y en el compromiso con la empresa).

También las máquinas pueden producirnos estrés (tecnoestrés) en el trabajo. ¿Por qué? Aquí intervienen diversos factores: porque nos genera inseguridad aprender a usar tecnologías que no conocemos, porque nos parecen artefactos complejos o porque sentimos que han venido a invadir nuestra vida laboral, por ejemplo.

El burnout, o síndrome de estar quemado, es el agotamiento físico, emocional y mental causado por el estrés crónico. Quienes lo padecen no sienten energía física ni mental y están irritados, frustrados y sin fuerzas. Para sobrellevarlo, las personas necesitan aprender a poner límites con el trabajo (incluida la desconexión digital) y a no descuidar su vida personal. Deben moverse, alimentarse bien e intentar dormir mejor, y también tienen que hablarlo (con personas cercanas o expertos en salud mental).

Pero las empresas también tienen el deber de tomar medidas que favorezcan el bienestar de los trabajadores. Como equilibrar las cargas de trabajo, promover estilos de liderazgo positivos y motivadores, ofrecer programas de capacitación y desarrollo profesional, establecer políticas de comunicación claras y fomentar entornos laborales respetuosos y relaciones laborales cooperativas.

Una cosa es el crepitar del estrés. Pero otra es percibir el trabajo como una labor sin sentido, que genera mucho movimiento y pocos resultados. La situación recuerda a la de Sísifo empujando la roca infinitamente y sin ninguna finalidad. Este desgaste no surge necesariamente por exceso de trabajo sino por la percepción de que el esfuerzo es inútil.

¿Cómo combatir esta desesperanza? Aquí se necesita el compromiso personal de encontrarle un nuevo sentido al trabajo, intentar no dejar procesos y proyectos abiertos o pendientes, eliminar los esfuerzos inútiles, superfluos o que no aportan valor. Y a través del autocuidado: moverse, comer bien, dormir mejor y hablar. Con alguien cercano o, si se considera necesario, con un experto en salud mental.

Hace 50 años una psicóloga suiza acuñó el término personalidad resistente. Tras estudiar a directivos sometidos a altos niveles de estrés, vio que algunos sufrían menos sus consecuencias físicas y emocionales. Así, entendió que el secreto está en las herramientas vitales con las que se cuenta para afrontar los obstáculos y dificultades: el compromiso (tanto en la vida personal como la profesional), el control (la creencia de que las acciones propias influyen en los resultados externos reduce la sensación de indefensión) y la disposición a enfrentarse a retos (viéndolos como lecciones de vida y no como amenazas). ¿Lo mejor de todo? Que la personalidad resistente puede entrenarse.

![]()

– ref. La selección: cómo resistir el estrés, la fatiga, el desinterés y el ‘burnout’ en el trabajo – https://theconversation.com/la-seleccion-como-resistir-el-estres-la-fatiga-el-desinteres-y-el-burnout-en-el-trabajo-272423