Source: The Conversation – France (in French) – By Véronique André-Lamat, Professeure de Géographie, Centre national de la recherche scientifique (CNRS)

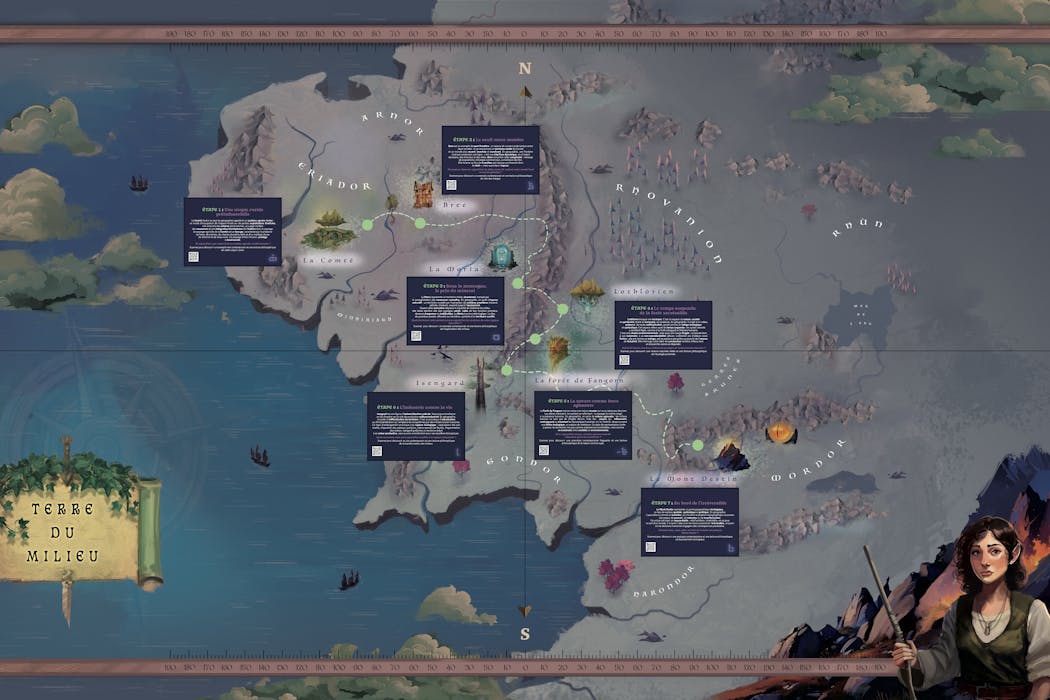

L’écrivain anglais J. R. R. Tolkien (1892-1973) était un cartographe de l’imaginaire. Dans le Seigneur des anneaux (1954-1955), il invente un monde dans lequel la frontière entre humanité et animalité est floue. Ses cartes de la Terre du Milieu construisent la cohérence spatiale et la densité narrative de la quête de la Communauté de l’anneau. Montagnes, forêts, rivières y constituent tantôt des épreuves spatiales, tantôt des espaces protecteurs ou de refuge. La géographie y structure le récit et façonne la fiction.

Les mondes imaginaires sont performatifs. Ils se nourrissent du réel dans une projection fictionnelle tout en l’interrogeant. Le Seigneur des anneaux n’y fait pas exception, nous invitant à réfléchir à nos liens avec la nature, à reconnaître sa valeur intrinsèque et à dépasser une conception dualiste opposant nature et culture, ne lui accordant qu’une valeur d’usage ou de ressource, à nous engager dans une éthique environnementale.

En suivant la Communauté, métissée, sur les chemins, parfois de traverse, les menant vers le mont Destin, nous sommes confrontés à différentes manières d’habiter et de transformer la nature : utopies rurales, zones industrieuses, refuges écologiques et lieux symboliques où des choix engagent l’avenir du monde. La fiction devient un outil pour questionner le réel, interroger nos pratiques et réfléchir aux enjeux environnementaux contemporains dans une ère désormais anthropocénique.

Léa Dutemps, Fourni par l’auteur

Habiter (avec) le monde : utopies rurales et résistance

La Comté repose sur un système agraire vivrier de polycultures fondé sur de petites exploitations familiales où le tabac réputé n’est que peu exporté. Les Hobbits vivent en autarcie et habitent littéralement une nature jardinée, dans des terriers. Le bocage, les prairies forment un maillage qui limite l’érosion et protège la biodiversité et organisent un territoire où nature et société coexistent harmonieusement. Cet idéal préindustriel s’éteint peu à peu dans le monde occidental moderne où une agriculture intensive et centralisée s’est imposée pour devenir norme sur un territoire remembré.

Léa Dutemps, Fourni par l’auteur

La forêt de Fangorn, elle, représente une nature qui résiste à la manière d’une zone à défendre (ZAD). Les Ents, gestionnaires du peuplement forestier, incarnent des arbres doués de parole, capables de révolte. Ils refusent la domination humaine fermant les sentiers d’accès avant de s’engager dans une guerre contre l’industrialisation menée par Saroumane en Isengard. Le chantier stoppé de l’autoroute A69 témoigne de la façon dont la nature peut parfois aujourd’hui par elle-même poser des limites aux projets d’aménagement voulus par l’humain.

La Lothlórien, enfin, symbolise une écotopie, un espace préservé du temps et des pressions humaines, où nature, société et spiritualité vivent en harmonie. La réserve intégrale de la forêt de la Massane, les forêts « sacrées » d’Afrique de l’Ouest ou celles du nord de la Grèce (massif du Pindes) font écho à cet idéal. Pensées comme des écosystèmes dont les dynamiques naturelles sont respectées et où l’intervention humaine contrôlée se fait discrète, elles permettent d’observer et de suivre les espèces, la régénération spontanée des habitats et leur résilience. Mais à l’image de la Lothlórien, un tel système de gestion reste spatialement rare, fragile. Il nécessite de construire la nature comme bien commun dont l’accès et l’usage sont acceptés par les communautés qui cohabitent avec ces espaces forestiers.

Léa Dutemps, Fourni par l’auteur

Ces trois types de territoires montrent qu’habiter le monde n’est pas simplement occuper, encore moins s’approprier, un espace de nature mais engager un dialogue avec lui, considérer qu’il a une valeur par lui-même, juste parce qu’il existe, et pas uniquement en tant que ressource. Il s’agit alors de cohabiter dans des interactions où chaque existant prend soin de l’autre.

Exploiter une nature ressource : de l’artificialisation à la destruction

La transformation des espaces de nature, comme le montre Tolkien, peut aussi répondre à une logique d’exploitation intensive, la nature offrant des ressources permettant d’asseoir la domination des humains sur la nature comme sur d’autres humains. Il ne s’agit plus d’envisager une cohabitation être humain/nature mais d’asservir la nature par la technique.

Isengard, le territoire de Saroumane au sud des monts Brumeux, contrôlé par la tour d’Orthanc, incarne la transformation radicale du milieu par et pour l’industrie ; une industrie dont la production d’Orques hybrides, sorte de transhumanisme appliqué à la sauvagerie, vise à renforcer le pouvoir de Saroumane et construire son armée pour prendre le contrôle d’autres territoires. La forêt est rasée, les fleuves détournés, le paysage mécanisé, dans l’unique but d’alimenter l’industrie. Les champs d’exploitation des schistes bitumineux en Amérique du Nord montrent à quel point l’exploitation de la nature peut détruire des paysages, polluer une nature qui devient impropre et dont les fonctions et services écosystémiques sont détruits).

Léa Dutemps, Fourni par l’auteur

La Moria, ancien royaume florissant du peuple Nain, est l’exemple de l’issue létale de la surexploitation d’une ressource naturelle. Si le mithril, minerai rare de très grande valeur a construit la puissance du royaume Nain, son exploitation sans cesse plus intense, vidant les profondeurs de la terre, va conduire à l’effondrement de la civilisation et à l’abandon de la Moria. Ce territoire minier en déshérence fait écho aux paysages des régions du Donbass par exemple, qui conservent aujourd’hui encore les traces visibles de décennies d’extraction charbonnière : galeries effondrées, sols instables et villes partiellement abandonnées.

Lieux de rupture et enjeux planétaires

On trouve enfin chez Tolkien une mise en scène d’espaces qui représentent des lieux de bascule pour l’intrigue et l’avenir du monde, en l’occurrence la Terre du Milieu.

Le « bourg-pont » de Bree, zone frontière matérialisée par une large rivière, marque la limite entre l’univers encore protégé, presque fermé, de la Comté et les territoires marchands de l’est, ouverts et instables. Mais Bree est aussi un carrefour dynamique, lieu d’échanges où circulent et se rencontrent des personnes, des biens et des récits. Un carrefour et une frontière où toutefois la tension et la surveillance de toutes les mobilités sont fortes.

Léa Dutemps, Fourni par l’auteur

Lieu de transition, symbolisant à la fois ouverture et fermeture territoriales, Bree est un point de bascule dans le récit où convergent et se confrontent des personnages clés de l’intrigue (les Hobbits, Aragorn, les cavaliers noirs de Sauron), les figures du Bien et du Mal autour desquelles vont se jouer l’avenir de la Terre du Milieu. Comme Bree, Calais est un point de friction entre un espace fermé (les frontières britanniques) et un espace ouvert où s’entremêlent société locale, logiques nationales et transnationales, mais où les circulations sont de plus en plus contrôlées.

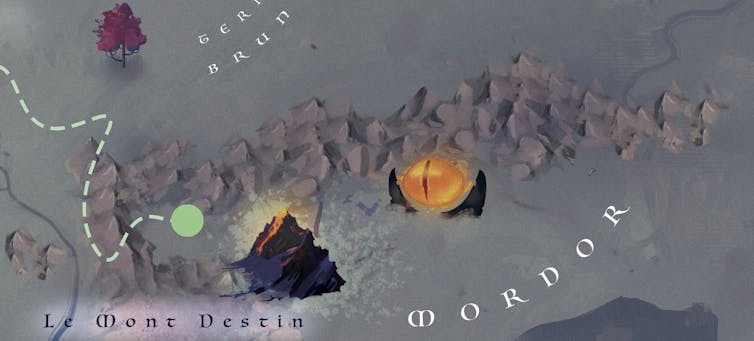

Enfin, la montagne du Destin, volcan actif, incarne le lieu de rupture ultime, celui où le choix d’un individu, garder l’anneau pour lui seul dans un désir de pouvoir total ou accepter de le détruire, a des conséquences majeures pour toute la Terre du Milieu. Certains espaces jouent un rôle similaire sur notre terre. La fonte du permafrost sibérien ou de l’inlandsis antarctique pourrait libérer d’immenses quantités de carbone pour l’un, d’eau douce pour l’autre, accélérant le dérèglement climatique et la submersion de terres habitées.

Ces lieux où des actions localisées peuvent déclencher des effets systémiques globaux, au-delà de tout contrôle, concentrent ainsi des enjeux critiques, écologiques, géopolitiques ou symboliques.

La fiction constitue un puissant vecteur de réflexion quant à notre responsabilité collective dans la gestion de la nature, quant à nos choix éthiques et politiques dans la manière d’habiter la Terre en tant que bien commun et ainsi éviter d’atteindre un point de bascule qui sera celui d’un non-retour.

![]()

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’ont déclaré aucune autre affiliation que leur organisme de recherche.

– ref. La Terre du Milieu de Tolkien, un lieu imaginaire pour repenser notre rapport à la nature – https://theconversation.com/la-terre-du-milieu-de-tolkien-un-lieu-imaginaire-pour-repenser-notre-rapport-a-la-nature-272085