Source: The Conversation – in French – By Coralie Thieulin, Enseignant chercheur en physique à l’ECE, docteure en biophysique, ECE Paris

Au cœur de l’hiver, la quête du pull-over parfait peut parfois sembler bien compliquée. Trouver un textile chaud, qui n’endommage pas l’environnement, qui soit confortable… Les critères s’accumulent. Tâchons d’y voir plus clair.

Avoir chaud en hiver tout en limitant son impact environnemental peut sembler un défi. Chercher à avoir des vêtements nous protégeant au mieux du froid est certes un levier efficace pour réduire sa consommation d’énergie, comme le montrent des initiatives telles que le mouvement Slow Heat et d’autres expérimentations récentes.

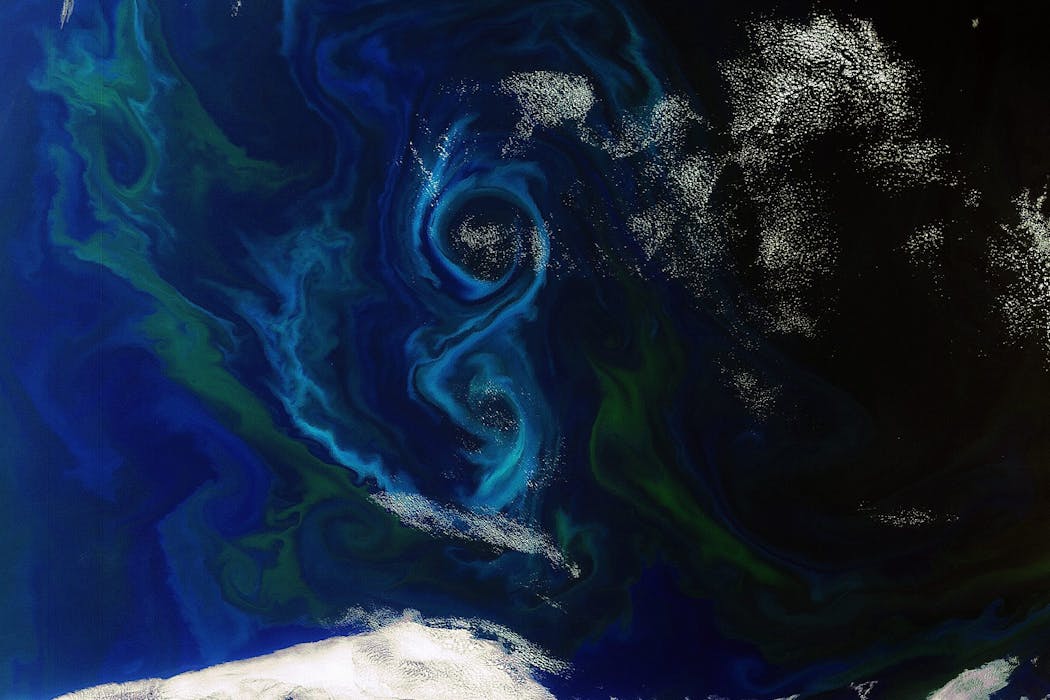

Toutefois, cette démarche se heurte à une contradiction de taille : le secteur textile reste parmi les plus polluants au monde, avec des émissions de gaz à effet de serre importantes et une contribution notable aux microplastiques marins.

Alors, quelles matières tiennent vraiment chaud tout en respectant davantage l’environnement ? Si les fibres naturelles sont souvent mises en avant pour leur bonne isolation et leur fin de vie plus respectueuse de l’environnement, leur impact réel dépend largement de la manière dont elles sont produites et utilisées. Pour y voir plus clair, commençons par comprendre ce qui fait qu’un textile tient chaud.

La fabrication du textile tout aussi importante que la fibre

La capacité d’un textile à tenir chaud dépend moins de la fibre utilisée que de l’air qu’elle parvient à enfermer. En restant immobile dans de minuscules espaces au cœur du tissu, cet air limite les échanges de chaleur, un peu comme dans une couette ou un double vitrage. Plus un tissu est épais, duveteux ou poreux, plus il limite les échanges de chaleur.

Cette capacité dépend beaucoup de la structure des fibres et de la manière dont le textile est fabriqué. Les fibres frisées ou ondulées comme la laine de mouton créent des poches où l’air reste piégé. D’autres fibres comme l’alpaga (un camélidé des Andes proche du lama) ou le duvet synthétique sont partiellement creuses, augmentant encore la capacité isolante. De même, les tricots et mailles, plus lâches, isolent mieux que les tissages serrés. Ainsi, la chaleur d’un vêtement dépend autant de sa construction que de sa matière.

Elwinlhq/Wikimedia, CC BY

C’est sur ces mêmes principes physiques que reposent les fibres synthétiques. En effet, le polyester, l’acrylique, le polaire imitent en partie la laine par leur structure volumineuse et leur capacité à emprisonner de l’air, soit grâce à des fibres frisées, soit grâce à des fibres creuses ou texturées.

Ainsi, ces textiles offrent une bonne isolation thermique, sont légers et sèchent rapidement, ce qui les rend très populaires pour le sport et l’outdoor. En revanche, leur faible respirabilité intrinsèque et leur capacité limitée à absorber l’humidité peuvent favoriser la transpiration et la sensation d’humidité lors d’efforts prolongés. D’autre part, contrairement aux fibres naturelles, ces matériaux sont inflammables, un aspect souvent négligé, mais qui constitue un enjeu réel de sécurité.

Elles ont également un coût environnemental élevé. Issues du pétrole, non biodégradables et fortement consommatrices d’énergie, ces fibres libèrent à chaque lavage des microfibres plastiques dans l’eau, contribuant à la pollution marine. On estime qu’entre 16 % et 35 % des microplastiques marins proviennent de ces textiles, soit de 200 000 à 500 000 tonnes par an. Ces impacts surpassent largement ceux des fibres naturelles, ce qui constitue un vrai défi pour une mode plus durable.

Les bénéfices de la laine de mouton mérinos et de l’alpaga

Face à ces limites, les fibres naturelles apparaissent donc souvent comme des alternatives intéressantes, à commencer par la laine de mouton, longtemps considérée comme une référence en matière d’isolation thermique.

La laine possède en effet une structure complexe et écailleuse : chaque fibre est frisée et forme de multiples micro-poches d’air, réduisant ainsi la perte de chaleur corporelle. Même lorsqu’elle absorbe un peu d’humidité, l’air reste piégé dans sa structure, ce qui lui permet de continuer à isoler efficacement. Cette organisation particulière explique aussi pourquoi la laine est respirante et capable de réguler l’humidité sans donner une sensation de froid. Cependant, ces mêmes fibres peuvent parfois provoquer une sensation de « grattage » pour certaines personnes : plus les fibres sont épaisses, plus elles stimulent les récepteurs de la peau et provoquent des picotements. Il s’agit d’un phénomène purement sensoriel, et non d’une allergie.

CSIRO, CC BY

Parmi les différents types de laines, la laine de mouton mérinos, issue d’une race d’ovin originaire d’Espagne se distingue par la finesse de ses fibres, nettement plus fines que celles de la laine classique (de 11 à 24 microns pour le mérinos et de 25 à 40 microns pour la laine classique) . Cette caractéristique réduit fortement les sensations d’irritation au contact de la peau et améliore le confort.

Elle favorise également la formation de nombreuses micro-poches d’air isolantes, tout en maintenant une excellente respirabilité. Ces qualités expliquent son usage croissant dans les sous-couches et vêtements techniques, aussi bien pour le sport que pour le quotidien.

Pour autant, la laine n’est pas exempte d’impact environnemental. Bien qu’elle soit renouvelable et biodégradable, son élevage contribue aux émissions de gaz à effet de serre, principalement via le méthane produit par les moutons et la gestion des pâturages. On estime qu’entre 15 et 35 kg de CO₂ équivalent sont émis pour produire 1 kg de laine brute, et qu’environ 10 000 litres d’eau sont nécessaires, selon le mode d’élevage. Le bien-être animal et les pratiques agricoles, comme le mulesing ou l’intensification des pâturages, jouent également un rôle déterminant dans l’empreinte globale de cette fibre.

D’autres fibres animales, comme l’alpaga, suscitent un intérêt croissant en raison de propriétés thermiques comparables, voire supérieures, associées à un meilleur confort. Les fibres d’alpaga sont en effet partiellement creuses, ce qui leur permet de piéger efficacement l’air et de limiter les pertes de chaleur, tout en restant légères. Contrairement à certaines laines plus grossières, elles ne grattent pas, ce qui les rend agréables à porter directement sur la peau.

Elles sont également plus longues et plus fines que la laine classique, avec une bonne capacité de régulation de l’humidité et un séchage plus rapide. Ces caractéristiques expliquent l’essor de l’alpaga dans les vêtements techniques comme dans les pièces haut de gamme, des sous-couches aux manteaux. Sur le plan environnemental, l’alpaga présente aussi certains avantages. En effet, l’élevage d’alpagas exerce généralement une pression moindre sur les écosystèmes : animaux plus légers, consommation alimentaire plus faible, émissions de méthane réduites et dégradation limitée des sols comparativement à l’élevage ovin. Là encore, la durabilité dépend largement du respect de systèmes extensifs et adaptés aux milieux locaux.

Le succès des fibres synthétiques

Malgré les nombreux atouts de ces textiles naturels, les fibres synthétiques restent donc très utilisées, notamment pour leurs performances techniques. Mais leur succès est aussi lié à des facteurs économiques et pratiques : elles sont généralement moins coûteuses, très abondantes dans le commerce, et faciles à transformer en vêtements de masse. Ces aspects rendent le synthétique accessible et pratique pour une large partie des consommateurs, ce qui explique en partie sa prédominance dans l’industrie textile, indépendamment des préférences individuelles.

Polaire, duvet synthétique ou fibres techniques offrent une isolation thermique efficace, tout en étant légères et rapides à sécher, des qualités particulièrement recherchées dans les vêtements de sport et d’outdoor. La conductivité thermique est une mesure de la capacité d’un matériau à conduire la chaleur : plus cette valeur est faible, moins la chaleur passe facilement à travers le matériau, ce qui signifie une meilleure capacité à retenir la chaleur dans un textile donné.

Des mesures de conductivité thermique montrent par exemple que certains isolants synthétiques comme la polaire présentent des valeurs très basses (0,035-0,05 watt par mètre-kelvin (W/m·K)), indiquant une excellente capacité à retenir la chaleur. Pour comparaison, la laine, lorsqu’elle est compacte ou densifiée, peut atteindre 0,16 W/m·K, mais dans les textiles isolants volumineux, elle reste faible (0,033–0,045 W/m·K).

Toutefois, l’origine fossile, la non-biodégradabilité, la libération de microplastiques et un recyclage encore très limité font des textiles synthétiques des matériaux à fort impact environnemental.

Le pull en laine qui gratte, un préjugé qui colle à la peau

À l’inverse, si les fibres naturelles sont parfois boudées, ce n’est pas toujours pour des raisons environnementales, mais souvent pour des questions de confort. Une personne ayant déjà porté un vêtement en fibres naturelles qui lui a paru inconfortable ou irritant peut développer un rejet global de ces fibres, au profit du synthétique, même lorsque des alternatives plus douces existent.

Or, des solutions sont disponibles : privilégier des fibres fines comme la laine mérinos, l’alpaga ou le cachemire, recourir à des traitements mécaniques ou enzymatiques pour adoucir les fibres, ou encore combiner différentes fibres naturelles. Le choix doit aussi tenir compte de l’usage du vêtement et de son contact direct avec la peau.

En pratique, choisir un textile chaud et moins polluant relève donc d’un compromis, qui dépend autant de la matière que de l’usage. Une sous-couche portée à même la peau bénéficiera de fibres fines et respirantes, comme la laine mérinos, tandis qu’une couche intermédiaire privilégiera l’isolation et un vêtement extérieur la protection contre l’humidité et le vent.

Enfin, plutôt que de rechercher une matière « parfaite », il est essentiel de raisonner en cycle de vie. Sa durabilité (combien de temps il est porté), sa réparabilité, la fréquence et la manière de le laver, ainsi que sa fin de vie (recyclage, réutilisation, compostage pour les fibres naturelles) influencent largement son impact environnemental total. Un vêtement bien entretenu et durable peut avoir un impact bien moindre qu’un textile « écologique », mais rapidement jeté.

Au final, les matières textiles les plus chaudes et les moins polluantes sont majoritairement naturelles, mais aucune n’est totalement exempte d’impact. La laine mérinos et l’alpaga offrent aujourd’hui un compromis intéressant entre chaleur, confort et fin de vie environnementale. Le rejet des fibres naturelles pour des raisons de grattage mérite d’être nuancé : la qualité et la finesse des fibres font toute la différence. Mieux informer sur ces aspects pourrait encourager des choix plus durables. En textile comme ailleurs, le meilleur choix reste souvent celui que l’on garde longtemps.

![]()

Coralie Thieulin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Quel textile choisir pour avoir chaud tout en limitant l’impact environnemental ? – https://theconversation.com/quel-textile-choisir-pour-avoir-chaud-tout-en-limitant-limpact-environnemental-273602