Source: The Conversation – France in French (2) – By Elisa Cliquet Moreno, Chef de projet réutilisation, Centre national d’études spatiales (CNES)

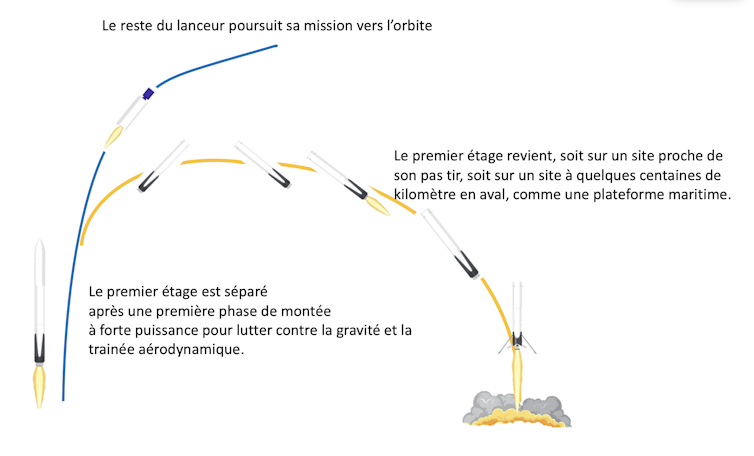

Une nouvelle course à l’espace est en cours. Depuis 2013, Space-X, le principal concurrent d’Ariane, est capable de récupérer et réutiliser le premier étage de sa fusée Falcon 9 et travaille à rendre sa super fusée Starship entièrement réutilisable.

De nombreux acteurs cherchent à acquérir cette technologie, qui permet de réduire les coûts et d’améliorer la versatilité et la flexibilité d’un système de lancement. En effet, alors qu’un lanceur (ou fusée) est constitué de plusieurs étages, le premier étage — le plus puissant pour lutter contre la gravité et la traînée aérodynamique — est aussi le plus cher. Le récupérer et le remettre en état peut être moins cher que d’en fabriquer un neuf à chaque lancement.

La réutilisation est un indéniable atout de compétitivité à l’heure où la concurrence mondiale augmente dans le domaine des lanceurs.

Le CNES (Centre national d’études spatiales) a, depuis 2015, mis en place une feuille de route articulée autour de plusieurs prototypes de démonstration. Ceux-ci visent à maîtriser les différentes briques technologiques et les nouvelles « phases de vie » des lanceurs liées à la réutilisation : il faut pouvoir guider la phase de retour, atterrir verticalement, puis « remettre en sécurité » l’étage récupéré avec des robots, c’est-à-dire vidanger les fluides sous pression qu’il contient encore pour permettre l’accès à des opérateurs dans des conditions de sécurité optimales.

Après des essais au sol réussis en France en 2024, c’est un prototype d’étage à bas coût et réutilisable qui a rejoint au début de cet été son pas de tir à Kiruna, en Suède.

Première étape : développer un moteur versatile, capable de fournir de petites comme de grandes poussées

La première brique fondamentale est de disposer d’un moteur réallumable et dont la poussée peut s’adapter en cours du vol pour permettre à la fois un décollage « à fond », pour faire décoller le lanceur plein, mais également permettre un atterrissage tout en douceur du premier étage quasiment vide : il faut pour cela un moteur capable de fonctionner sur une large plage de poussée.

À lire aussi :

Ariane 6 et les nouveaux lanceurs spatiaux, ou comment fabriquer une fusée aujourd’hui

Elisa Cliquet Moreno, Fourni par l’auteur

Le démonstrateur (ou prototype) Promethéus a donc naturellement fait l’objet de la première démonstration, initiée sous l’impulsion du CNES dès 2015. Fonctionnant à l’oxygène liquide et au biométhane liquide (plus propre et mieux adapté à la réutilisation que le kérosène ou l’hydrogène), capable de fournir une poussée allant de 30 à 110 % de son point de fonctionnement de référence à 1000 kilonewtons, il est le précurseur d’une nouvelle génération de moteurs réutilisables à bas coût. Grâce à l’impression 3D, il est composé de 50 % de pièce en moins qu’un moteur conventionnel. Le but est que Promethéus soit réutilisable au minimum 5 fois (le nombre de réutilisations pour assurer l’intérêt économique de la récupération est une variable qui dépend de chaque système de lancement).

Testé avec succès courant 2024 chez ArianeGroup à Vernon, dans l’Eure, le premier exemplaire de Promethéus a été monté sur le premier prototype européen d’étage réutilisable à oxygène et méthane liquides, Thémis T1H.

Thémis T1H, les premiers tests à échelle 1 d’un démonstrateur d’étage bas coût et réutilisable en Europe

Ce démonstrateur n’est pas un lanceur complet mais juste un premier étage. Il a quitté le site d’ArianeGroup en France le 12 juin dernier pour rejoindre le pas de tir suédois. Là, Thémis T1H doit d’abord subir des essais combinés avec ses robots de remise en sécurité avant de réaliser un « hop » de quelques dizaines de mètres.

T1H, qui mesure plus de 30 mètres de haut pour environ 30 tonnes, va permettre de valider les grands principes des opérations liées à la réutilisation à une échelle représentative d’un petit lanceur. Seront en particulier scrutées les phases d’atterrissage et de remise en sécurité.

Un autre prototype Thémis, plus ambitieux, est en cours d’étude.

CALLISTO, un démonstrateur de premier étage réutilisable beaucoup plus ambitieux

Le démonstrateur CALLISTO, fruit d’une coopération entre le CNES, les agences spatiales japonaise JAXA et allemande DLR, marque un saut en complexité.

Ce démonstrateur de 13 mètres de haut, tout juste plus d’un mètre de diamètre et environ 4 tonnes au décollage, malgré son échelle réduite, porte toutes les fonctions et la complexité d’un futur premier étage de lanceur réutilisable. Pour illustrer les défis technologiques à relever avec CALLISTO, citons par exemple la manœuvre de « retournement » parmi tant d’autres : après une phase de montée comme une fusée normale, l’étage doit rapidement changer d’orientation pour revenir vers son pas de tir ce qui « secoue » les ergols dans les réservoirs au point que, sans précaution particulière, le liquide se déplace, se mélange avec le gaz, se réchauffe, et pourrait ne plus alimenter le moteur qui doit pourtant être rallumé ensuite pour freiner l’étage.

CNES/Orbital Dreams, 2023, Fourni par l’auteur

CALLISTO est conçu pour voler dix fois, être capable de monter à plus de dix kilomètres d’altitude et effectuer une manœuvre complexe lui permettant de se retourner rapidement vers son pas d’atterrissage, situé juste à côté de son pas de tir sur l’Ensemble de Lancement Multi-Lanceurs (ELM — Diamant) au Centre Spatial Guyanais, à Kourou. Les vols de CALLISTO permettront ainsi de valider de nouveaux algorithmes pour le GNC (Guidage Navigation Pilotage), une autre brique cruciale pour la réutilisation.

De nombreux éléments de CALLISTO sont déjà fabriqués et en cours d’essai, notamment les pieds, certaines structures clés, et des équipements avioniques. Les trois partenaires du programme contribuent de manière égalitaire à sa réalisation : la JAXA fournit par exemple le moteur, le DLR les pieds, et le CNES réalise les études système et le segment sol.

Des essais à feu de l’ensemble propulsif sont prévus mi-2026 au centre d’essai de Noshiro au Japon avant l’envoi de CALLISTO au Centre Spatial Guyanais pour ses premiers essais au second semestre 2026.

Les vols de CALLISTO, qui commenceront par des petits « sauts » (hops) à basse altitude seront de plus en plus ambitieux : ils culmineront à plus de dix kilomètres d’altitude et franchiront Mach 1.

Skyhopper : récupérer et faire re-voler un étage sur un lanceur opérationnel

La dernière étape de la feuille de route consistera à démontrer la récupération puis un second vol de l’étage récupéré, directement sur un mini lanceur opérationnel, lors d’un de ses vols commerciaux. C’est ArianeGroup & MaiaSpace qui ont été retenus pour mener à bien ce projet, baptisé Skyhopper, qui sera testé en Guyane.

Une fois la mission principale du premier étage achevée, celui-ci sera séparé du deuxième étage à une altitude d’environ 50 kilomètres : il effectuera alors une manœuvre de ré-orientation, déploiera ses gouvernes aérodynamiques, rallumera ses moteurs pour un boost de freinage.

S’en suivra une phase planée, pendant laquelle l’étage sera dirigé grâce à ses gouvernes aérodynamiques, puis un dernier rallumage du moteur, le déploiement des pieds et enfin l’atterrissage vertical sur une barge maritime située à quelques centaines de kilomètres des côtes guyanaises.

L’étage sera alors stabilisé et remis en sécurité de façon autonome par des robots puis la barge sera tractée jusqu’au port de Pariacabo en Guyane. Une fois inspecté et remis en état, cet étage sera assemblé sur un autre lanceur qui décollera pour une nouvelle mission vers l’orbite achevant ainsi la démonstration avant la fin de la décennie.

À lire aussi :

Adieu Ariane 5 ! Retour sur ses plus belles missions

Cette feuille de route, qui s’appuie à la fois sur des programmes de l’Agence Spatiale Européenne (ESA) (Promethéus et Thémis ont été initié par le CNES puis sont entrés dans le périmètre du « Future Launcher Preparatory Programme » de l’ESA respectivement en 2016 et 2019) et des programmes nationaux (Skyhopper) ou dans une coopération multilatérale (CALLISTO), a bénéficié également d’un solide support de multiples activités de Recherche et Technologies menées au niveau national, permettant de valider en amont et à petite échelle des concepts peu matures comme l’impression 3D permettant ensuite d’optimiser la conception et la fabrication du moteur Promethéus.

La France et ses partenaires sont donc en ordre de bataille pour relever les défis de la réutilisation du premier étage d’un lanceur.

![]()

Elisa Cliquet Moreno est membre de l’Association Aéronautique et Astronautique de France (présidente de la commission transport spatial)

– ref. À quand une fusée réutilisable en Europe ? – https://theconversation.com/a-quand-une-fusee-reutilisable-en-europe-262381