Source: The Conversation – in French – By Tanguy Phulpin, Maitre de Conférence, en gestion de l’énergie électrique, CentraleSupélec – Université Paris-Saclay

C’est l’une des clés de voûte invisibles – mais omniprésentes – de la transition énergétique : l’électronique de puissance, qui convertit l’électricité sous une forme exploitable par toute la diversité d’équipements électriques et électroniques. C’est elle qui permet de recharger son smartphone, d’allumer une pompe à chaleur, ou encore d’injecter l’électricité éolienne et solaire dans le réseau. Mais, avec la multiplicité des usages, nous faisons aujourd’hui face à des problèmes de soutenabilité. Quid de tous ces composants, difficiles à réparer, à réutiliser et à recycler ? Peut-on limiter les impacts environnementaux liés à la technologie et à nos besoins croissants en énergie ?

L’un des leviers de la transition énergétique et de la décarbonation de l’économie  est l’électrification de nos usages. Les véhicules électriques, par exemple, émettent pendant leur utilisation moins de polluants et de gaz à effet de serre (GES) que leurs équivalents à moteurs thermiques.

L’électricité n’est toutefois pas une source d’énergie en tant que telle, mais un vecteur d’énergie, comme l’énergie chimique contenue par les hydrocarbures, qui est libérée lors de leur combustion. Contrairement à celle-ci toutefois, il s’agit d’une forme d’énergie qu’on retrouve peu à l’état naturel (hormis peut-être lors des orages).

Un des enjeux clés est donc de produire l’électricité à partir de sources décarbonés : aujourd’hui encore, près de 60 % de l’électricité mondiale est produite à partir d’énergies fossiles. Mais ce n’est pas là le seul défi de la transition. Pour électrifier l’économie, il faut aussi déployer massivement les usages (par exemple la mobilité électrique) et renforcer la résilience du réseau électrique.

Ceci repose sur des technologies de pointe. Parmi ces technologies, l’électronique de puissance, qui permet de convertir l’électricité sous une forme exploitable par les différents appareils, joue un rôle clé qu’il convient de décrire, tant à travers son fonctionnement qu’à travers les enjeux énergétiques et écologiques qui lui sont associés.

L’électronique de puissance, maillon clé de la transition

L’électronique de puissance, mal et peu connue du grand public, est pourtant omniprésente dans notre quotidien. Il s’agit des dispositifs électroniques utilisés pour convertir l’énergie électrique, à tous les niveaux de la chaîne : par exemple sur les lignes électriques pour les changements de tension, pour le chargement des véhicules électriques, sans oublier les chargeurs de nos téléphones mobiles et ordinateurs portables.

Fourni par l’auteur

Pour les chargeurs, l’électronique de puissance permet de transformer le courant alternatif (AC) du réseau électrique en courant électrique continu pour alimenter les batteries. Elle permet également la réalisation d’onduleurs pour l’opération inverse : la transformation de courant continu en courant alternatif.

Les applications des onduleurs sont très nombreuses : ils permettent d’intégrer les sources renouvelables (photovoltaïque, éolien…) sur le réseau électrique. Ils sont également essentiels au chargement des véhicules électriques, au fonctionnement des pompes à chaleur et des climatiseurs, des produits électroménagers tels que les réfrigérateurs, les machines à laver, etc.

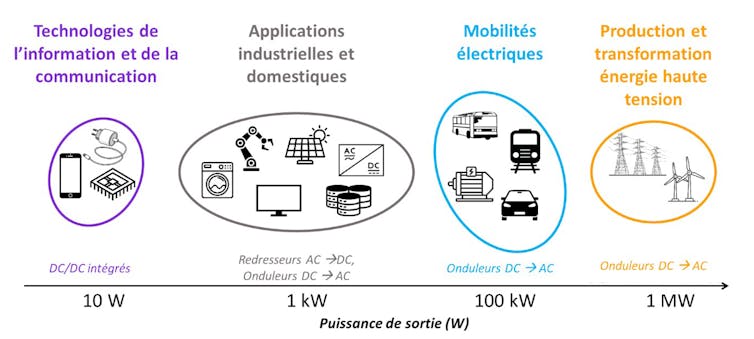

En réalité, la quasi-totalité des équipements électriques comprennent un, voire souvent plusieurs convertisseurs d’électronique de puissance, et cela à toutes gammes de puissances électriques :

-

pour les plus faibles puissances, de l’ordre de quelques dizaines de watts (W) pour charger un smartphone par exemple,

-

pour les puissances intermédiaires, de l’ordre de quelques dizaines de kW pour recharger un véhicule électrique ou injecter sur le réseau la production de panneaux solaires photovoltaïques,

-

jusqu’à celles de plusieurs mégawatts (MW), par exemple pour convertir en électricité l’énergie générée par une éolienne, ou pour alimenter les moteurs d’un TGV ou alimenter un data center.

La diversité des applications et des niveaux de puissance requis a conduit à développer une très grande diversité de produits d’électronique de puissance, optimisés pour chaque contexte.

Traditionnellement, ces enjeux de recherche et développement (R&D) concernent l’amélioration du rendement énergétique (pour limiter les pertes et augmenter les performances), l’augmentation de la densité de puissance (afin de réduire le poids et le volume des appareils), ou encore l’amélioration de leur fiabilité et de leur durée de vie. Mais avec l’explosion des usages électriques, l’électronique de puissance fait désormais face à des enjeux environnementaux et sociaux.

En effet, l’approvisionnement en matières premières critiques est sous le coup de tensions géopolitiques, tandis que leur extraction peut être source de pollutions et de dégradation des écosystèmes naturels.

Les efforts investis pour décarboner la société ne doivent néanmoins pas être considérés uniquement à travers les seules émissions de GES. Pour prévenir et limiter les transferts d’impacts (lorsque la diminution d’un impact environnemental sur une étape du cycle de vie d’un produit implique des effets négatifs sur un autre impact ou une autre étape), il faut tenir compte des autres indicateurs environnementaux, telles la disponibilité des ressources critiques ou encore la dégradation de la biodiversité.

À lire aussi :

La flexibilité électrique, ou comment décaler nos usages pour optimiser la charge du réseau

Des matériaux difficiles à réparer et à recycler

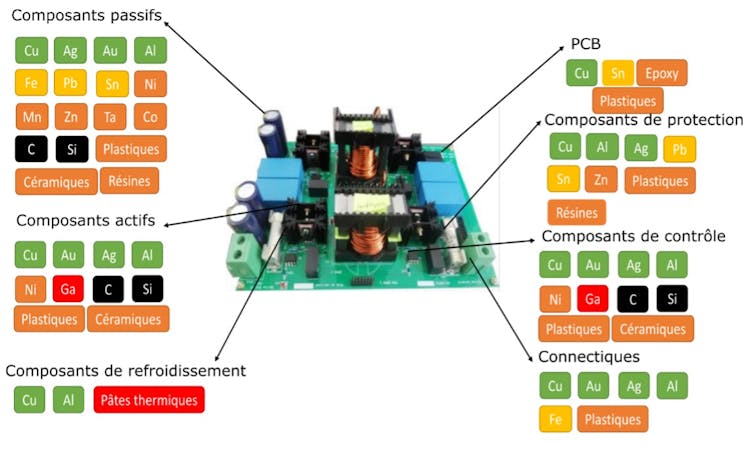

On l’a vu, l’électronique de puissance recoupe une large gamme d’applications et de puissances. De ce fait, elle est constituée d’une grande diversité de matériaux et de composants : on retrouve ainsi dans les composants constituants les convertisseurs de base plus de 70 matériaux différents.

Thèse de Boubakr Rahmani, Fourni par l’auteur

Par exemple, du silicium pour les composants semi-conducteurs, des matériaux ferreux ou alliages à base de néodyme ou nickel pour les composants magnétiques, de l’aluminium ou tantale pour les condensateurs, des époxys ou polyamides non dégradables pour les circuits imprimés (PCB) ou encore des larges pièces en aluminium faisant office de radiateurs (pour évacuer de la chaleur produite par la conversion électrique). Certains de ces matériaux sont considérés comme des matériaux critiques et/ou stratégiques, associés à de forts enjeux environnementaux, économiques, sociaux voire géopolitiques.

Le problème tient aussi à leur recyclabilité : spécialisés pour un usage donné, les produits d’électronique de puissance peuvent être plus difficiles à réparer et souvent jetés en fin de vie. L’électronique de puissance contribue ainsi à l’augmentation de la quantité de déchets électroniques à gérer dans le monde, avec quelque 62 millions de tonnes atteintes en 2022. À l’heure actuelle, moins de 20 % sont collectés et traités.

La gestion des déchets issus de l’électronique de puissance, en fin de vie, constitue ainsi un problème qui se surajoute aux tensions d’approvisionnement en matières premières critiques et à l’impact environnemental de leur extraction. Pour les minimiser, il faut agir à toutes les étapes du cycle de vie, en particulier leur conception et leur fin de vie.

Rendre l’électronique de puissance plus soutenable

La communauté des experts techniques du domaine travaille ainsi à l’amélioration de la soutenabilité des équipements électroniques, et en particulier les convertisseurs.

En particulier, le groupe de travail Convertisseurs électroniques de puissance plus soutenables (CEPPS) du groupement de recherche Systèmes d’énergie électrique dans leurs dimensions sociétales (SEEDS) du CNRS, dont nous faisons partie, s’interroge sur les possibles transferts d’impacts d’une électrification massive sans repenser nos usages et nos besoins.

En effet, l’électrification engendre la production de toujours plus d’appareils électriques pour répondre à la croissance permanente des besoins énergétiques de notre société. Ce constat devrait nous inciter, en premier lieu, à modérer ces besoins en misant davantage sur la sobriété énergétique.

Une autre question, plus délicate pour cette industrie, tient à sa quête effrénée de la performance et de la miniaturisation. Ne faudrait-il pas plutôt changer les priorités de la conception ? Par exemple, en visant l’allongement de la durée de vie ou la mise en œuvre de pratiques plus circulaires, qui permettent notamment de favoriser le recyclage ? Ce dernier point peut passer par une amélioration de la réparabilité, de l’aptitude au désassemblage et par une homogénéisation des composants et des matériaux utilisés dans les appareils.

Les experts techniques en électronique de puissance que nous sommes le reconnaissent : notre communauté ne pourra résoudre tous les problèmes évoqués précédemment. C’est pourquoi nous pensons qu’il est important d’interroger les choix de société : modèles de consommation bien sûr, mais également des choix technologiques. Or, ces derniers sont réalisés par une seule partie des acteurs de la filière, alors qu’il faudrait inclure non seulement les ingénieurs, les fabricants et les législateurs, mais également les consommateurs, sans oublier d’adopter le regard des sciences humaines et sociales.

Cela implique aussi de mieux former le grand public aux systèmes énergétiques et notamment électriques. Celui-ci doit s’approprier pleinement tant leur fonctionnement scientifique et technique que les grands défis qui y sont associés.

À lire aussi :

Comment rendre l’électronique plus soutenable ?

![]()

Jean-christophe Crebier a reçu des financements publics de l’ANR et de l’Europe en lien direct avec le sujet via les projets VIVAE, EECONE et ARCHIMEDES.

Pierre Lefranc a reçu des financements de l’ANR pour le projet VIVAE portant sur l’éco-conception en électronique de puissance.

Florentin Salomez, Hugo Helbling, Marina Labalette, Murielle Fayolle-Lecocq et Tanguy Phulpin ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’ont déclaré aucune autre affiliation que leur poste universitaire.

– ref. L’électronique de puissance : méconnue mais omniprésente et source de toujours plus de déchets électroniques – https://theconversation.com/lelectronique-de-puissance-meconnue-mais-omnipresente-et-source-de-toujours-plus-de-dechets-electroniques-266012