Source: The Conversation – (in Spanish) – By Rodrigo Maia Valença, Personal de investigación, Oficina de Proyectos Internacionales, Universidade da Coruña, Universidade da Coruña

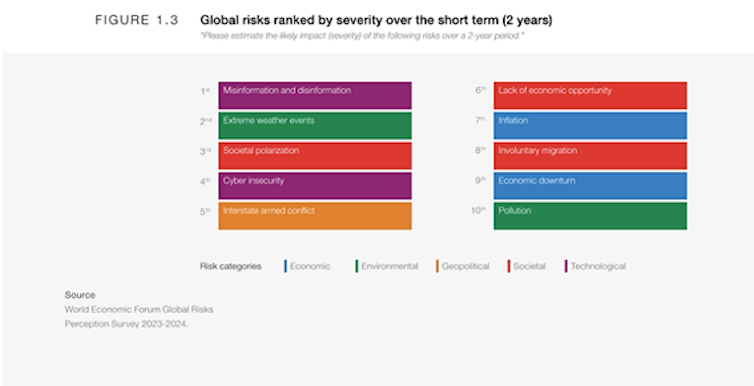

La UE habla de algoritmos, datos e inteligencia artificial como si en ellos se jugara todo su futuro. En el debate político y en los medios de comunicación la inversión en IA y tecnología ocupa un lugar central. Sin embargo, cuando se sigue el rastro del dinero, los datos contradicen el relato dominante.

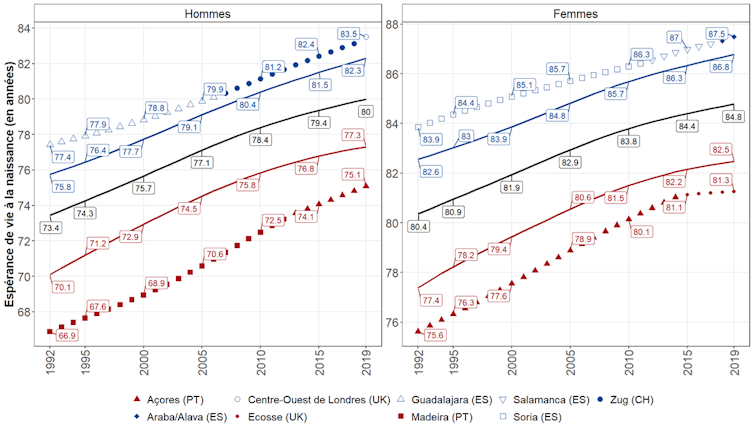

La mayor parte de la financiación de Horizonte Europa se dirige a ámbitos relacionados con el clima, la energía y el medio ambiente. Los proyectos en el área de la salud presentan, en promedio, presupuestos más elevados, mientras que la industria y las tecnologías digitales destacan por ser la temática con mayor oferta de proyectos, pero ninguno de estos dos ámbitos domina el volumen total de recursos. Las ciencias sociales y humanas, por su parte, ocupan un lugar claramente secundario.

He realizado un análisis de uno de los pilares del programa Horizonte Europa, el actual marco de investigación e innovación de la Unión Europea. En concreto, me centro en el Pilar II, relativo a los Desafíos Globales y Competitividad Industrial Europea para el periodo 2026–2027. Se trata de un instrumento de financiación y de una declaración de intenciones: a través de estos presupuestos, Bruselas decide qué problemas merecen atención prioritaria y qué tipo de sociedad aspira a construir.

Verde, digital y democrática

Para 2025–2027, la Comisión Europea subrayó tres metas estratégicas: la transición verde, la transición digital y el refuerzo de una Europa competitiva, inclusiva y democrática. Veamos cuanto dinero se ha destinado a cada una de esas grandes metas para ver qué mensaje transmite su distribución presupuestaria sobre la dirección que Europa quiere tomar.

En el Pilar II de Horizonte Europa se reparten más de 6 900 millones de euros entre 1 096 proyectos, con una financiación media de 6,3 millones de euros por proyecto.

La distribución del presupuesto por grandes áreas ofrece una primera visión de conjunto (véase Figura 1). A partir del análisis detallado de los datos, es posible extraer tres ideas principales.

Salud y industria

Los proyectos individuales vinculados a la salud cuentan, de media, con presupuestos superiores al conjunto, un 35 % más altos. En cambio, el área de mundo digital, industria y espacio concentra el 25 % de la oferta total de proyectos.

La primera razón de ello es que la investigación biomédica implica ensayos clínicos complejos; la segunda suele estar relacionada con la necesidad de mantener la competitividad industrial europea. Sin embargo, estos ámbitos no concentran la mayor parte del presupuesto total.

El caso de la inteligencia artificial presenta una mayor complejidad en el seguimiento de la financiación, dado su carácter transversal. La IA se incorpora de distintas formas en el conjunto del programa Horizonte Europa para impulsar objetivos específicos, sin constituir una prioridad independiente.

Clima y medio ambiente: donde se concentra el grueso del dinero

El mayor volumen de financiación se dirige a los ámbitos relacionados con el clima, la energía, la movilidad, la agricultura y el medio ambiente. Estas áreas absorben cerca del 46 % del presupuesto total, unos 3 200 millones de euros. Mirando solo la cifra desnuda, este bloque recibe más del doble de los recursos dedicados a digitalización, industria y el espacio, que se queda en 1 520 millones de euros.

La distribución del presupuesto señala la transición ecológica, y la inversión verde, como eje central de la visión europea de futuro, en línea con evaluaciones del Banco Central Europeo.

Las ciencias sociales en segundo plano

El punto más débil del reparto aparece en los ámbitos sociales. Los bloques dedicados a la cultura, la creatividad, la sociedad inclusiva y a la seguridad civil son los que reciben menos recursos, tanto en términos absolutos como relativos. En conjunto, no alcanzan el 15 % del total. Son los únicos que incorporan explícitamente la palabra “sociedad” en su denominación. Esto no es nuevo. Históricamente, la UE ha priorizado las ciencias naturales, la competitividad industrial y la innovación tecnológica, relegando las ciencias sociales y las humanidades a un papel secundario.

Diversos trabajos académicos apuntan que la tecnología y la inteligencia artificial deben integrarse con las humanidades y las ciencias sociales y económicas. No son ámbitos excluyentes: se refuerzan mutuamente. Los avances técnicos solo tienen sentido cuando responden a necesidades sociales reales.

La dimensión humana como reto

El balance que dibujan los presupuestos es más sobrio de lo que sugieren los grandes anuncios. Europa sitúa la sostenibilidad en el centro de su inversión, con la inteligencia artificial y el desarrollo tecnológico como medios para alcanzar esos fines, no como objetivos en sí mismos. Encaja claramente con lo defendido por la European Climate Foundation, que destaca la necesidad de una transición industrial competitiva e inclusiva orientada hacia una economía sostenible.

La dimensión humana del cambio sigue siendo el aspecto más débil del reparto. Como se ha señalado en distintos análisis críticos, ninguna forma de inteligencia artificial puede sustituir el factor humano, y la inversión pública debería orientarse a beneficios sostenibles y duraderos para la sociedad.

El próximo programa, Horizonte Europa 2028–2034, promete ser más grande, más rápido y con mayor impacto. El desafío, sin embargo, no será solo invertir más, sino garantizar que la transición verde, la digital y la competitividad europea avancen de forma coordinada, sin perder su dimensión humana.

Seguiremos el rastro del dinero para comprobar hasta qué punto el discurso político se traduce en las cifras.

![]()

Rodrigo Maia Valença no recibe salario, ni ejerce labores de consultoría, ni posee acciones, ni recibe financiación de ninguna compañía u organización que pueda obtener beneficio de este artículo, y ha declarado carecer de vínculos relevantes más allá del cargo académico citado.

– ref. Seguir el rastro del dinero de Europa: las cifras de la inversión en ciencia contradicen el discurso – https://theconversation.com/seguir-el-rastro-del-dinero-de-europa-las-cifras-de-la-inversion-en-ciencia-contradicen-el-discurso-272102