Source: The Conversation – France (in French) – By Sophia Galière, Maîtresse de conférences en sciences de gestion, Université Côte d’Azur

Pour changer le monde du travail, il faut repenser le sens des mots que l’on utilise pour en parler. Voici le point de départ de l’ouvrage collectif Un autre monde du travail est possible. Par exemple, comment penser la productivité en dehors du capitalisme et de son injonction à la croissance ? Dans cet ouvrage, 26 experts analysent les mots du monde du travail pour imaginer de nouvelles pratiques d’entrepreneuriat, de management et de travail. Dans ces bonnes feuilles, nous vous proposons des extraits tirés de deux chapitres pour penser l’entreprise autrement, à l’heure des bouleversements environnementaux.

Les organisations sont-elles nécessairement adiaphoriques ? (Bertrand Valiorgue)

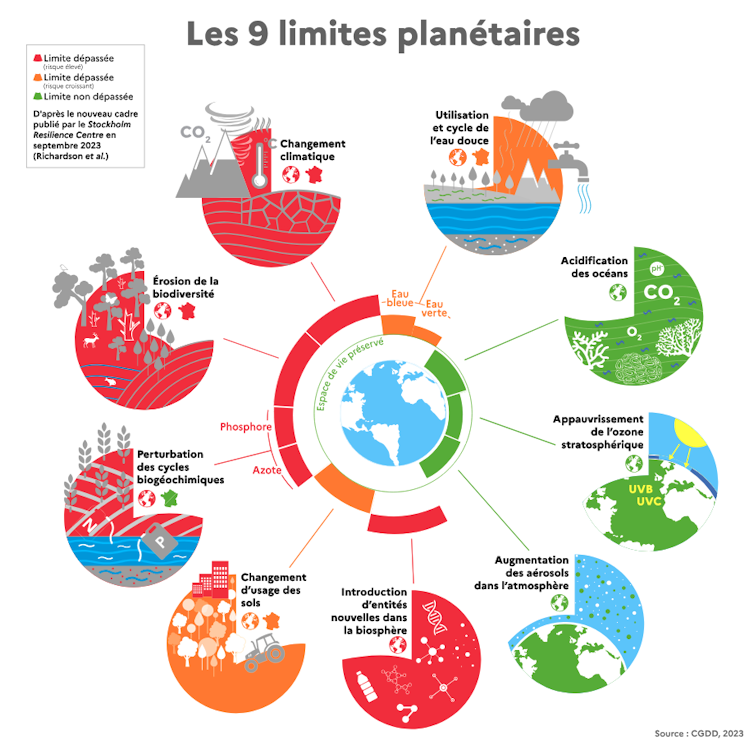

Les désordres climatiques et environnementaux que les sociétés humaines connaissent aujourd’hui, et vont subir de manière amplifiée dans les années qui viennent, sont fabriqués par des organisations et des dynamiques d’action collective. C’est « la société des organisations » qui s’est développée en Occident au sortir de la Seconde Guerre mondiale, et qui s’est aujourd’hui généralisée à l’échelle du globe, qui est directement à l’origine du franchissement des limites planétaires et du basculement dans une nouvelle phase géologique du système Terre que certains nomment l’anthropocène.

Les organisations de cette « société des organisations » ont une caractéristique essentielle qui a été relevée dans le prolongement des travaux de Zygmunt Bauman : elles sont adiaphorisantes. À travers leurs modes de fonctionnement et leurs processus, ces organisations fabriquent de l’indifférence morale et de l’insensibilité de la part de leurs membres à l’égard du vivant et du système Terre. Seul un redimensionnement du travail dans ses dimensions subjectives, objectives et collectives peut conduire à sortir de cet état adiaphorique pour aller vers des organisations qui s’avéreront sensibles et responsables à l’égard du système Terre et de ses composantes. À l’heure du grand basculement dans l’anthropocène et du franchissement des limites planétaires, il est indispensable de penser le travail comme un acte de « renaturation » et de reconnexion à l’égard des liens et dépendances que nous entretenons individuellement et collectivement à l’égard du système Terre.

Nous soutenons […] que c’est d’ailleurs cette adiaphorie organisationnelle généralisée à l’égard du vivant et du système Terre qui est à l’origine du basculement dans une nouvelle phase géologique du système Terre et du franchissement des limites planétaires. Les organisations contemporaines dans lesquelles nous travaillons masquent, invisibilisent et amoralisent les conséquences de leurs actions sur le système Terre. Elles nous plongent dans un état d’adiaphorie généralisée à l’égard du vivant et du système Terre.

[…]

La philosophie morale développée par Bauman nous enseigne que les humains n’ont pas de facultés morales innées et qu’ils peuvent basculer dans la moralité ou l’immoralité en fonction du contexte social (et organisationnel) dans lequel ils sont plongés. La lecture de Bauman est riche d’un second enseignement. Ce dernier considère que seuls les individus, et en aucun cas les entités collectives et les organisations, peuvent être dotées de facultés morales.

CGDD 2023

Bauman considère qu’étendre les préoccupations morales au-delà des individus constitue une erreur ontologique particulièrement grave. Pour Bauman, ce sont les membres d’une organisation qui doivent tracer et pratiquer individuellement un chemin éthique au sein des organisations auxquelles ils appartiennent. Dit autrement, les possibilités de changement proviennent non pas d’un rehaussement moral de l’organisation ou de la personne dite morale mais bien du comportement concret et des engagements quotidiens des individus qui la composent.

[…]

C’est le travail et ses effets plus ou moins adiaphorisants qui est au cœur des grands défis en matière de développement durable que nos sociétés et les organisations qui les composent vont devoir relever. Dans cette perspective, la tâche essentielle qui nous incombe consiste à débusquer les différentes dimensions du travail et les dynamiques organisationnelles qui concourent à l’adiaphorie.

Abonnez-vous dès aujourd’hui !

Chaque lundi, recevez gratuitement des informations utiles pour votre carrière et tout ce qui concerne la vie de l’entreprise (stratégie, RH marketing, finance…).

Contre l’adiaphorie, repenser l’innovation pour la redirection écologique (Aura Parmentier)

L’entrée dans l’ère de l’anthropocène est considérée comme le défi le plus important. Pour faire face à cette menace, l’innovation est souvent considérée comme une source de solutions. Mais peut-on faire confiance à l’innovation pour résoudre nos problèmes contemporains, alors que les défis que nous rencontrons sont souvent la conséquence de la course folle à l’innovation ? Comprendre d’où vient ce terme et les sources de sa théorisation permet de mieux cerner les orientations choisies jusqu’alors ; en retour, penser l’innovation à l’aide d’autres approches offre des voies pour penser les changements qu’appellent les crises environnementales.

[…]

Divers moyens existent pour envisager différemment le travail de conception. Assez traditionnellement, nous pouvons y intégrer des analyses de cycle de vie des produits et services pour réduire l’impact du cycle global, passant de l’extraction des ressources à la conception, puis à la fin de vie du produit. Cette approche est adaptée à la problématique environnementale car elle s’appuie sur une conversion en équivalent CO2. Elle s’inscrit donc dans les réponses possibles à la limitation des gaz à effet de serre. Elle est cependant peu adaptée pour mesurer ou apprécier d’autres problèmes comme l’obsolescence programmée.

Une autre approche consisterait à simplifier les systèmes, voire d’en supprimer une partie. Il s’agit ici de penser l’innovation par le moins, ce que les sociologues Frédéric Goulet et Dominique Vinck appellent « l’innovation par retrait ». Cette approche de l’innovation invite à une réflexion différente quant à la conception, l’utilisation et les usages des innovations. Plusieurs exemples peuvent en être donnés : la mise en place du non-labour en agriculture, mais aussi les circuits courts. Dans ce second cas, « le retrait » étant alors celui d’intermédiaires dans la chaîne de distribution.

À lire aussi :

Peut-on s’en remettre à la sélection naturelle pour faire émerger des innovations durables ?

Puisque la notion d’innovation dans son acception actuelle fait principalement référence à la technologie, il est intéressant de se pencher sur le concept de technologie low-tech développé et popularisé par le spécialiste des ressources minérales Philippe Bihouix. Ce concept offre des perspectives intéressantes, car il s’agit de concevoir des solutions innovantes dans le respect des limites planétaires.

D’ailleurs, Mathieu Arnoux José Halloy, Nicolas Nova et Alexandre Monnin ont proposé les notions de Technologie Zombie Vs Technologie Vivante pour qualifier les technologies selon leur impact sur les limites planétaires dont le vivant. Selon cette typologie, les technologies dites zombies sont à limiter et éviter autant que possible ; tandis que les technologies vivantes sont à favoriser dans la réflexion qu’appelle la redirection écologique. Ces dernières s’appuient sur des ressources renouvelables, les premières ne le sont pas.

De plus, la durée de fonctionnement en état de marche est minimale dans le cas des technologies zombies, mais maximale dans le cas des technologies vivantes. Enfin, la durée en tant que déchet est maximale pour les premières et minimales pour les technologies vivantes.

[…]

En somme, cet exemple illustre les deux approches de l’innovation, l’une centrée principalement sur la croissance économique et l’autre centrée sur la protection de l’environnement. À l’ère des dangers de l’anthropocène, il nous faut choisir notre priorité (la croissance économique ou l’écosystème) et in fine, privilégier un type d’innovation ou un autre.

![]()

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’ont déclaré aucune autre affiliation que leur organisme de recherche.

– ref. Un autre monde du travail est possible – https://theconversation.com/un-autre-monde-du-travail-est-possible-260015