Source: The Conversation – USA – By Brian O’Neill, Professor of Practice, International Affairs, Georgia Institute of Technology

The Trump administration has recently directed that a new wave of polygraphs be administered across the executive branch, aimed at uncovering leaks to the press.

As someone who has taken roughly a dozen polygraphs during my 27-year career with the CIA, I read this development with some skepticism.

Polygraphs carry an ominous, almost mythological reputation among Americans. The more familiar and unofficial term – lie detector tests – likely fuels that perception. Television crime dramas have done their part, too, often portraying the device as an oracle for uncovering the truth when conventional methods fail.

In those portrayals, the polygraph is not merely a tool – it’s a window into the soul.

Among those entering government service, especially in national security, the greater anxiety is not the background check but passing the polygraph. My advice is always the same: Don’t lie.

It’s the best – and perhaps only – guidance for a process that most assessments have concluded is a more subjective interpretation than empirical science.

Why the polygraph persists

Polygraphs are “pseudo-scientific” in that they measure physiological responses such as heart rate, blood pressure and perspiration. The assumption is that liars betray themselves through spikes in those signals. But this presumes a kind of psychological transparency that simply doesn’t hold up. A person might sweat and tremble simply from fear, anger or frustration – not deceit.

There also are no specific physiological reactions associated with lying. The National Academy of Sciences in 2003, and the American Psychological Association in a 2004 review, concluded that the polygraph rests more on theater than fact. Recent assessments, published in 2019, have reached the same conclusion.

Accordingly, polygraph results are not generally admissible in U.S. courts. Only a handful of states – such as Georgia, Arizona and California – permit their use even under limited conditions. And they typically require that both parties agree to admission and a judge to approve it. Unconditional admissibility remains the exception, not the rule.

And yet, inside many national security agencies, polygraphs remain central to the clearance process – a fact I observed firsthand during my time overseeing personnel vetting and analytic hiring within the intelligence community.

While not treated as conclusive, polygraph results often serve as a filter. A candidate’s visible discomfort – or the examiner’s subjective judgment that a response seems evasive – can stall or end the hiring process. For instance, I know that government agencies have halted clearances after an examiner flagged elevated reactions to questions about past drug use or foreign contacts, even when no disqualifying behavior was ultimately documented.

AP Photo/Cliff Owen

In some cases, an examiner’s suggestion that a chart shows an anomaly has led otherwise strong applicants to volunteer details they hadn’t planned to share – such as minor security infractions, undeclared relationships, or casual drug use from decades earlier – that, while not disqualifying on their own, reshape how their trustworthiness is perceived.

The polygraph’s power lies in creating the conditions under which deception is confessed.

A predictable pattern

No administration has been immune to the impulse to investigate leaks. The reflex is bipartisan and familiar: An embarrassing disclosure appears in the press – contradicting official statements or exposing internal dissent – and the White House vows to identify and punish the source. Polygraphs are often part of this ritual.

During his first term, Trump intensified efforts to expose internal dissent and media leaks. Department guidelines were revised to make it easier for agencies to obtain journalists’ phone and email records, and polygraphs were reportedly used to pressure officials suspected of talking to the press. That trend has continued – and, in some areas, escalated.

Recent policies at the Pentagon now restrict unescorted press access, revoke office space for major outlets and favor ideologically aligned networks. The line between legitimate leak prevention and the surveillance or sidelining of critical press coverage has grown increasingly blurred.

At agencies such as the Department of Homeland Security and the FBI, polygraphs are reportedly being used more frequently – and more punitively – to identify internal dissenters. Even “cold cases,” such as the leak of the Supreme Court’s Dobbs opinion ahead of its overturning of Roe v. Wade, have been reopened, despite prior investigations yielding no definitive source.

Government reaction varies

Not all leaks are treated the same. Disclosures that align with official narratives or offer strategic advantage may be quietly tolerated, even if unauthorized. Others, especially those that embarrass senior officials or reveal dysfunction, are more likely to prompt formal investigation.

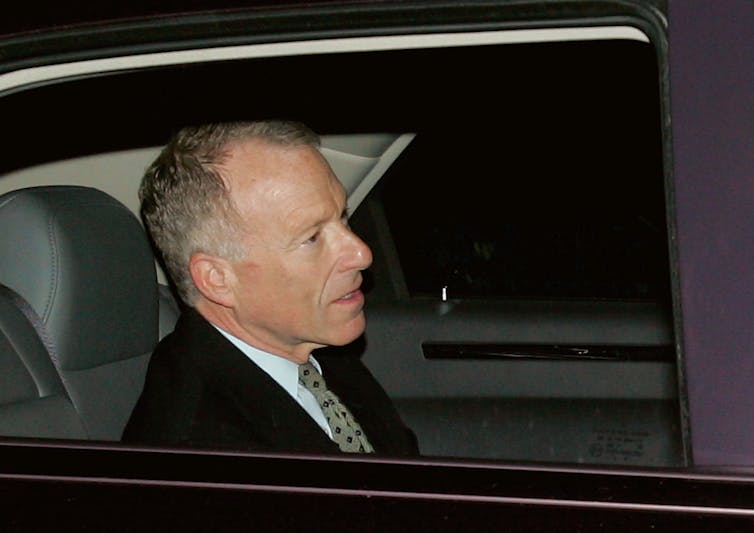

In 2003, for example, the leak of CIA officer Valerie Plame’s identity – widely seen as retaliation for her husband’s criticism of the Iraq War – triggered a federal investigation. The disclosure embarrassed senior officials, led to White House aide Scooter Libby’s conviction for perjury, later commuted, and drew intense political scrutiny.

Win McNamee/Getty Images

Leaks involving classified material draw the sharpest response when they challenge presidential authority or expose internal disputes. That was the case in 2010 with Chelsea Manning, whose disclosure of diplomatic cables and battlefield reports embarrassed senior officials and sparked global backlash. Government reaction often depends less on what was disclosed than on who disclosed it – and to what effect.

A narrow set of disclosures, such as those involving espionage or operational compromise, elicit broad consensus as grounds for prosecution. But most leaks fall outside that category. Most investigations fade quietly. The public rarely learns what became of them. Occasionally, there is a vague resignation, but direct accountability is rare.

What the future holds

Trump’s polygraph campaign is not likely to eliminate leaks to the press. But they may have a chilling effect that discourages internal candor while diverting investigative energy away from core security priorities.

Even if such campaigns succeed in reducing unauthorized disclosures, they may come at the cost of institutional resilience. Historically, aggressive internal enforcement has been associated with declining morale and reduced information flow – factors that can hinder adaptation to complex threats.

Some researchers have suggested that artificial intelligence may eventually offer reliable tools for detecting deception. One recent assessment raised the possibility, while cautioning that the technology is nowhere near operational readiness.

For now, institutions will have to contend with the tools they have – imperfect, imprecise and more performative than predictive.

![]()

As a former US intelligence officer, I am required to submit any written draft, before sharing it with other persons, for prepublication review. I submitted this draft to CIA’s Prepublication Review Board, which responded on 11 June: “No classified information was identified. Therefore, no changes are required for publication or sharing with others.”

– ref. Trump administration’s lie detector campaign against leakers is unlikely to succeed and could divert energy from national security priorities – https://theconversation.com/trump-administrations-lie-detector-campaign-against-leakers-is-unlikely-to-succeed-and-could-divert-energy-from-national-security-priorities-259128