Source: The Conversation – in French – By Esther Kuehn, Professor of Neuroscience, University of Tübingen

Je me suis demandé dernièrement si mon cerveau restera en bonne santé quand je vieillirai. Même si je suis professeure dans un département de neurologie, il m’est difficile d’évaluer si mon cerveau, ou celui de quiconque, souffre d’une neurodégénérescence précoce.

Mon étude récente montre toutefois que la taille d’une partie du cerveau augmente avec l’âge plutôt que de dégénérer.

La raison pour laquelle il est si complexe d’évaluer la neurodégénérescence, c’est que mesurer les petites structures de notre cerveau constitue tout un défi.

Cet article fait partie de notre série La Révolution grise. La Conversation vous propose d’analyser sous toutes ses facettes l’impact du vieillissement de l’imposante cohorte des boomers sur notre société, qu’ils transforment depuis leur venue au monde. Manières de se loger, de travailler, de consommer la culture, de s’alimenter, de voyager, de se soigner, de vivre… découvrez avec nous les bouleversements en cours, et à venir.

Les technologies modernes de neuro-imagerie permettent de détecter une tumeur au cerveau ou une lésion épileptique. Ces anomalies, qui mesurent plusieurs millimètres, peuvent être visualisées grâce à l’imagerie par résonance magnétique (IRM), dont la puissance est environ 30 000 à 60 000 fois supérieure à celle du champ magnétique naturel de la Terre. Le problème est que la pensée et la perception humaines fonctionnent à une échelle plus petite encore.

Certaines zones du cerveau augmentent de volume avec l’âge

La pensée et la perception se produisent dans le néocortex. Cette partie périphérique de notre cerveau est composée de six couches. Lorsqu’on ressent un contact sur son corps, c’est la couche IV du cortex sensoriel qui est activée. Cette couche a la largeur d’un grain de sable, soit une taille bien inférieure à celle que les appareils d’IRM des hôpitaux peuvent généralement représenter.

Quand on module ses sensations corporelles, par exemple quand on peut lire ce texte plutôt que d’avoir conscience de son mal de dos, ce sont les couches V et VI du cortex sensoriel qui s’activent. Elles sont encore plus petites que la couche IV.

Pour mener mon étude publiée dans la revue Nature Neuroscience, j’ai eu accès à un appareil d’IRM 7 Tesla qui offre une résolution cinq fois supérieure à celle des appareils standard. Il permet d’obtenir des instantanés de minuscules réseaux cérébraux lors de la perception et de la pensée.

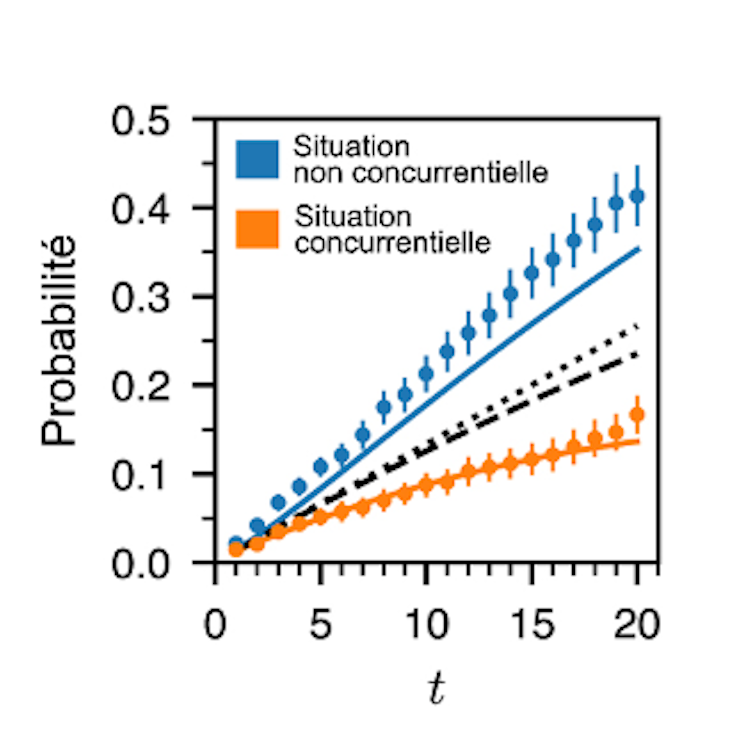

Grâce à cet appareil, mon équipe et moi-même avons pu examiner le cortex sensoriel de jeunes en bonne santé (d’environ 25 ans) et de personnes âgées en bonne santé (d’environ 65 ans) afin de mieux comprendre le vieillissement cérébral. Nous avons constaté que seules les couches V et VI, qui modulent la perception corporelle, présentaient des signes de dégénérescence liée à l’âge.

La couche IV, qui permet de ressentir le toucher, était plus développée chez les personnes âgées en bonne santé. Nous avons aussi mené une étude comparative avec des souris. Nous avons obtenu des résultats similaires chez les souris âgées, qui avaient également une couche IV plus développée que les plus jeunes. Notre étude sur les souris comprenait un troisième groupe de souris très âgées où on a pu observer que cette partie du cerveau pouvait dégénérer à un âge plus avancé.

Selon les théories actuelles, notre cerveau rétrécit avec l’âge. Cependant, les découvertes de mon équipe contredisent en partie ces théories. Il s’agit de la première preuve que certaines zones du cerveau augmentent de volume avec l’âge chez les personnes en bonne santé.

Gorodenkoff/Shutterstock

Le vieillissement cérébral est propre à chaque individu

Les personnes âgées dont la couche IV est plus épaisse devraient être plus sensibles au toucher et à la douleur, et avoir de la difficulté à moduler ces sensations en raison de la diminution des couches profondes.

Pour mieux comprendre cet effet, nous avons étudié un patient d’âge moyen né sans un bras. Ce dernier avait une couche IV plus petite. Comme son cerveau recevait moins d’impulsions qu’une personne ayant deux bras, la masse de la couche IV s’était moins développée. Les parties du cerveau qui sont davantage utilisées forment plus de synapses, et donc plus de masse.

Déjà des milliers d’abonnés à l’infolettre de La Conversation. Et vous ? Abonnez-vous gratuitement à notre infolettre pour mieux comprendre les grands enjeux contemporains.

Plutôt que de dégénérer de manière systématique, le cerveau des personnes âgées semble préserver, au moins en partie, les fonctions qu’il utilise. Le vieillissement cérébral peut être comparé à une machine complexe dans laquelle certaines pièces fréquemment utilisées sont bien huilées, tandis que celles qui le sont moins rouillent. De ce point de vue, le vieillissement cérébral est propre à chaque individu et dépend de son mode de vie, notamment de ses expériences sensorielles, de ses habitudes de lecture et des défis cognitifs qu’il relève au quotidien.

Cela montre également que le cerveau des personnes âgées en bonne santé conserve sa capacité à rester en phase avec son environnement.

Toute une vie d’expériences

Les résultats présentent un autre aspect intéressant. Le schéma des changements cérébraux observés chez les personnes âgées, avec un renforcement de la zone de traitement sensoriel et une réduction des zones responsables de la modulation, possède des similitudes avec des troubles neurodivergents tels que le trouble du spectre de l’autisme ou le trouble déficitaire de l’attention avec hyperactivité.

Ces troubles se caractérisent par une sensibilité sensorielle accrue et une capacité de filtrage restreinte, ce qui entraîne des problèmes de concentration et de flexibilité mentale.

Nos conclusions indiquent-elles que le vieillissement engendre des troubles neurodivergents ? Le cerveau des personnes âgées s’est développé au fil d’une vie d’expériences, tandis que les personnes neurodivergentes naissent avec ces schémas cérébraux. Il est difficile de savoir quels autres effets pourrait avoir la croissance de la masse cérébrale avec l’âge.

Cependant, nos résultats nous fournissent quelques indices sur les raisons pour lesquelles les personnes âgées éprouvent parfois des difficultés à s’adapter à de nouveaux environnements sensoriels. Dans certaines situations, par exemple si elles doivent utiliser un nouvel appareil ou si elles visitent une nouvelle ville, la réduction des capacités de modulation des couches V et VI peut devenir particulièrement manifeste, augmentant ainsi le risque de désorientation ou de confusion.

Cela peut également expliquer pourquoi les capacités à effectuer plusieurs tâches à la fois, comme utiliser un téléphone portable tout en marchant, diminuent avec l’âge. Les informations sensorielles doivent être modulées pour éviter les interférences lors de l’exécution de plusieurs tâches simultanément.

Les couches moyennes et profondes présentaient davantage de myéline, une couche protectrice constituée de graisse et qui est essentielle au fonctionnement et à la communication nerveuse, chez les souris comme chez les humains. Cela indique qu’il pourrait y avoir un mécanisme compensatoire pour la perte de la fonction modulatrice chez les personnes de plus de 65 ans. Cet effet semblait toutefois s’estomper chez les souris très âgées.

Nos résultats démontrent l’influence du mode de vie sur le vieillissement du cerveau.

![]()

Esther Kuehn travaille pour l’Institut Hertie de recherche clinique sur le cerveau et le Centre allemand pour les maladies neurodégénératives (DZNE) de Tübingen. Elle bénéficie d’un financement du Conseil européen de la recherche (CER).

– ref. Une partie du cerveau humain grossit avec l’âge – voici ce que cela signifie pour vous – https://theconversation.com/une-partie-du-cerveau-humain-grossit-avec-lage-voici-ce-que-cela-signifie-pour-vous-263498