Source: The Conversation – in French – By Kévin Jean, Professeur junior en Santé et Changements Globaux, Université Paris Dauphine – PSL

Le 12 décembre 2015, 196 gouvernements adoptaient l’Accord de Paris, qui ambitionnait de réduire les émissions de gaz à effet de serre pour lutter contre le changement climatique. 10 ans plus tard, les mesures prises par les États restent insuffisantes pour atteindre les objectifs fixés. Un retard d’autant plus dommageable que les mesures permettant d’améliorer le climat ont aussi des bénéfices conséquents en matière de santé publique. Explications.

L’urgence climatique impose une transformation profonde de nos systèmes énergétiques, de notre économie et de nos modes de vie. Or, ces transformations sont largement présentées dans le débat public sous l’angle des coûts à payer : investissements publics et privés, possibles pertes d’emplois dans certains secteurs, ou tout simplement coût du changement. Or, la transition écologique en vue de l’atteinte de la neutralité carbone (qui, rappelons-le, constitue la condition physique à la stabilisation du climat) peut également représenter des bénéfices, et en particulier dans le domaine de la santé.

C’est pour documenter l’ampleur de ces bénéfices que nous avons effectué une revue systématique de la littérature scientifique récente, et synthétisé 58 études ayant modélisé l’impact sur la santé humaine de 125 scénarios atteignant la neutralité carbone en 2050.

Les résultats de nos travaux, parus dans la revue The Lancet Planetary Health, sont sans appel : en plus d’être indispensables pour limiter les changements climatiques, les mesures prises dans ces scénarios ont le potentiel d’offrir des gains importants et immédiats pour la santé des populations.

Un enjeu non seulement climatique, mais également de santé publique

Alors que 3,6 milliards de personnes vivent déjà dans des zones très sensibles au changement climatique, celui-ci pourrait causer environ 250 000 décès supplémentaires par an d’ici 2030 et engendrer entre 2 et 4 milliards de dollars de dommages sanitaires directs chaque année, selon les projections de l’Organisation mondiale de la Santé.

Il y a 10 ans, le 12 décembre 2015, 196 gouvernements ont adopté l’Accord de Paris, qui visait à réduire les émissions anthropiques de gaz à effet de serre (GES) afin de contenir l’élévation de la température moyenne de la planète en dessous de 2 °C par rapport aux niveaux préindustriels.

Malheureusement, les engagements nationaux actuels restent insuffisants pour atteindre ces objectifs. Ils placent actuellement nos sociétés sur une trajectoire de réchauffement de +2 à +3 °C d’ici la fin du siècle.

Or, les conséquences du changement climatique ont des effets sur la santé humaine. Ces derniers peuvent être directs, lorsqu’ils résultent de modifications des schémas climatiques, ou indirects, quand ils découlent de perturbations des écosystèmes, des systèmes alimentaires, des infrastructures ou des conditions sociales.

Les canicules relèvent par exemple de la première catégorie : à l’échelle européenne, on estime que sur les 2 300 décès dus à la chaleur survenus lors de la canicule de juin 2025, 1 500 sont directement attribuables au changement climatique.

En ce qui concerne les conséquences indirectes, on peut citer l’expansion des insectes vecteurs de certaines maladies, comme le moustique tigre (Aedes albopictus). Cet insecte propage notamment le virus chikungunya, à l’origine d’un nombre de cas autochtones sans précédent dans l’Hexagone en 2025.

Pourtant, si ces risques pour la santé sont de mieux en mieux décrits, leur connaissance ne suffit à l’évidence pas à impulser des mesures d’atténuation suffisantes.

Étant donné que la menace climatique, pourtant étayée scientifiquement, ne semble pas constituer un levier suffisant pour entraîner l’action, nous proposons d’adopter une autre approche, plus positive : expliquer les impacts, très souvent bénéfiques, que les politiques de réduction des gaz à effet de serre peuvent avoir sur la santé publique.

Les résultats de notre revue de la littérature scientifique sur ce sujet sont éloquents.

Des bénéfices sanitaires d’ampleur

Parmi 96 scénarios visant à atteindre la neutralité carbone comparés dans notre revue de littérature, 94 ont prédit que les politiques préconisées pour améliorer le climat auront aussi des impacts sanitaires favorables. Et ce, avant même que les effets des mesures d’atténuation prises ne modifient l’évolution du climat (laquelle devrait avoir elle aussi, à terme, des effets bénéfiques sur la santé).

Les études disponibles se concentrent principalement sur l’amélioration de trois déterminants de santé : l’alimentation, la qualité de l’air et l’activité physique.

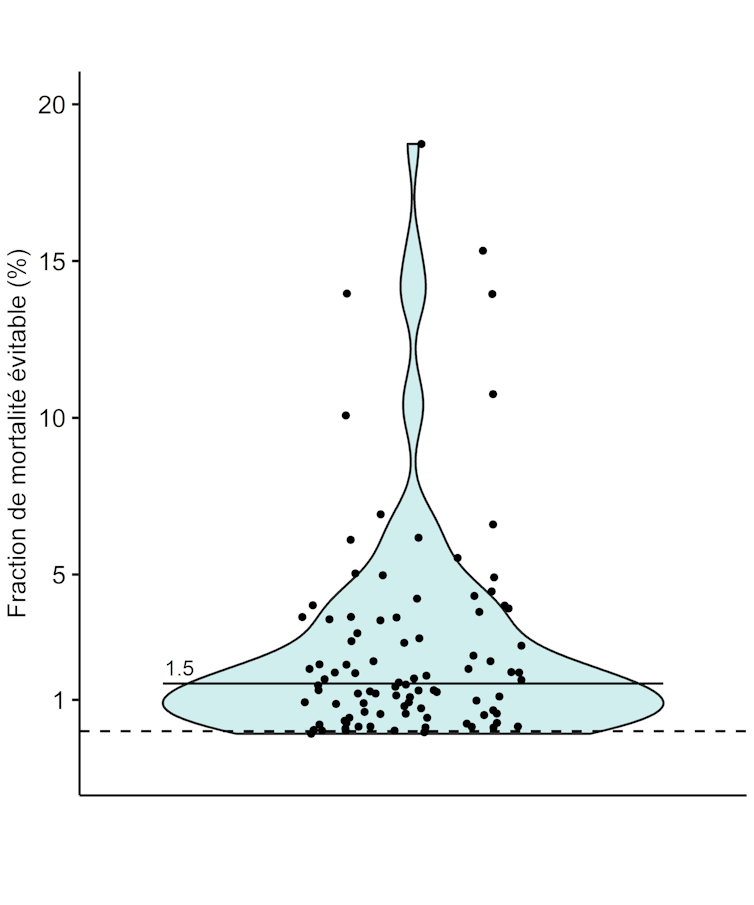

La moitié des scénarios anticipent une réduction de la mortalité de plus de 1,5 %, soit environ 10 000 décès par an en France. Pour donner un ordre d’idée, ce chiffre représente le nombre de décès annuels par suicide ou à cause du cancer du foie. Les accidents dus aux transports représentent quant à eux environ 2 500 décès par an. De plus, cette valeur de 1,5 % de réduction de la mortalité prématurée est très vraisemblablement à interpréter comme une sous-estimation des bénéfices sanitaires de politiques de neutralité carbone, car une grande partie des scénarios ne se sont intéressés qu’à la qualité de l’air, en négligeant l’alimentation et l’activité physique.

Moutet, L. et al (2025), The Lancet Planetary Health

Ces résultats sont cohérents avec ceux d’autres études établissant que l’adoption de régimes alimentaires plus sains, l’arrêt de la combustion d’énergie fossile et la pratique régulière d’une activité physique pourraient éviter respectivement 10, 5 et 4 millions de décès annuel dans le monde.

Ces co-bénéfices mèneraient à des améliorations de l’ordre de celles attendues à la suite de la mise en place de politiques de santé publique ambitieuses. Et ce, alors qu’ils ne font que découler de la mise en place de mesures visant à améliorer le climat, rappelons-le…

Trois caractéristiques intéressantes

Les co-bénéfices sanitaires auraient également trois caractéristiques particulièrement intéressantes :

1. Ils s’accompagnent de co-bénéfices économiques : onze des treize études ayant comparé les coûts de mise en œuvre des politiques climatiques avec leurs bénéfices sanitaires concluent que les gains économiques issus de la réduction de la mortalité dépassent les investissements initiaux. La diminution des maladies cardiovasculaires et respiratoires réduirait les pressions sur les systèmes de santé, entraînerait des gains de productivité et une baisse des arrêts maladie. Par ailleurs, d’autres bénéfices économiques apparaissent également, tels que la création d’emplois, l’amélioration de la résilience énergétique et l’augmentation des rendements agricoles.

2. Ils permettent une amélioration à court terme de la santé publique : comme mentionné précédemment, ces co-bénéfices permettent d’améliorer rapidement la santé humaine, car ils sont consécutifs à la mise en place des stratégies d’atténuation destinées à atteindre la neutralité carbone. Diminuer la pollution de l’air et promouvoir les modes de transport actifs ainsi qu’une alimentation de meilleure qualité se traduit par une amélioration immédiate des capacités cardiovasculaires, respiratoires et de la santé mentale, tout en diminuant l’incidence de certains cancers à plus long terme.

Nul besoin d’attendre d’avoir atteint la neutralité carbone, laquelle pourrait n’être atteinte qu’à moyen terme, voire à long terme (2030 à 2035 dans le meilleur des cas pour l’agriculture, 2050 pour l’industrie), étant donné la durée pendant laquelle persistent les gaz à effet de serre dans l’atmosphère (en particulier le CO2).

3. Ils ne nécessitent pas d’action coordonnée à l’échelle mondiale : les co-bénéfices sanitaires des politiques d’atténuation se manifestent indépendamment des efforts d’autres pays. Autrement dit, un pays qui adopte des mesures de réduction des émissions profite directement d’une amélioration de la santé de sa population, même si d’autres nations tardent à agir. Ce n’est pas le cas des bénéfices climatiques, puisque leur obtention nécessite que tous les pays participent. Cet aspect est crucial pour l’adhésion politique et citoyenne aux politiques climatiques.

Un appel à l’action pour une politique climatique et sanitaire conjointe

Prendre du retard dans la transition vers la neutralité carbone, ce n’est donc pas seulement payer un coût environnemental plus élevé : c’est aussi manquer l’opportunité d’améliorer la santé humaine.

Les politiques d’atténuation devraient être considérées non seulement comme une nécessité climatique, mais aussi comme un levier efficace de transformation de la santé publique. Plutôt que de voir la transition écologique comme un coût, les décideurs politiques et les acteurs économiques doivent la considérer comme un investissement dans la santé et le bien-être présent et futur des populations.

Cette perspective pourrait accélérer l’adoption de mesures ambitieuses et renforcer l’acceptabilité sociale et la mise en place de politiques climatiques cohérentes avec l’accord de Paris.

![]()

Kévin Jean est membre du conseil d’administration de l’association Science Citoyennes.

Laura Temime et Léo Moutet ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’ont déclaré aucune autre affiliation que leur poste universitaire.

– ref. Atteindre les objectifs climatiques améliorera aussi la santé publique – https://theconversation.com/atteindre-les-objectifs-climatiques-ameliorera-aussi-la-sante-publique-270826