Source: The Conversation – France (in French) – By Mireya Mayor, Director of Exploration and Science Communication, Florida International University

La primatologue britannique Jane Goodall, figure mondiale de la protection de l’environnement et pionnière de l’étude des chimpanzés, est morte le 1er octobre à l’âge de 91 ans. Sa consœur Mireya Mayor lui rend hommage.

Toute personne qui voudrait proposer un cours magistral sur l’art de changer le monde en mieux, sans sombrer dans le négatif, le cynisme, la colère ou l’étroitesse d’esprit, pourrait s’inspirer de la vie et de l’œuvre de la pionnière de l’éthologie Jane Goodall.

Son parcours débute dans les années 1930, lorsqu’enfant, elle observe émerveillée, dans son jardin anglais, des créatures en apparence banales – même si elle ne les aurait jamais qualifiées ainsi. Il la conduit ensuite jusqu’aux forêts de Tanzanie, où ses recherches sur les chimpanzés ont remis en question la définition même de ce qui fait l’humain. De là, elle est devenue une icône mondiale et Messagère de la paix des Nations unies.

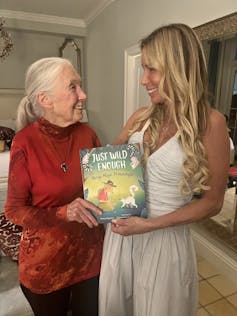

Jusqu’à sa mort le 1ᵉʳ octobre 2025 à l’âge de 91 ans, Jane Goodall a conservé ce charme, cette ouverture d’esprit, cet optimisme et cette capacité d’émerveillement qu’on attribue plutôt aux enfants. Je peux en témoigner, ayant eu la chance de passer du temps à ses côtés et de partager avec elle les enseignements de ma propre carrière scientifique.) Pour le grand public, elle était une chercheuse de renommée mondiale et une figure emblématique. Pour moi, elle était Jane – une mentor inspirante et une amie.

Malgré les bouleversements qu’elle a introduits dans la science en transformant l’étude du comportement animal, Jane Goodall est toujours restée souriante, encourageante et stimulante. Je la considère comme une douce perturbatrice. L’un de ses plus grands dons était sa capacité à faire sentir à chacun, quel que soit son âge, qu’il avait le pouvoir de changer le monde.

Découverte de l’usage d’outils chez les animaux

Dans ses recherches pionnières menées dans la luxuriante forêt du Gombe Stream Game Reserve en Tanzanie – aujourd’hui parc national –, Jane Goodall observa que les chefs chimpanzés les plus respectés étaient ceux qui se montraient doux, attentionnés et proches de leur groupe. Les mâles qui tentaient d’imposer leur autorité par la violence, la tyrannie ou la menace ne parvenaient pas à durer.

Également primatologue, j’ai moi-même étudié les observations fondatrices de Goodall à Gombe. Elle a notamment décrit comment des chimpanzés prenaient de longues brindilles d’herbe pour les introduire dans les termitières et « pêcher » les insectes pour s’en nourrir, une pratique que personne n’avait encore observée. C’était la première fois qu’un animal était vu utilisant un outil, une découverte qui allait bouleverser la frontière que les scientifiques traçaient entre l’humanité et le reste du règne animal.

Le célèbre anthropologue Louis Leakey avait choisi Goodall pour mener ce travail précisément parce qu’elle n’avait pas de formation académique formelle. Lorsqu’elle s’était présentée dans son bureau en Tanzanie en 1957, à l’âge de 23 ans, il l’avait d’abord embauchée comme secrétaire. Mais il avait rapidement perçu son potentiel et l’avait encouragée à étudier les chimpanzés. Leakey voulait une approche totalement neuve, libre de tout biais scientifique, persuadé que la plupart des chercheurs perdaient cette ouverture d’esprit au fil de leur formation.

Puisque les chimpanzés sont les plus proches parents vivants des humains, Leakey espérait que leur observation apporterait des indices sur nos propres ancêtres. Dans un milieu alors largement masculin, il pensait aussi qu’une femme saurait se montrer plus patiente et perspicace qu’un homme. Il avait vu juste. Six mois après le début de ses recherches, lorsque Goodall rédigea ses notes sur l’usage d’outils, Leakey écrivit : « Nous devons désormais redéfinir l’outil, redéfinir l’Homme, ou accepter les chimpanzés comme humains. »

Goodall parlait des animaux comme d’êtres dotés d’émotions et de cultures, et, dans le cas des chimpanzés, de véritables communautés presque tribales. Elle leur donnait des noms, une pratique alors inconcevable dans le monde scientifique, où l’on se contentait de numéroter les sujets d’étude. Elle essuya de vives critiques pour cette approche humanisante.

Parmi ses observations les plus marquantes figure ce qui est resté dans l’histoire comme la « guerre des chimpanzés de Gombe ». Ce conflit, qui dura quatre ans, vit huit mâles adultes d’une communauté exterminer les six mâles d’un autre groupe pour s’approprier leur territoire, avant de perdre eux-mêmes ce territoire au profit d’une troisième communauté, plus nombreuse et avec plus de mâles.

Confiance en son destin

Jane Goodall était persuasive, déterminée et dotée d’une grande force de conviction. Elle me conseillait souvent de ne pas céder face aux critiques. Ses découvertes révolutionnaires ne sont pas nées de la compétition ou du besoin d’évincer les autres, mais d’un émerveillement profond, d’un amour des animaux et d’une imagination débordante. Petite fille, elle était fascinée par l’histoire de Tarzan chez les singes, d’Edgar Rice Burroughs (1912), et aimait plaisanter en disant que Tarzan avait épousé la mauvaise Jane.

À 23 ans, ancienne pom-pom girl de la NFL sans aucune formation scientifique, j’ai découvert son travail et me suis dit que moi aussi, je pouvais suivre ses traces. C’est en grande partie grâce à elle que je suis devenue primatologue, que j’ai co-découvert une nouvelle espèce de lémurien à Madagascar et que j’ai eu une vie professionnelle et personnelle extraordinaire, à la fois dans les sciences et à la TV, comme exploratrice de National Geographic. Lorsque j’ai écrit mon propre récit, j’ai demandé à Jane Goodall d’en rédiger l’introduction. Elle a écrit :

« Mireya Mayor me rappelle un peu moi-même. Comme moi, elle aimait être au contact des animaux lorsqu’elle était enfant. Et comme moi, elle a poursuivi son rêve jusqu’à le réaliser. »

Conteuse et pédagogue

Jane Goodall était une narratrice exceptionnelle, convaincue que raconter des histoires était le moyen le plus efficace pour faire comprendre aux gens la véritable nature des animaux. Avec des images saisissantes, elle partageait des récits extraordinaires sur l’intelligence des animaux, des singes et dauphins aux rats et aux oiseaux, sans oublier les pieuvres. Elle m’a inspirée à devenir correspondante animalière pour National Geographic afin de partager, à mon tour, les histoires et les menaces qui pèsent sur les espèces en danger à travers le monde.

Elle a inspiré et conseillé des dirigeants, des célébrités, des scientifiques et des défenseurs de l’environnement, tout en touchant la vie de millions d’enfants.

Mireya Mayor, CC BY-ND

À travers le Jane Goodall Institute, qui s’efforce de mobiliser les populations du monde entier pour la conservation, elle a lancé Roots & Shoots, un programme international pour les jeunes présent dans plus de 60 pays. Ce programme enseigne aux enfants les liens entre les humains, les animaux et l’environnement, et leur montre comment agir localement pour protéger les trois.

Au-delà de sa chaleur humaine, de son amitié et de ses récits fascinants, je garde précieusement cette phrase de Jane Goodall : « Le plus grand danger pour notre avenir, c’est notre indifférence. Chacun de nous doit assumer la responsabilité de sa propre vie et, surtout, montrer respect et amour envers les êtres vivants qui nous entourent, en particulier envers les autres. »

Une idée radicale, portée par une scientifique hors du commun.

![]()

Mireya Mayor ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Jane Goodall, la discrète révolutionnaire dont les recherches sur les chimpanzés ont redéfini notre conception de l’humanité – https://theconversation.com/jane-goodall-la-discrete-revolutionnaire-dont-les-recherches-sur-les-chimpanzes-ont-redefini-notre-conception-de-lhumanite-266600