Source: The Conversation – Indonesia – By Claude Lelièvre, Enseignant-chercheur en histoire de l’éducation, professeur honoraire à Paris-Descartes, Université Paris Cité

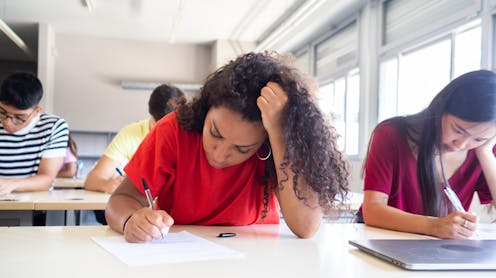

À quoi les premières sessions du baccalauréat ressemblaient-elles ? Quand le brevet des collèges a-t-il été créé ? À partir de quand l’université s’est-elle féminisée ? En quelques grandes questions, retour sur l’histoire des examens alors que les lycéens et étudiants passent les dernières épreuves de l’année.

Le recours systématique à l’organisation d’examens et à la collation de « grades » attestés dans des diplômes pour valider les connaissances acquises par l’enseignement est une pratique apparue avec les premières universités médiévales au tournant des XIIe et XIIIe siècles.

L’élément central du dispositif a été la licence qui, de simple acte juridique (l’octroi d’une « autorisation », d’un « droit d’enseigner ») s’est assez vite transformée en « examen » et en « grade » pour se retrouver elle-même encadrée rapidement par deux autres grades, eux-mêmes conférés après examen : le baccalauréat d’abord et la maîtrise ensuite.

Ce dispositif « à trois étages » de validation des connaissances s’est imposé partout. La quasi stabilité du vocabulaire qui permet de le décrire – baccalauréat (certes parfois appelé « determinatio »), licence, maîtrise (ou master) – est la meilleure preuve de sa prégnance qui a survécu jusqu’à nos jours.

Alors que les lycéens passent les dernières épreuves du bac et que les étudiants guettent leurs résultats de fin d’année, retour en cinq questions sur l’histoire des premiers examens du parcours scolaire.

À quoi le baccalauréat servait-il lorsqu’il a été institué en 1808 ?

Il a gardé de l’ancien baccalauréat sa face universitaire et il a été le point de départ des baccalauréats dits « généraux » que nous connaissons. Mais avec une grande différence, au début, puisqu’il s’agissait d’un examen entièrement oral dont le jury était uniquement composé d’universitaires.

Le statut du 16 février 1810 précise que les examinateurs du baccalauréat doivent être au nombre de trois universitaires. Cet examen oral porte sur « tout ce que l’on enseigne dans les hautes classes des lycées » (les deux dernières). Peu à peu, des épreuves écrites sont ajoutées. Surtout, peu à peu également, le jury qui fait effectivement passer l’examen du baccalauréat comporte de moins en moins d’universitaires et de plus en plus de professeurs du secondaire.

Pour Napoléon Ier qui a été le créateur de ce baccalauréat, il s’agissait avant tout d’instruire dans les lycées nouvellement créés les futurs officiers et hauts administrateurs de son Empire. De fait, selon l’expression du philosophe Edmond Goblot, le baccalauréat a été tout au long du XIXe siècle « un brevet de bourgeoisie ».

Quand les filles ont-elles eu pour la première fois accès au lycée et à l’université ?

Même quand la loi Camille Sée de décembre 1880 institue avec le soutien de Jules Ferry des établissements d’enseignement secondaire féminin publics, les filles peuvent très difficilement passer le baccalauréat et suivre un cursus à l’université. En effet, à la différence des lycées de garçons institués en 1802, le plan d’études des lycées de jeunes filles ne comporte pas les disciplines qui sont alors le fleuron de l’enseignement secondaire et du baccalauréat : le latin, le grec et la philosophie.

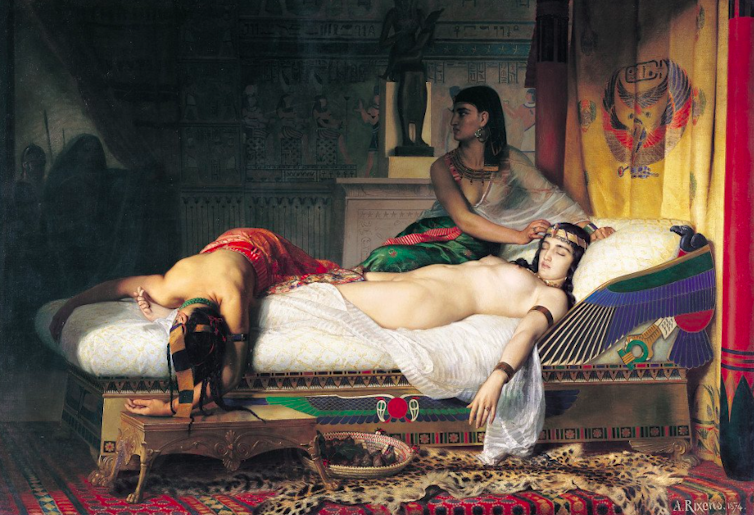

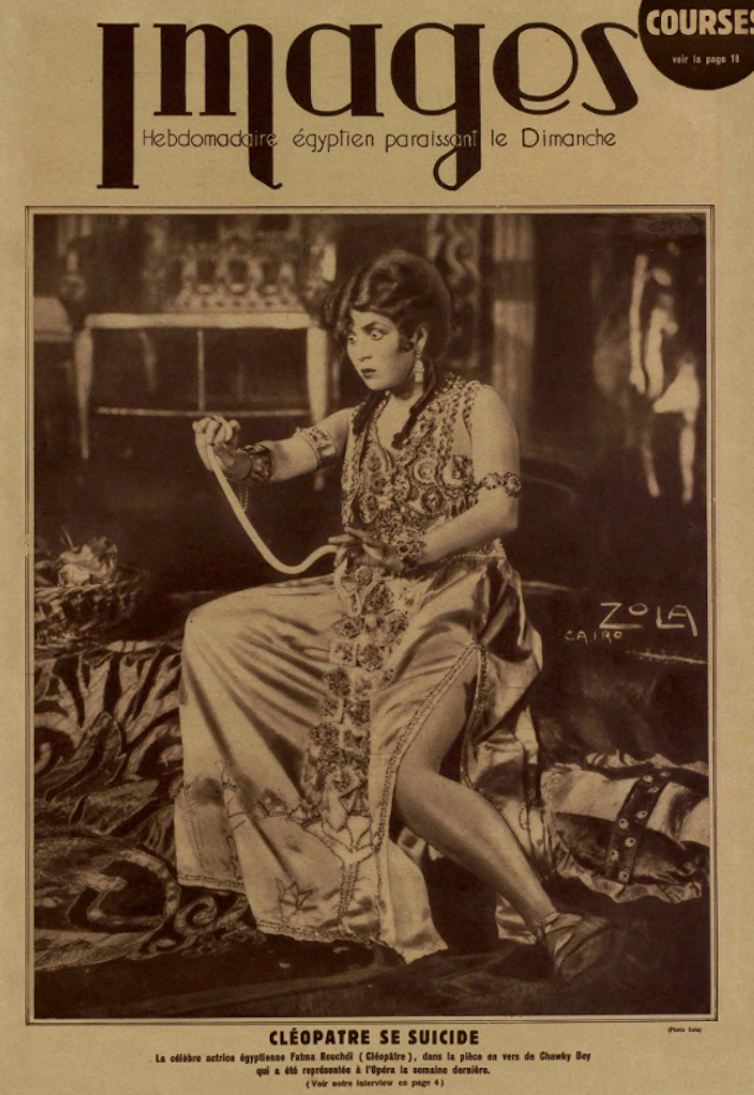

Wikimedia

Mais le baccalauréat n’est pas juridiquement interdit aux jeunes filles ; et certaines d’entre elles le passeront en candidates libres : une trentaine en 1890, une centaine en 1909. La première bachelière qui a obtenu le diplôme du baccalauréat est Julie Daubié, en 1861. Elle sera aussi la première licenciée es lettres française en 1871.

Il a fallu presque un demi-siècle pour qu’un décret en date du 25 mars 1924 aménage officiellement une préparation au baccalauréat présentée comme une section facultative alignée totalement sur le secondaire masculin, tout en perpétuant un enseignement secondaire féminin spécifique institué en 1880 (avec son diplôme spécifique de « fin d’études secondaires », au titre significatif…).

À lire aussi :

Histoire : la longue marche des filles vers l’université

Les jeunes filles commencent alors leur « longue marche » conquérante. Dès 1936, les jeunes filles représentent le quart des élèves reçus à l’examen du baccalauréat. En 1965, leur taux d’accès arrive au même niveau que celui des garçons : 13 % de la classe d’âge. Et le pourcentage de jeunes filles inscrites à l’université monte vite : un quart des étudiants en 1930, un tiers en 1950, pour atteindre la moitié en 1981.

Pourquoi a-t-on créé le brevet ?

D’abord, de quel brevet parle-t-on ? Au XIXe siècle, le « brevet » est d’abord et avant tout un « brevet de capacité » qui certifie que l’on est « en capacité » de devenir maître (ou maîtresse) d’école, et plus généralement un examen qui est parfois requis pour être « en capacité » d’exercer certains métiers appartenant à ce que l’on appellerait maintenant la sphère des cadres intermédiaires.

Tous les quinze jours, nos auteurs plongent dans le passé pour y trouver de quoi décrypter le présent. Et préparer l’avenir. Abonnez-vous gratuitement dès aujourd’hui !

En 1947, dès le début de la forte augmentation du taux de scolarisation dans l’enseignement secondaire qui commence sous la IVe République, le « brevet » est transformé en « brevet d’études du premier cycle du second degré » (BEPC), son appellation nouvelle signant ce qu’il est devenu avant tout, à savoir un examen qui scande un cursus secondaire désormais clairement constitué de deux cycles. Mais ce n’est nullement une condition pour passer en classe de seconde et cela ne l’a jamais été jusqu’ici, même si cela est envisagé.

À partir de 1981, le diplôme – désormais intitulé « brevet des collèges » – est attribué sans examen, au vu des seuls résultats scolaires. Mais, en 1986, un « examen écrit » est réintroduit avec le triple objectif annoncé de « revaloriser le diplôme », de « motiver » davantage les élèves, et de les « préparer » à aborder des examens ultérieurement. Lors de sa première mouture, le taux de reçus n’a pas dépassé 49 %.

CAP, BEP, bac pro : quand les diplômes de la voie professionnelle ont-ils été créés ?

Le certificat d’aptitude professionnelle (CAP), destiné à sanctionner un apprentissage, est institué en 1911. Cet examen est réservé aux « jeunes gens et jeunes filles de moins de dix-huit ans qui justifient de trois années de pratiques dans le commerce et l’industrie » (décret du 24 octobre 1911). Mais comme le CAP n’a pas été rendu obligatoire ni même associé à une grille de rémunération, le CAP demeurera un diplôme rare dans un premier temps.

Le brevet d’enseignement professionnel (BEP) a été créé en 1966. Il a été institué dans le but de remplacer progressivement le CAP en ayant un caractère plus théorique et moins pratique. Préparé en deux ans après la classe de troisième, il relevait d’une conception plus scolaire de la qualification ouvrière face aux exigences techniques de l’industrie et du commerce modernes.

À lire aussi :

Lycée : surmonter les clichés sur la voie professionnelle

Le baccalauréat professionnel, institué en 1985, parachève cette évolution. Selon Jean-Pierre Chevènement, le ministre de l’éducation nationale, il s’agit en premier lieu de répondre aux besoins de la modernisation du pays en formant des « ouvriers » de plus en plus qualifiés, « souvent au niveau du baccalauréat, quelquefois à un niveau supérieur encore »(28 mai 1985).

Quand le bac s’est-il vraiment démocratisé ?

Le taux de titulaires d’un baccalauréat dans une classe d’âge donnée a été longtemps très restreint ce qui induit qu’il était réservé de fait, sauf exception, aux enfants de milieux socioculturellement favorisés. Il a été de moins de 3 % tout au long de la IIIe République. Et c’est seulement dans les dernières années de cette période que les établissements secondaires publics sont devenus gratuits, alors que c’était déjà le cas pour les établissements primaires publics depuis le début des années 1880.

Il y a eu alors un petit desserrage dans la sélection sociale, concomitant avec la montée du taux de titulaires du baccalauréat dans une classe d’âge. Mais la grande période de l’envolée du taux de bacheliers généraux se situe dans la période gaullienne : on passe de 10 % à 20 % de 1959 à 1969. Il reste à peu près à cet étiage durant presque vingt ans.

Mais un autre baccalauréat est créé en 1970 : le « baccalauréat technologique ». Il va apporter un taux supplémentaire de titulaires d’un baccalauréat dans une classe d’âge : autour de 16 % – un taux qui reste quasiment constant depuis 1989. Les élèves des lycées technologiques sont d’origines socioculturelles plutôt modestes, et leurs destinations scolaires ou sociales aussi.

En 1985, une troisième couche apparaît : le « baccalauréat professionnel ». Le 8 octobre 1985, le ministre Jean-Pierre Chevènement précise qu’il s’agit « d’offrir, à l’issue de la classe de troisième, trois voies d’égale dignité » :

-

la voie générale, dans laquelle « peuvent s’engager ceux qui ont les capacités de poursuivre des études aux niveaux les plus élevés de l’Université » ;

-

la voie technologique, « qui conduira la majorité des jeunes qui s’y engagent vers un niveau de technicien supérieur » ;

-

la « voie professionnelle, qui assure, après l’obtention d’une qualification de niveau V, une possibilité de poursuivre la formation jusqu’au niveau du baccalauréat et même vers un niveau plus élevé ».

Il y a donc l’affirmation par le titre de baccalauréat d’une égalité de dignité, mais non d’un égalité de parcours – même si l’obtention du baccalauréat permet juridiquement l’entrée à l’Université. Entre 1987 et 2008, le taux de bacheliers professionnel dans une classe d’âge atteint 12 %, puis passe de 12 % en 2008 à 24 % en 2012 (en raison d’un changement de curriculum). Il se stabilise ensuite autour de 21 %.

Par ailleurs, dans le cadre de l’horizon annoncé par Jean-Pierre Chevènement de « 80 % d’une classe d’âge au niveau bac en l’an 2000 », on a une nouvelle accélération du taux de titulaires d’un baccalauréat général dans une classe d’âge qui passe de 22 % en 1987 à 37 % en 1995. Ces dernières années, il atteint 43 %.

![]()

Claude Lelièvre ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Bac, brevet, CAP : petite histoire des examens en cinq questions – https://theconversation.com/bac-brevet-cap-petite-histoire-des-examens-en-cinq-questions-257574