Source: The Conversation – France in French (3) – By Stefania Di Stefano, Chercheuse postdoctorale au sein de la Chaire sur la modération des contenus, Conservatoire national des arts et métiers (CNAM)

Alors même que, aux États-Unis, la liberté d’expression, la liberté des médias ou encore la liberté académique font l’objet d’attaques sans précédent de la part de l’administration Trump, Washington prétend que c’est l’Union européenne qui serait un dangereux censeur. En cause : les mesures visant à modérer les contenus haineux sur les réseaux sociaux.

Comment déterminer la maturité d’une démocratie ? Comment reconnaître qu’elle sombre progressivement vers un régime autoritaire ?

Le début du second mandat présidentiel de Donald Trump incarne sans aucun doute un tel glissement, avec fracas et sans souci pour l’image de bienséance qu’une personne exerçant une telle fonction devrait renvoyer. Depuis le retour du milliardaire new-yorkais à la Maison Blanche le 20 janvier, les attaques contre les libertés sur le territoire états-unien sont nombreuses et variées.

Les universités ont été l’une des premières cibles du président. Gel des fonds fédéraux, instrumentalisation du système d’accréditation universitaire pour influencer les formations, révocation des visas pour les étudiants étrangers… Autant de mesures attaquant frontalement la liberté académique. Des mesures visant surtout à remodeler l’éducation supérieure selon une idéologie définie par le régime trumpiste et restreignant la libre pensée.

La liberté de la presse n’est pas épargnée par la nouvelle version du « free speech » portée par le président. Dernière victime à avoir été « fired » : Stephen Colbert, présentateur du populaire « Late Show » sur CBS. Cette émission satirique s’attaquait régulièrement et sans ménagement à Donald Trump. Elle n’a plus sa place dans les programmes télévisés. Pour dénoncer le silence s’installant progressivement dans les médias, la série humoristique South Park a sorti un nouvel épisode caricaturant le président, laissant cependant un sentiment amer aux spectateurs.

À lire aussi :

Donald Trump à l’assaut des médias publics aux États-Unis

Pourtant, et dans une sorte d’inversement psychologique, Washington accuse l’Union européenne (UE) de mettre en œuvre, sur le Vieux Continent, une censure massive.

Les textes européens dans le viseur de l’administration Trump

Si l’UE est critiquée, c’est en réalité pour les valeurs qu’elle représente et pour les libertés qu’elle protège. En effet, les États-Unis dépeignent l’encadrement juridique des plateformes numériques à l’œuvre au sein de l’UE comme la manifestation d’une censure quasi orwelienne.

Se fondant sur un rapport à charge, la Commission judiciaire de la Chambre des représentants a tenu une audition sur « la menace européenne sur la liberté d’expression et l’innovation américaines », affirmant notamment que le Règlement sur les services numériques (Digital Services Act, DSA) porte atteinte au droit des Américains de s’exprimer librement en ligne aux États-Unis.

Pour rétablir les faits et la correcte interprétation du droit européen, une coalition d’universitaires européens et américains a transmis une lettre expliquant les principales applications du DSA.

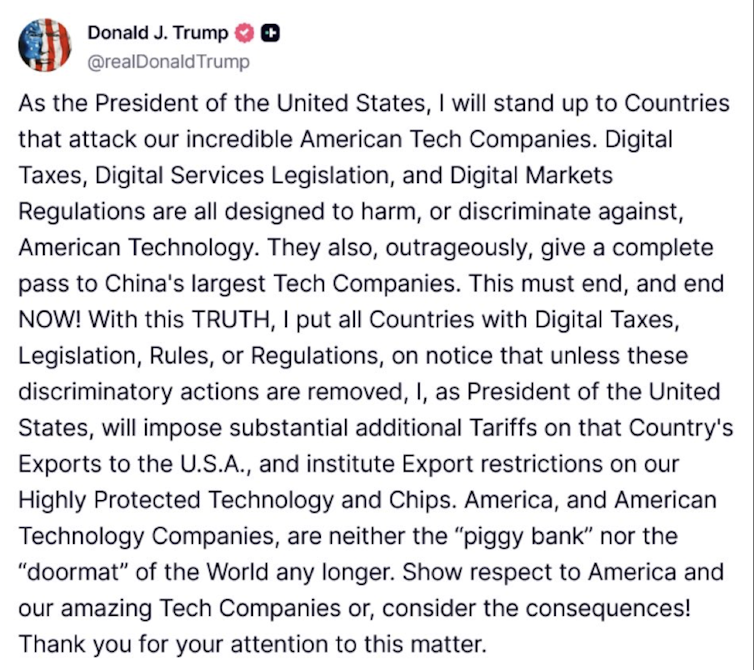

Se présentant en « défenseur de la démocratie », l’administation Trump utiliserait même la suspension des enquêtes ouvertes à l’encontre des grandes entreprises technologiques américaines comme monnaie d’échange dans les négociations douanières avec la Commission européenne. Les plateformes ont en effet comparé les sanctions imposées pour violation des dispositions européennes à des « droits de douane », s’appuyant aussi sur la (fausse) affirmation que le cadre juridique de l’Union cible spécifiquement les entreprises états-uniennes.

Trump a ouvertement pris la défense de ces « amazing Tech Companies », menaçant d’imposer des droits de douane supplémentaires aux pays ciblant ces entreprises avec leurs législations.

En encadrant l’activité des plateformes numériques, notamment par le biais du fameux règlement général sur la protection des données (RGPD) ou du DSA, l’Europe établit-elle un régime de censure ?

Afin de permettre l’expression de toutes et tous, le droit à la liberté d’expression doit être encadré par la loi. Les contours de cette liberté sont délimités par les droits fondamentaux des tiers et comprennent notamment la protection de la vie privée, la non-discrimination, ou encore la dignité humaine. Ce sont justement ces limites que rappelle le DSA. Le texte vise à s’assurer que les contenus circulant sur les plateformes respectent ces principes cardinaux. Et si la désinformation ou les discours haineux sont des problèmes préoccupants, la critique du pouvoir reste, en Europe, protégée par la liberté d’expression, laquelle est garantie par le DSA.

La modération délaissée par les grandes plateformes

Cet encadrement déplaît fortement au régime trumpiste ainsi qu’à certaines grandes plateformes numériques américaines. Celles-ci estimaient pourtant, il y a quelques années, que des réglementations étaient nécessaires pour un système efficace de gouvernance des contenus en ligne. En suivant désormais la ligne trumpiste, les plateformes ont tendance à fausser délibérément le concept de censure en l’assimilant à celui de modération des contenus. Cette dernière vise toutefois à s’assurer que les contenus circulant sur les plateformes sont conformes aux conditions générales du service mais, aussi, aux lois et droits fondamentaux protégés par les textes fondateurs.

Mais ce n’est pas seulement d’un point de vue théorique que la modération des contenus, mise en place par le DSA, est attaquée. Cela passe aussi par les nombreuses baisses budgétaires au sein des plateformes, entraînant une réduction des ressources humaines consacrées à la sécurité en ligne. Ces mesures sont par ailleurs couplées à une « simplification » des politiques de modération des contenus, qui s’affranchissent des protections sur des sujets considérés comme « woke », notamment la protection de la communauté LGBTQIA+ ou la lutte contre la haine en ligne.

Dernière annonce en date ? Meta déclarant, un vendredi au cœur de l’été, la suspension de ses publicités ciblées à caractère politique. Sans même évoquer le moment de l’annonce, comment interpréter un tel signal ? L’initiative concerne les publicités à caractère politique, électoral ou traitant de « questions sociales ». Raison invoquée : le règlement européen relatif à la transparence et au ciblage de la publicité à caractère politique, qui rendrait le ciblage des usagers trop complexe.

Pourtant, une étude conduite par l’organisation AI Forensics, avant l’entrée en application de ce règlement, avait démontré que Meta laissait la propagande pro-russe envahir les publicités politiques ciblées, avec un système de détection des contenus complètement défaillant.

L’Union européenne, modèle d’anti-trumpisme ?

Certes, l’Europe n’est pas parfaite. Certes, l’Europe vit aussi d’importantes dérives identitaires. Mais l’Europe tente, dans un monde de plus en plus complexe, de garantir à toutes et tous la possibilité de s’exprimer en ligne.

Aujourd’hui, les victimes des attaques visant la liberté académique et la liberté de la presse ne se trouvent pas en Europe, mais aux États-Unis. Dans ces conditions, l’Europe doit porter encore plus haut et encore plus fort ses valeurs. Elle doit offrir un modèle dans lequel les libertés sont protégées par la loi et les institutions, et non par la volonté d’un homme.

![]()

Suzanne Vergnolle a reçu des financements de la région Île-de-France.

Stefania Di Stefano ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Quand la galaxie trumpiste accuse l’Europe de pratiquer la censure – https://theconversation.com/quand-la-galaxie-trumpiste-accuse-leurope-de-pratiquer-la-censure-263855