Source: The Conversation – France (in French) – By Delphine Farmer, Professor of Chemistry, Colorado State University

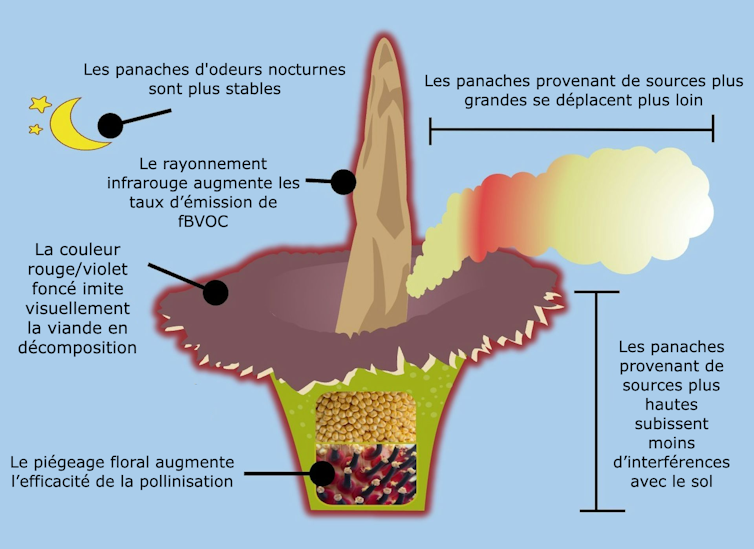

C’est l’une des plus grandes inflorescences du monde et sa floraison a tout d’un spectacle macabre. Celle-ci, qui n’a lieu qu’une fois tous les sept à dix ans, ne dure que deux nuits et libère un parfum pestilentiel digne d’une carcasse en décomposition. Derrière cette puanteur insoutenable se cache en fait une stratégie de pollinisation sophistiquée, que des chercheurs ont pu analyser en temps réel grâce à des instruments de pointe.

Parfois, faire de la recherche pue. Littéralement.

L’Arum titan (Amorphophallus titanum, également appelée « phallus de titan ») est rare, et il est plus rare encore d’en voir fleurir une. Celle-ci survient une fois tous les sept à dix ans, et leur floraison ne dure que deux nuits.

Mais ces fleurs – rouges, magnifiques et imposantes, mesurant plus de 3 mètres de haut – dégagent une odeur nauséabonde. Imaginez de la chair en décomposition ou du poisson pourri.

En anglais, on les appelle corpse plants, soit « plantes cadavres ». Et ce surnom est bien mérité : l’odeur âcre de la plante attire non seulement les insectes nécrophages – coléoptères et mouches, normalement attirés par la viande en décomposition – qui pollinisent les plantes, mais aussi des foules de curieux, intrigués par ce spectacle rare et par son odeur putride.

Les biologistes étudient ces fleurs depuis des années, mais en tant que spécialistes de la chimie de l’atmosphère, notre curiosité aussi était piquée : quels sont les mélanges chimiques qui créent cette odeur pestilentielle, et comment évoluent-ils tout du long de la courte période de floraison de cette plante ?

Des études précédentes avaient déjà identifié plusieurs dizaines de composés organiques volatils et soufrés qui contribuent à l’odeur de ces fleurs, mais personne n’avait encore quantifié précisément leurs taux d’émission ni examiné leur évolution au cours d’une même soirée. Nous avons récemment eu l’occasion de le faire. Nos conclusions suggèrent que derrière l’apparente complexité olfactive d’une fleur très inhabituelle, il s’agit en réalité d’une stratégie de pollinisation.

À la rencontre de Cosmo, spécimen Titan arum

Ces plantes sont originaires de l’île indonésienne de Sumatra et sont considérées comme menacées d’extinction, même là-bas.

Il y a plusieurs années, l’université d’État du Colorado (CSU) a reçu un exemplaire de Titan arum (Amorphophallus titanum) à des fins d’étude. Elle s’appelle Cosmo : les Titan arums sont si rares qu’on leur donne des noms.

Cosmo est resté en dormance dans les infrastructures de l’université pendant plusieurs années avant de montrer les premiers signes de floraison au printemps 2024. Lorsque nous avons appris que Cosmo allait fleurir, nous avons sauté sur l’occasion.

John Eisele/Colorado State University

Nous avons déployé plusieurs appareils permettant de collecter des échantillons d’air avant, pendant et après la floraison. Nous avons ensuite mesuré les substances chimiques présentes dans les échantillons d’air à l’aide d’un chromatographe en phase gazeuse couplé à un spectromètre de masse, un instrument souvent mentionné dans les séries policières.

Nos collègues ont également apporté un spectromètre de masse à temps de vol que nous avons placé derrière Cosmo, dans le sens du vent, afin de mesurer chaque seconde les composés organiques volatils produits.

Pour que chacune de leurs rares floraisons compte vraiment, ces plantes y consacrent beaucoup d’énergie. Elles produisant de grandes fleurs qui peuvent peser plus de 45 kilogrammes. Les plantes se réchauffent alors grâce à un processus biochimique appelé thermogenèse, qui augmente les émissions de composés organiques qui attirent les insectes.

À lire aussi :

Pourquoi toutes les fleurs ne sentent pas la rose… loin de là !

Et ce qu’Arum titan dégage est tristement célèbre. Alors que certaines communautés locales vénéraient ces plantes, d’autres tentaient de les détruire. Au XIXe siècle, les explorateurs européens les ont activement collectées et les ont distribuées dans les jardins botaniques et les conservatoires du monde entier.

Il s’agit de plantes dichogames : chacune possède à la fois des fleurs mâles et femelles. À l’intérieur de la feuille géante en forme de pétale, appelée spathe, chaque plante possède un épi central appelé spadice, entouré de nombreuses rangées de petites fleurs femelles et mâles près de sa base. Ces fleurs femelles et mâles fleurissent à des moments différents pour éviter l’autopollinisation.

John Eisele/Colorado State University

La première nuit de floraison d’Arum titan, les fleurs femelles s’ouvrent pour attirer les pollinisateurs qui, si la plante a de la chance, y transporteront le pollen d’un autre Arum titan. Puis, la deuxième nuit, les fleurs mâles s’ouvrent à leur tour, permettant aux insectes pollinisateurs de transporter le pollen vers une autre plante.

La rareté de leur floraison et leur résistance à l’autopollinisation expliquent non seulement pourquoi ces plantes sont classées comme espèces menacées, mais aussi pourquoi elles ont besoin de stratégies de pollinisation efficaces. C’est exactement le domaine de la chimie que nous voulions étudier.

À lire aussi :

Pourquoi certaines odeurs sont perçues comme nauséabondes ?

Les fleurs femelles travaillent plus dur

Nous avons découvert que les fleurs femelles accomplissent la majeure partie du travail en attirant les pollinisateurs, ce que des études précédentes avaient déjà souligné. Elles émettent de grandes quantités de composés organosulfurés, ainsi que d’autres composés qui imitent des odeurs de pourriture afin d’attirer les coléoptères et les mouches qui se nourrissent normalement de carcasses d’animaux.

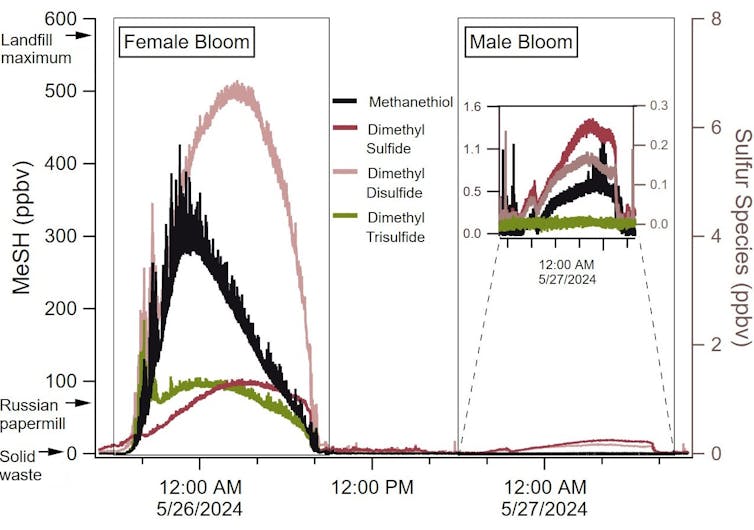

Ce sont ces composés organosulfurés qui dégagent une odeur vraiment nauséabonde lors de la floraison des plantes femelles. En particulier le méthanethiol, une molécule appartenant à la même famille chimique que les composés odorants émis par les mouffettes, était le composé le plus émis pendant la floraison de Cosmo.

Mj Riches and Rose Rossell/Colorado State University

Nous avons également mesuré de nombreux autres composés organosulfurés, notamment le diméthyldisulfure, qui dégage une odeur d’ail, le sulfure de diméthyle, connu pour son odeur désagréable, et le trisulfure de diméthyle, qui sent le chou ou l’oignon pourri. Nous avons également mesuré des dizaines d’autres composés : l’alcool benzylique à l’odeur douce et aromatique, le phénol à l’odeur d’asphalte et le benzaldéhyde.

Alors que des études précédentes avaient révélé la présence des mêmes composés avec des instruments différents, nous avons pu suivre en particulier le méthanethiol et quantifier l’évolution des concentrations pour suivre l’évolution de la floraison pendant la nuit.

Au fur et à mesure que Cosmo se développait, nous avons combiné les données de nos instruments avec les mesures du taux de renouvellement de l’air dans la serre, c’est-à-dire la vitesse à laquelle l’air circule, et avons ainsi pu calculer les taux d’émission.

Les émissions de composés volatils représentaient environ 0,4 % de la biomasse moyenne de la plante, ce qui signifie que celle-ci, dont nous avons estimé le poids à environ 45 kg, a perdu une fraction de masse mesurable lors de la production de ces substances chimiques. On comprend alors pourquoi son odeur est si forte.

Piégeage floral

Les fleurs femelles ont fleuri toute la nuit, mais tôt le lendemain matin, les émissions ont rapidement cessé. Nous nous sommes demandé si ce point de rupture pouvait être la preuve de piégeage floral, une stratégie de pollinisation employée par d’autres membres de la famille du Titan arum.

Cyrille Claudel, The Plant Journal, 2023, CC BY-NC-ND

Pendant le piégeage floral, la chambre florale peut se fermer physiquement grâce au mouvement des poils de la plante ou à l’expansion de certaines de ses parties, telles que la spathe qui l’entoure. Une fermeture physique de la chambre florale ne serait pas facilement visible pour les observateurs, mais elle pourrait rapidement interrompre les émissions, comme nous l’avons observé.

Un arum australien qui sent le fumier utilise cette technique. Les insectes nécrophages qui viennent butiner les fleurs femelles sont contraints de rester pour les fleurs mâles qui s’ouvrent la nuit suivante, afin de pouvoir transporter leur pollen vers une autre fleur femelle en décomposition. Nos recherches suggèrent que la fleur cadavre agit probablement de la même façon.

La deuxième nuit, les émissions de composés volatils ont repris, mais à des niveaux beaucoup plus faibles. Les fleurs mâles émettent un ensemble de composés aromatiques plus sucrés et beaucoup moins soufrés que les fleurs femelles.

Rose Rossell/Colorado State University

Nous émettons l’hypothèse que les fleurs mâles n’ont pas besoin de déployer autant d’efforts pour dégager une odeur forte afin d’attirer autant d’insectes, car ceux-ci sont déjà présents grâce au piégeage floral consécutif à la floraison des fleurs femelles. Une étude réalisée en 2023 a révélé que la thermogenèse était également plus faible pendant la floraison mâle : le spadice atteignait 36 °C pendant la floraison femelle, mais seulement 33,2 °C pendant la floraison mâle.

Plus nauséabondes qu’une décharge

Notre étude montre que les puissantes émissions olfactives d’Arum titan peuvent être supérieures à celles des décharges d’un ordre de grandeur, mais seulement pendant deux nuits. Ces fortes émissions sont conçues pour se propager loin dans la jungle de Sumatra afin d’attirer les mouches charognardes.

Les odeurs résistent également à l’oxydation atmosphérique, c’est-à-dire à la dégradation des composés organiques dans l’atmosphère par réaction avec des oxydants présents dans la pollution, tels que l’ozone ou les radicaux nitrates. Les différents composés se dégradent à des vitesses différentes, ce qui constitue un facteur important pour attirer les pollinisateurs.

De nombreux insectes sont attirés non seulement par un seul composé volatil, mais aussi par des proportions spécifiques de différents composés volatils. Lorsque la pollution atmosphérique dégrade les émissions florales et que ces proportions changent, les pollinisateurs ont plus de mal à trouver des fleurs.

Le panache olfactif de la fleur femelle a maintenu un rapport à peu près constant entre les principaux composés chimiques soufrés. Le panache mâle, en revanche, était beaucoup plus sensible à la dégradation due à la pollution et à la modification des concentrations des composés chimiques dans l’air nocturne.

Ces plantes énigmatiques consacrent beaucoup d’énergie à des stratégies de pollinisation ingénieuses. Cosmo nous a appris que leur odeur de viande en décomposition se propageait loin, qu’elles utilisaient la thermogenèse pour augmenter leurs émissions et piéger les fleurs, nous offrant ainsi un nouvel éclairage sur la floraison spectaculaire d’Arum titan.

![]()

Delphine Farmer a reçu des financements de la Fondation Alfred P. Sloan, de la Fondation nationale pour la science, de l’Agence américaine d’observation océanique et atmosphérique, du Département de l’énergie et de la Fondation W.M. Keck.

Mj Riches a reçu des financements de la National Science Foundation américaine.

Rose Rossell ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Pourquoi les fleurs du « phallus de titan » ont-elles une odeur si nauséabonde ? – https://theconversation.com/pourquoi-les-fleurs-du-phallus-de-titan-ont-elles-une-odeur-si-nauseabonde-265779