Source: The Conversation – in French – By Gilles Paché, Professeur des Universités en Sciences de Gestion, Aix-Marseille Université (AMU)

Les sanctions occidentales poussent la Russie à emprunter des routes alternatives et à exploiter un « marché gris » pour ses approvisionnements. Une nouvelle géographie des échanges se dessine-t-elle ? Est-elle durablement viable ?

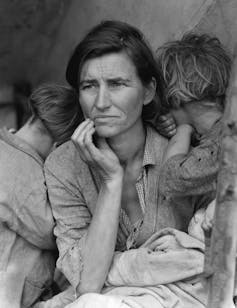

Fin septembre 2025, le pétrolier Pushpa (ou Boraçay), battant pavillon béninois, a été arraisonné par des militaires français, puis immobilisé par la justice, au large de Saint-Nazaire (Loire-Atlantique). Parti le 20 septembre du port de Primorsk, en Russie, chargé de 750 000 barils de brut russe, il était attendu à Vadinar, en Inde, trois semaines plus tard. Il apparaît, selon toute vraisemblance, que ce pétrolier fait partie de la « flotte fantôme » utilisée par la Russie pour continuer à commercer avec de nombreux pays en contournant les sanctions auxquelles le pays fait face. Un véritable « jeu du chat et de la souris » dont l’arraisonnement du Pushpa n’est que la partie émergée d’un immense iceberg, avec une totale redistribution des cartes en cours.

En effet, depuis le début de la guerre en Ukraine, le 22 février 2022, les sanctions occidentales contre la Russie bouleversent les routes commerciales traditionnelles, mais aussi les moyens utilisés en vue de les alimenter en biens. Pour Vladimir Poutine, disposer de corridors de transport alternatifs (et d’une « flotte fantôme » efficace) revêt désormais une importance stratégique. Afin de maintenir ses flux d’importation et d’exportation, la Russie explore des voies maritimes et terrestres inédites. Les transformations logistiques à l’œuvre s’inscrivent dans un contexte où les crises géopolitiques et le changement climatique convergent, rendant certaines routes plus accessibles, autant pour la route arctique que pour les corridors eurasiens.

Au-delà des infrastructures visibles, la résilience dont fait preuve la Russie repose sur la mise en œuvre de stratégies informelles et de réseaux parallèles d’approvisionnement, notamment pour les produits énergétiques et industriels. Cette « logistique de l’ombre » illustre la façon dont le pays s’adapte à un environnement international fortement contraint. Si l’impact de la guerre en Ukraine sur l’économie mondiale et les flux transnationaux est encore difficile à mesurer, nul doute qu’une nouvelle géographie émerge.

Force est d’admettre que Vladimir Poutine est en train de gagner la bataille du « contournement logistique » des sanctions, et le monde multipolaire qui va en découler devrait être fort différent de celui des années 2010.

Rupture des routes traditionnelles

Depuis le début de la guerre entre la Russie et l’Ukraine en février 2022, les sanctions occidentales se sont multipliées, affectant plus ou moins fortement les infrastructures logistiques reliant la Russie à ses partenaires commerciaux. En juillet 2025, l’Union européenne a adopté son 18ᵉ paquet de sanctions, visant notamment les réseaux de transport de contournement et les institutions financières facilitant les échanges avec la Russie.

Depuis trois ans, ces mesures ont conduit les armateurs Maersk, MSC et CMA CGM à suspendre leurs rotations vers les ports russes – un retrait qui a plongé de nombreuses entreprises occidentales, des importateurs de composants électroniques aux exportateurs agricoles, dans une grande incertitude. Les flux de matières premières ont été particulièrement perturbés. Le pétrole, le gaz et le charbon, autrefois acheminés via des oléoducs ou les ports baltiques, connaissent désormais des redirections coûteuses.

À lire aussi :

Comment les ports de la mer Baltique s’adaptent à la nouvelle donne géopolitique

Ajoutons que les assureurs maritimes occidentaux refusent souvent de couvrir les routes incluant la Russie, même si le club d’assurances « P&I » (Protection & Indemnity), avec American Club, West of England et Gard, l’accepte encore pour le pétrole, des refus qui aggravent les délais et les frais d’assurance pour les entreprises occidentales qui continuent malgré tout à commercer avec le pays, alors qu’elles n’ignorent en rien les risques pris. Dans un monde où pleuvent les embargos, comme en témoigne le cas de la Corée du Nord, la logistique se présente comme un levier stratégique où chaque route bloquée devient un point de tension/pression de nature géopolitique. Une recomposition géographique des flux est en marche, et la Russie en constitue un excellent exemple.

Recomposition géographique des flux

Confrontée aux blocages occidentaux, la Russie s’est tournée vers l’Asie et le Moyen-Orient, des conteneurs arrivant sur son sol depuis la Chine via le Kazakhstan et la mer Caspienne. Ce corridor discret est utilisé pour des biens essentiels comme les composants électroniques. La Turquie joue également un rôle clé par le biais d’entreprises comme Enütek Makina, qui servent d’intermédiaires logistiques pour acheminer par voie maritime (via les ports de Mersin et Izmir) et par voie terrestre (via la Géorgie) des équipements industriels liés au secteur de la défense vers la Russie.

Ceci est d’autant plus vrai que la Route maritime du Nord, qui longe l’Arctique russe depuis la mer de Kara (au nord de la Sibérie occidentale) jusqu’au détroit de Béring (frontière maritime avec l’Alaska), permet à la Russie de relier ses ports arctiques et extrême-orientaux (notamment Mourmansk, Arkhangelsk et Vladivostok) sans dépendre des détroits contrôlés par d’autres puissances. Il est clair qu’il s’agit là d’une alternative stratégique de première importance aux voies plus classiques comme le canal de Suez.

En 2024, le volume de fret transporté le long de cette route par Novatek (exportateur de gaz naturel liquéfié) et Sovcomflot (armateur d’État russe, opérant à l’aide de tankers et méthaniers) vers l’Asie orientale, tout particulièrement la Chine, a atteint un record de près de 38 millions de tonnes, avec 92 voyages autorisés, soit une hausse notable par rapport aux années précédentes. Les infrastructures arctiques, comme les brise-glaces nucléaires, sont renforcées pour accompagner la montée en puissance du trafic sur la Route maritime du Nord, principalement portée par les exportations d’hydrocarbures russes. Ils s’inscrivent dans une logique de souveraineté logistique de la Russie face à un environnement international de plus en plus hostile.

Logistique de l’ombre

La capacité de résistance de la Russie est renforcée par l’existence d’un « marché gris », un phénomène économique connu où des biens légaux sont échangés en dehors des canaux de distribution autorisés. La théorie économique enseigne que ces marchés émergent lorsque des industriels proposent leurs produits à des prix différents selon les marchés, incitant d’autres entreprises à acheter ces produits là où le prix est plus bas pour les revendre discrètement sur des marchés où les clients sont prêts à payer le « prix fort ».

À lire aussi :

La guerre en Ukraine transforme la carte des routes commerciales Chine-Europe

Ce type de commerce parallèle, qui n’a d’ailleurs pas attendu la guerre en Ukraine pour exister, est devenu essentiel afin de maintenir opérationnel l’appareil industriel et militaire russe. Là encore, une logistique de l’ombre joue un rôle clé, notamment avec la fameuse « flotte fantôme », des navires pétroliers hors d’âge et aux propriétaires opaques… dont le Pushpa n’est qu’une pièce modeste de l’échiquier. Le Royaume-Uni a sanctionné 135 de ces tankers en juillet 2025, soulignant leur rôle critique dans le transport illégal de pétrole russe malgré l’embargo. L’Union européenne en a ajouté près de 200 autres à sa liste noire, qui totalise désormais environ 350 navires ciblés. Il n’empêche que la logistique de l’ombre persiste et signe, et si elle n’était pas mise en œuvre, il est fort probable que la Russie ne puisse plus bénéficier de ses cruciales recettes énergétiques.

Comme le soulignent plusieurs ONG, dont Greenpeace et Transport & Environment (T&E), les implications écologiques de l’existence de la flotte fantôme sont préoccupantes. Les navires sont très peu entretenus et responsables d’accidents fréquents. Un cas particulièrement parlant est l’accident impliquant le pétrolier Volgoneft-212 dans le détroit de Kertch, en décembre 2024. Âgé de plus de 50 ans, le navire, qui transportait des produits pétroliers, s’est brisé en deux en pleine tempête, provoquant un déversement massif de fioul dans la mer. En cas d’échouage, les dégâts peuvent également nuire à l’environnement au sens large, comme l’a montré, encore en décembre 2024, la sectionnement de cinq câbles sous marins par un navire de la flotte fantôme en mer Baltique, qui a conduit la Finlande à porter plainte contre le capitaine pour « vandalisme aggravé ».

Une autonomie coûteuse

Au-delà de la résilience, Vladimir Poutine tente sans aucun doute de bâtir une nouvelle souveraineté logistique, fondée sur un investissement massif dans les infrastructures arctiques et le renforcement des liens avec l’Asie centrale et le Moyen-Orient. Une telle diversification relève autant d’une stratégie géopolitique que d’une réponse tactique aux sanctions occidentales, faisant de la logistique un terrain finalement méconnu de reconfiguration du pouvoir.

Il n’empêche que l’autonomie est coûteuse et partielle, car les détours augmentent les coûts, ralentissent les livraisons et fragilisent la fiabilité des approvisionnements. Par exemple, les tarifs de fret pour le transport de pétrole russe depuis le port de Kozmino en Extrême-Orient ont été multipliés par cinq en raison de la pénurie de navires, après que de nouvelles sanctions américaines ont réduit la disponibilité des tankers. En outre, si le marché gris est plus flexible, y recourir expose la Russie à des intermédiaires parfois opportunistes, qui en profitent pour pratiquer des marges excessives.

Nouvelles tensions géopolitiques locales

La stratégie conduite par la Russie depuis trois ans s’inscrit dans une volonté de réduire la dépendance du pays aux routes commerciales traditionnelles, souvent contrôlées par des puissances occidentales. En développant des corridors alternatifs, Vladimir Poutine cherche à sécuriser ses approvisionnements, sachant que les défis sont nombreux, à la fois en matière d’entretien des infrastructures dans des régions reculées et de maîtrise de chaînes logistiques complexes. De plus, la dépendance accrue à des partenaires régionaux entraîne des tensions géopolitiques locales et, par conséquent, une réelle vulnérabilité pour la Russie.

Contrairement à ce que d’aucuns ont cru ou espéré, la guerre en Ukraine n’a pas isolé économiquement et politiquement la Russie. En revanche, elle est en train de transformer en profondeur ses modes d’échange et la logistique qui les soutient. Des chemins de fer les plus discrets aux nouvelles routes océaniques, une nouvelle géographie des flux se dessine, partagée entre légalité et opacité, contrainte et adaptation. L’histoire qui se déroule sous nos yeux rappelle, si besoin était, que dans les crises modernes, quelle que soit leur nature, la logistique est tout à la fois un révélateur, une arme et un lien vital qui sait faire preuve d’une remarquable plasticité.

![]()

Gilles Paché ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Russie : la logistique de l’ombre contre les sanctions occidentales – https://theconversation.com/russie-la-logistique-de-lombre-contre-les-sanctions-occidentales-265044