Source: The Conversation – (in Spanish) – By Javier Llorente Merino, Investigador en Física de Partículas, Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas (CIEMAT)

La interacción fuerte es la responsable de la estabilidad de la materia. O sea, de que nosotros mismos, con todo lo que nos rodea, no nos desintegremos. Hablamos de la más intensa de las cuatro interacciones fundamentales de la naturaleza. A distancias muy pequeñas, es aproximadamente 100 veces más intensa que la fuerza electromagnética, unas 106 veces mayor que la fuerza débil y 1038 veces más fuerte que la gravedad que nos sujeta a la Tierra y construye el universo tal y como lo conocemos.

La interacción fuerte se conoce bastante bien, pero no con total exactitud. Para investigarla, los físicos nucleares han llevado a cabo cientos de experimentos a lo largo de los años. Y las últimas medidas tomadas en el Gran Colisionador de Hadrones (LHC) del CERN, han cuantificado con gran precisión la intensidad de la interacción fuerte a energías cada vez más altas. Del orden de 7 teraelectronvoltios, y subiendo.

La distancia importa

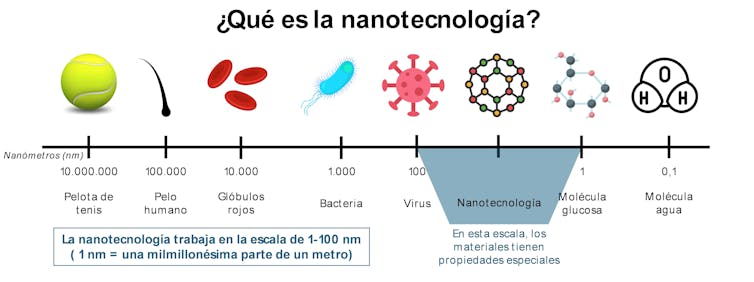

Su acción sobre las partículas elementales que componen el núcleo atómico, quarks y gluones, depende en gran medida de la distancia entre esas partículas: su intensidad aumenta a medida que se separan en el espacio y se desvanece en las distancias cortas. La explicación de esta propiedad, conocida como “libertad asintótica”, valió un premio Nobel en 2004.

La interacción fuerte es tan intensa que las distancias necesarias para que deje de operar resultan realmente inalcanzables. Nunca llega a ser cero, de ahí el término libertad asintótica (una curva que se aproxima indefinidamente a una recta o a otra curva, sin llegar a encontrarse con ella). Y justamente por ser “asintótica”, aún hoy se sigue explorando a distancias cada vez más cortas.

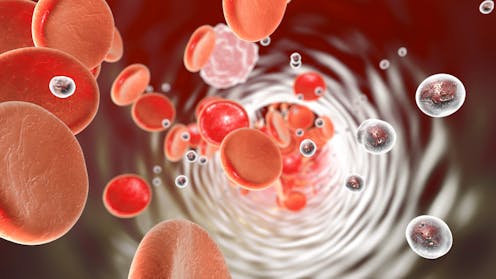

La otra cara de la misma moneda es el efecto de “confinamiento”. Cuando dos quarks se separan lo suficiente entre sí, la energía aumenta lo suficiente como para crear nuevos quarks que, inmediatamente, se asocian a los primeros. Esto conlleva que estas partículas no se puedan observar de forma aislada sino “confinadas” en grupos de dos o más quarks llamados hadrones.

Como la cuerda de una guitarra

Así como una cuerda de guitarra más corta produce notas más agudas (mayores frecuencias), explorar distancias más pequeñas entre partículas requiere energías mayores, ya que la resolución espacial en física cuántica está limitada por el principio de incertidumbre. Es por esto que, para estudiar las interacciones a muy corta distancia, necesitamos colisionadores de muy alta energía. El más potente jamás construido, el Gran Colisionador de Hadrones (LHC) de Ginebra, sigue recogiendo datos cada vez más precisos sobre el comportamiento de las interacciones fundamentales. Y resulta que, toda vez que se comparan con la teoría, se ajustan a ella con sorprendente exactitud.

Los chorros de hadrones

Las medidas experimentales de los procesos que tienen lugar en el LHC consisten, a menudo, en determinar la probabilidad de que ocurran en función de ciertas variables.

Ejemplos de estas variables serían la energía o el momento de las partículas que podemos observar en nuestros experimentos. Sin embargo, ya hemos visto cómo los quarks (y gluones) están afectados por la propiedad del “confinamiento”.

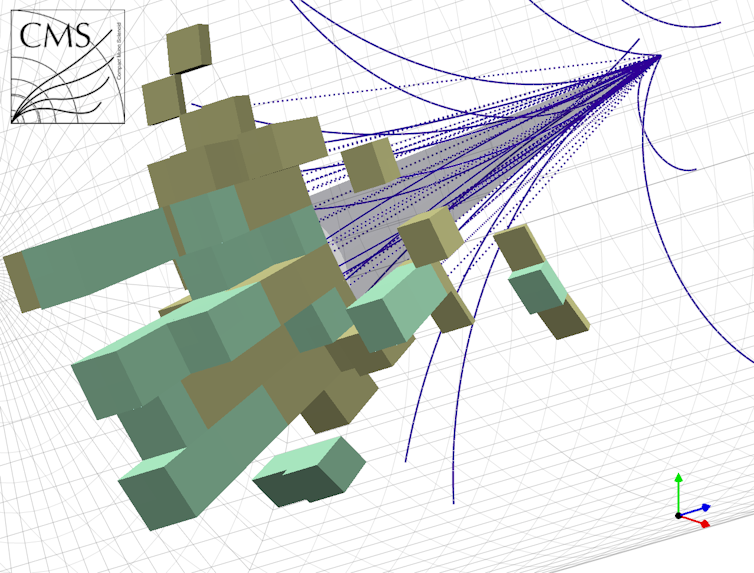

Esto implica que cuando una de estas partículas se crea tras una colisión en el LHC, lo que se observa no es una partícula aislada, sino un chorro que arrastra decenas de partículas distintas que han perdido la capacidad de interactuar fuertemente entre ellas.

El estudio de las propiedades de estos chorros de hadrones (llamados jets en inglés) proporciona una de las maneras más directas de estudiar la interacción fuerte.

Quantumdiaries, CC BY

El parámetro más fundamental de la física de partículas

La cromodinámica cuántica, QCD por sus siglas en inglés, es la teoría que describe la interacción fuerte. Contiene un parámetro, la constante de acoplamiento αs, que cuantifica cómo de intensa es esta interacción. Es decir, define la probabilidad de que dadas dos partículas a cierta distancia, interaccionen fuertemente dando lugar a otras.

Las sucesivas potencias de este parámetro, posiblemente el más fundamental de la física de partículas, permiten describir matemáticamente la teoría con diferentes grados de aproximación. Cada uno de estos grados, llamados “órdenes perturbativos”, va apilándose sobre los anteriores como bloques de piedra en una catedral, permitiéndonos acercarnos de forma cada vez más precisa a la verdad: las distribuciones de probabilidad que podemos medir experimentalmente.

Dos resultados clave en 20 años de trabajo

Basándose en medidas del ángulo entre las direcciones de producción de chorros hadrónicos, la colaboración o experimento ATLAS del LHC publicó en 2023 una de las medidas más precisas hasta la fecha de la constante de acoplamiento αs. Esta constante se determinó en el rango de energía de varios teraelectronvoltios. Esto equivale a escalas de distancia miles de veces más pequeñas que el radio de un protón, entre 0,87 y 0,88 femtómetros (1 femtómetro son 10-15 m), mientras que los nuevos resultados lo reducen a 0,84 femtómetros.

Una de las claves de la enorme precisión obtenida fue el uso de predicciones teóricas a tercer orden en cronodinámica cuántica. Para que estos desarrollos se materializaran, fueron necesarios veinte años de intenso trabajo teórico desde la publicación previa del cálculo a segundo orden. Además, hicieron falta decenas de millones de horas de cálculo paralelo por computador para obtener la predicción. Tal es la envergadura de la tarea.

Algo más recientemente, a finales de 2024, un grupo de físicos de cinco países ha publicado el estudio de la intensidad de la interacción fuerte con mayor alcance hasta la fecha. En este estudio se ha determinado la constante de acoplamiento a escalas de energía un 70 % más altas que las obtenidas previamente en la colaboración ATLAS, gracias a la combinación de distintas medidas experimentales.

Estas medidas, que combinan resultados a tres energías de colisión protón-protón en dos experimentos distintos, cuantifican la probabilidad de producir dos chorros hadrónicos en diferentes condiciones. La comparación de estos datos con la mejor aproximación teórica de la que se dispone, a tercer orden, permite determinar la intensidad de la fuerza fuerte a distancias tan pequeñas que no habían sido accesibles hasta ahora.

Medir la interacción fuerte para buscar nueva Física

Comprender con precisión la interacción fuerte es una de las claves de la física de partículas a día de hoy y cada vez somos capaces de alcanzar resultados más precisos en condiciones más extremas.

De momento la teoría se sigue ajustando con enorme precisión a los datos experimentales, pero al adentrarnos en territorio inexplorado podría dejar de ser así. Si, eventualmente, se encontrasen desviaciones suficientemente grandes entre la teoría y los datos podríamos estar ante el descubrimiento de nuevas partículas desconocidas. Estas nuevas partículas hipotéticas, necesariamente muy pesadas, se acoplarían a los quarks y gluones ya conocidos a través de la interacción fuerte, provocando tales desviaciones.

Sólo realizando experimentos más precisos a energías más altas se podrá seguir arrojando luz sobre estas cuestiones. Entre tanto, no vamos a desintegrarnos, ni nosotros ni el universo.

![]()

Javier Llorente Merino recibe fondos del programa de Atracción de Talento de la Comunidad de Madrid.

– ref. ¿Cómo de fuerte es la interacción fuerte que evita que nos desintegremos? – https://theconversation.com/como-de-fuerte-es-la-interaccion-fuerte-que-evita-que-nos-desintegremos-259473