Source: The Conversation – (in Spanish) – By Paula Lamo, Profesora e investigadora, Universidad de Cantabria

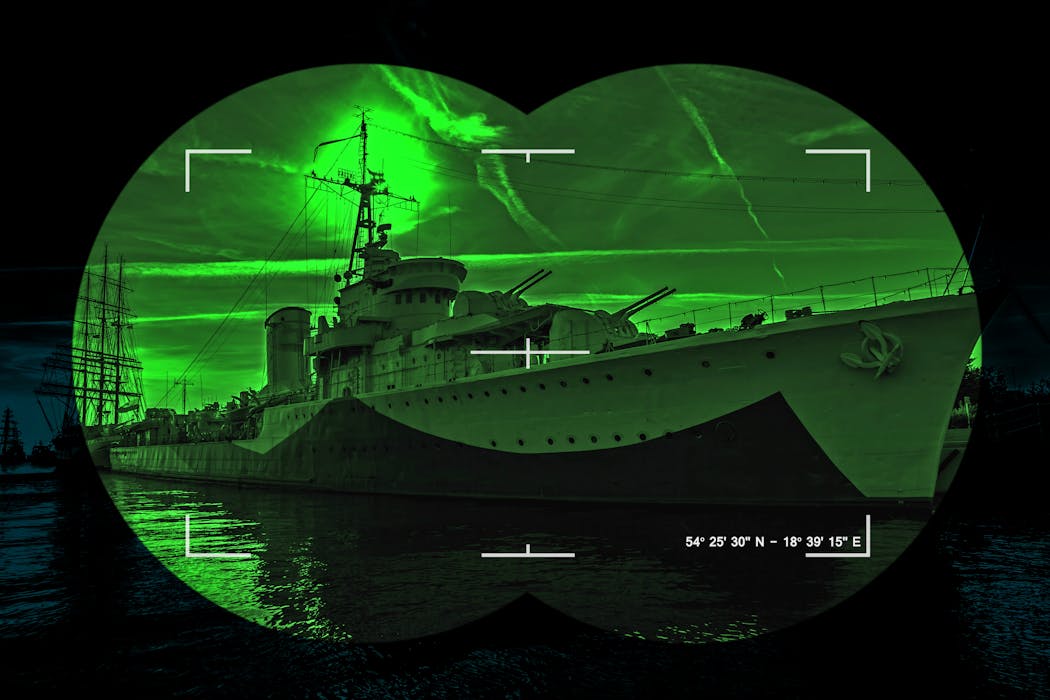

A simple vista podría parecer un petrolero más. Tenía el casco oxidado, bandera extranjera y una ruta aparentemente comercial. Nada que llamara la atención en un océano por el que navegan decenas de miles de buques cada día. Sin embargo, el 7 de enero de 2026 Estados Unidos interceptó y detuvo el petrolero Marinera (antes conocido como Bella 1) en aguas del Atlántico Norte durante la operación “Lanza del Sur”, que culminó tras varias semanas de seguimiento.

No fue una inspección rutinaria ni un problema administrativo. Estados Unidos lo abordó porque las autoridades lo consideran parte de una red de transporte que evade sanciones internacionales y opera fuera de los controles habituales del comercio marítimo.

Flotas en la sombra

Se trataba de un barco encuadrado en lo que expertos llaman “barcos fantasma” o “flotas en la sombra”. Esto es, petroleros que, aunque figuran en registros oficiales, cambian de nombre, de bandera y de propietario con frecuencia para ocultar su actividad real y sortear sanciones económicas.

Este tipo de buques aparece y desaparece de los sistemas de seguimiento, realiza transferencias de carga en alta mar y suele estar asociado al transporte de crudo procedente de países sometidos a embargos, como Venezuela e Irán.

Estamos viviendo días de gran intensidad informativa. Así que la noticia de la detención ha acaparado titulares, aunque casi siempre presentada como un episodio aislado del pulso geopolítico entre Estados Unidos y los países sancionados. Y esto puede resultar engañoso.

Una flota paralela al margen de la ley

El problema no es este petrolero concreto, sino la normalización de una flota paralela que opera desde hace años al margen de las reglas del comercio global y que solo aflora cuando uno de estos buques es interceptado, se hunde o provoca un incidente. Los barcos fantasma no son una excepción ni una anomalía: son el síntoma de un sistema marítimo que tolera la opacidad como parte de su funcionamiento.

El término suena a película de aventuras fantástica. Pero la realidad, como en casi siempre en estas comparaciones cinematográficas, es mucho más prosaica y peligrosa. Estos buques existen porque el sistema marítimo internacional lo permite. Las banderas de conveniencia, pensadas en origen para facilitar el comercio, se han convertido en una herramienta perfecta para diluir responsabilidades.

Registrar un barco en determinados países implica menos controles, menos preguntas y una enorme dificultad para saber quién está realmente detrás. Cuando a eso se le suma un entramado de empresas pantalla y aseguradoras opacas, el resultado es un buque que navega legalmente, pero fuera del radar político.

Las vías alternativas del petróleo

En los últimos años, este tipo de flota ha crecido de forma silenciosa al calor de las sanciones internacionales. Así, por ejemplo, cuando se bloquean las exportaciones de petróleo de un país, el crudo no desaparece. Busca caminos alternativos. Y esos caminos, cada vez más, pasan por petroleros que no figuran en las rutas habituales, que realizan transferencias de carga en alta mar y que aparecen y desaparecen de los sistemas de seguimiento como si el océano se los tragara.

La operación estadounidense de estos días apunta precisamente a eso. No es un gesto aislado ni improvisado: eEs un aviso. Un mensaje de que Washington está dispuesto a perseguir esas rutas invisibles y a tratar el mar como un espacio donde también se hacen cumplir las sanciones. También significa que el océano ya no es un territorio neutro. Es un escenario más de la confrontación económica y geopolítica global.

¿Esto es algo nuevo? Ni mucho menos. En los últimos años hemos visto casos que, en su momento, parecieron episodios confusos y hoy encajan mejor en este patrón que se describe. Uno de los más llamativos por su relevancia internacional ocurrió en pleno conflicto en Siria. En los meses finales del régimen de Bashar al-Assad, cuando el control del territorio se desmoronaba y la atención internacional estaba puesta en el frente terrestre, un buque se hundió en el Mediterráneo en circunstancias nunca del todo aclaradas. Diversas informaciones periodísticas apuntaban a que estaba siendo utilizado para sacar material militar del país, aprovechando el caos del momento.

Y no es un caso aislado o que ocurre únicamente al calor de los conflictos militares: también se reportan en toda la UE. Nunca hay una confirmación oficial concluyente. No son barcos de guerra, no van escoltados por fragatas ni figuraban en comunicados oficiales. Son, en apariencia, un buque comercial más. Y, sin embargo, sus hundimientos o interceptaciones revelan hasta qué punto los barcos civiles pueden convertirse en piezas clave de operaciones estratégicas cuando los Estados necesitan moverse rápido y sin dejar rastro.

Sistemas que emiten señales incompletas

Esa falta de confirmación oficial tiene también una explicación técnica concreta. El control del tráfico marítimo se apoya en sistemas como el AIS, un transpondedor que emite de forma continua la identidad, posición y rumbo de los buques. En condiciones normales es una herramienta básica de seguridad, pero en estos casos se convierte en una vía de ocultación. El sistema puede apagarse durante tramos sensibles o emitir señales incompletas, haciendo que el barco “desaparezca” de los mapas de seguimiento.

A ello se suma el uso de transferencias de carga barco a barco en alta mar (operaciones conocidas como ship-to-ship) que permiten mezclar o redistribuir mercancías lejos de puertos y autoridades. Combinadas con cambios frecuentes de nombre, bandera y propietario legal, estas técnicas hacen que un buque siga siendo visible en los registros formales, pero que su carga sea prácticamente imposible de rastrear con certeza.

Ahí es, precisamente, donde los barcos fantasma dejan de ser una curiosidad técnica para convertirse en un problema político de primer orden. Facilitan la evasión de sanciones e introducen un nivel de opacidad que desestabiliza el sistema internacional.

Cuando no se sabe quién transporta qué, ni bajo qué autoridad real navega un buque, la rendición de cuentas desaparece, y con ella la capacidad de prevenir accidentes, conflictos o desastres ambientales, denunciados por numerosas organizaciones como The Ocean Foundation.

Distorsión de precios y competencia desleal

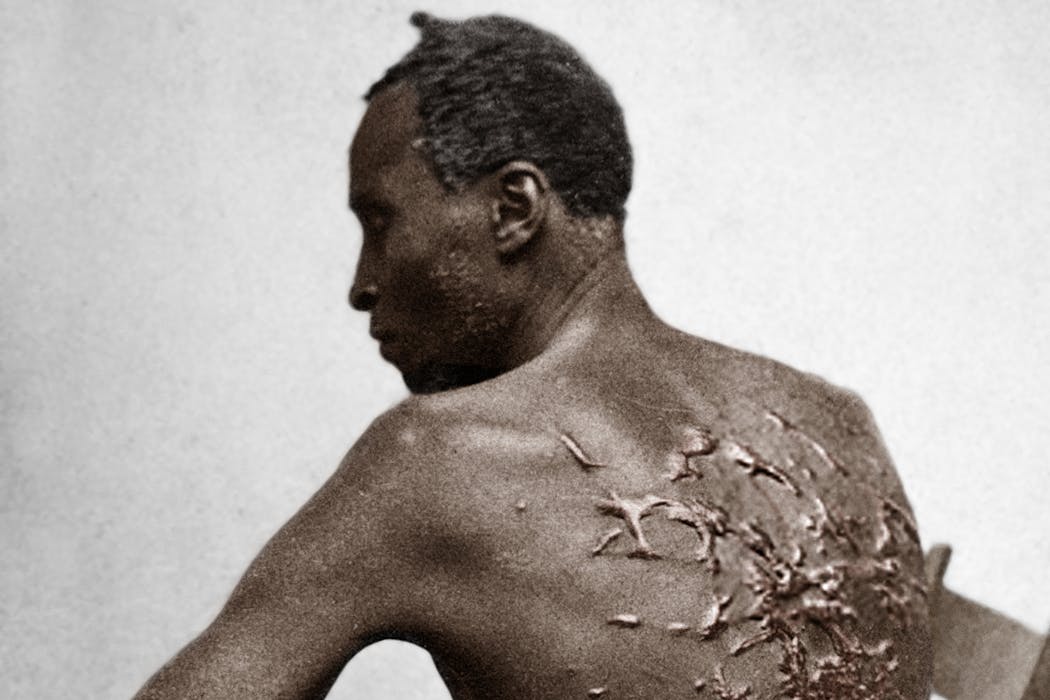

Obviamente, estos barcos no operan en el vacío. Afectan al mercado energético, distorsionan precios y generan competencia desleal frente a operadores que sí cumplen las normas. También ponen en riesgo a las tripulaciones, que trabajan en condiciones precarias y, en caso de incidente, quedan abandonadas a su suerte en un limbo jurídico.

Y su existencia mina la credibilidad de las sanciones internacionales, que pierden eficacia cuando siempre hay una ruta alternativa dispuesta a sortearlas.

Por eso la detención de un petrolero no es una anécdota. Es una fotografía de algo mucho más grande. De una economía sumergida que navega sobre el agua aprovechando vacíos legales y la dificultad de vigilar millones de kilómetros cuadrados de océano. De una guerra silenciosa que no se libra con misiles, sino con contratos opacos, registros lejanos y transpondedores apagados.

![]()

Este trabajo ha sido financiado parcialmente con por el Vicerrectorado de Investigación de la Universidad Internacional de La Rioja a través del proyecto “Nuevos Horizontes en Internet de las Cosas y NewSpace (NewIoT)” (Referencia: PP-2024-13),

– ref. Guerra silenciosa en alta mar: ¿cómo operan los barcos fantasma? – https://theconversation.com/guerra-silenciosa-en-alta-mar-como-operan-los-barcos-fantasma-273145