Source: The Conversation – in French – By Laurent Bopp, Directeur de recherche, Centre national de la recherche scientifique (CNRS); École normale supérieure (ENS) – PSL; Académie des sciences

La « géo-ingénierie climatique » recouvre un ensemble de techniques qui visent à manipuler le climat à grande échelle afin d’éviter les risques du changement climatique. Ces techniques sont très variées, depuis les parasols spatiaux pour limiter l’arrivée des rayons du soleil dans l’atmosphère jusqu’à la fertilisation des océans pour que le phytoplancton consomme davantage de CO₂, en passant par la restauration et la conservation de zones humides où le carbone est stocké de façon préférentielle.

En octobre 2025, l’Académie des sciences a publié un rapport qui détaille ce que l’on sait et ce que l’on ignore encore sur les éventuels bénéfices de ces techniques et sur les nouveaux risques qu’elles font surgir.

Elsa Couderc, cheffe de rubrique Sciences et Technologies, explore ici avec Laurent Bopp, climatologue et académicien, les nouveaux risques climatiques que ces techniques pourraient faire émerger. Le second volet de ces « regards croisés » est un entretien avec Manuel Bellanger, qui étudie à l’Ifremer le développement des techniques de géo-ingénierie marine avec un regard d’économiste.

The Conversation : Pourquoi l’Académie des sciences s’empare-t-elle aujourd’hui du sujet de la géo-ingénierie climatique, alors qu’on en parle relativement peu en France ?

Laurent Bopp : Le sujet est de plus en plus présent dans la littérature scientifique, dans le débat scientifique et dans le débat politique qui entoure les discussions sur le changement climatique. On ne s’en rend pas bien compte en France, mais aux États-Unis, en Angleterre, en Allemagne, au Canada, le débat est beaucoup plus présent.

Certains climatologues, y compris de renom, se prononcent pour faire beaucoup plus de recherches sur ces technologies, mais aussi parfois pour envisager leur déploiement à grande échelle afin d’éviter un réchauffement trop important. L’argument est simple : un niveau de réchauffement trop élevé génère des risques importants et pourrait conduire au dépassement de certains points de bascule potentiels dans le système climatique, par exemple une fonte irréversible des calottes glaciaires du Groenland et de l’Antarctique, ce qui pourrait entraîner une élévation du niveau de la mer de plusieurs mètres additionnels.

En France, nous avons besoin collectivement de plus d’informations et de plus de débats autour de ces techniques. Nous avons eu le sentiment que certains de nos représentants se sont retrouvés en partie dépourvus dans des arènes de négociations internationales, face à des représentants d’autres gouvernements qui ont un agenda très agressif sur ces technologies. C’est sans doute une des raisons pour lesquelles l’Académie des sciences s’est emparée du sujet.

L’idée des interventions de géo-ingénierie climatique, c’est de réduire les risques liés au changement climatique. Mais ces interventions pourraient-elles induire de nouveaux risques et lesquels ?

L. B. : Un des intérêts de ce rapport, c’est de mettre la lumière sur ces nouveaux risques.

Mais, avant de rentrer dans le détail, il faut, quand nous parlons de géo-ingénierie climatique, distinguer deux grandes catégories de techniques – ces deux catégories sont fondées sur des approches très différentes et présentent des risques, là aussi, très différents.

Pour la première de ces catégories, il s’agit de modifier de façon assez directe le rayonnement solaire. On parle en anglais de Solar Radiation Management ou SRM. Dans ce cas-là, l’action s’apparente plutôt à une sorte de pansement sur la plaie d’une blessure, sans s’attaquer du tout à la cause du changement climatique : l’idée est de refroidir la Terre de façon artificielle, en utilisant par exemple des particules atmosphériques ou des miroirs spatiaux qui limiteraient la pénétration du rayonnement solaire jusqu’à la surface de la Terre. Ce refroidissement pourrait compenser, en partie au moins, le réchauffement lié aux gaz à effet de serre qui continueraient à augmenter dans l’atmosphère.

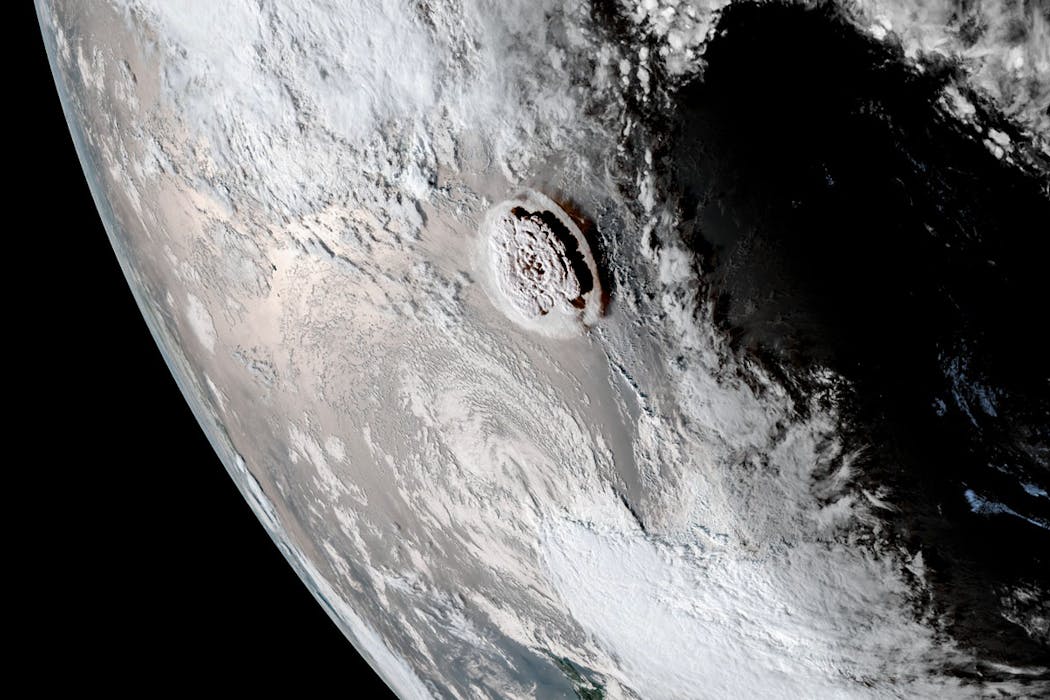

L’injection d’aérosols dans la haute atmosphère vise à imiter des éruptions volcaniques de très grande taille qui, par le passé, ont pu refroidir la Terre. Une des limites premières de cette approche, c’est que cette façon de refroidir la Terre est très différente de la façon dont elle se réchauffe aujourd’hui à cause des gaz à effet de serre : les échelles de temps et les échelles spatiales associées sont très différentes, et cela engendre un certain nombre de conséquences. Les risques sont à lire en fonction de ces deux échelles.

Les aérosols que l’on pourrait injecter dans la haute atmosphère ont une durée de vie courte. Ils vont disparaître de l’atmosphère assez rapidement, tandis que les gaz à effet de serre qui réchauffent le système Terre, le CO₂ en particulier, sont dans l’atmosphère pour très longtemps.

Cette différence majeure entraîne l’un des risques les plus préoccupants : le risque de « choc terminal ». Concrètement, si l’on décidait d’arrêter brutalement l’injection d’aérosols après s’être engagé dans ce type de stratégie

– et les raisons pourraient être multiples, qu’il s’agisse de problèmes de gouvernance, de financement ou de conflits internationaux – le réchauffement climatique jusque-là partiellement masqué réapparaîtrait d’un seul coup. On subirait alors, en très peu de temps, plusieurs années de réchauffement accumulé. On aurait des taux de réchauffement temporels très très rapides, et donc des conséquences sur la biodiversité ou sur les sociétés humaines difficiles à anticiper.

En d’autres termes, si le réchauffement arrive relativement lentement, la mise en place de mesures d’adaptation est possible ; s’il est très rapide, les conséquences sont potentiellement bien plus dévastatrices.

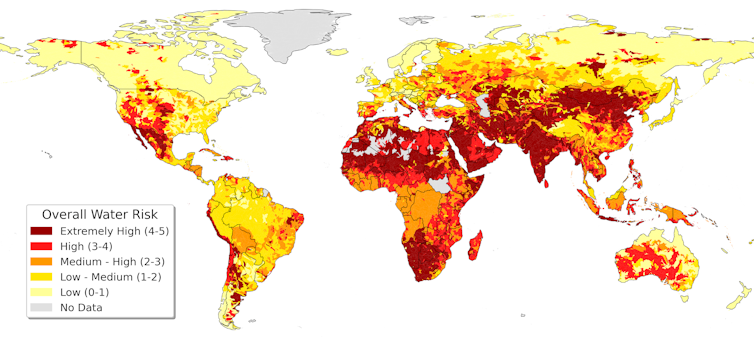

L’autre risque majeur est lié aux échelles spatiales : refroidir avec des aérosols par exemple, ce n’est pas du tout la même chose que ne pas refroidir en émettant moins de CO₂. Les effets régionaux du refroidissement vont être très différents de ce qu’ils auraient été si on avait réchauffé un peu moins. La localisation des précipitations, l’intensité de la mousson notamment ont des conséquences sur l’agriculture, sur la santé. Sur ces effets régionaux, il y a encore beaucoup d’incertitudes aujourd’hui, c’est quelque chose que les modèles décrivent moins bien que les effets temporels dont je parlais tout à l’heure.

À lire aussi :

Parasols géants et blanchiment du ciel : de fausses bonnes idées pour le climat

Face à ce risque majeur, l’Académie recommande d’arrêter le déploiement des techniques de modification du rayonnement solaire, et même les recherches sur cette technique de géo-ingénierie…

L. B. : Effectivement, notre rapport recommande de ne pas utiliser ces techniques, et nous allons même jusqu’à suggérer un traité international qui interdirait leur déploiement.

Nous pensons aussi qu’il ne faut pas financer, de façon importante, de la recherche qui soit spécifiquement fléchée sur ces techniques de modification du rayonnement solaire, pour éviter de légitimer ces approches trop dangereuses.

Bien sûr, nous avons besoin de bien plus de recherche sur le climat et sur les processus climatiques importants, donc sur les processus qui lient, par exemple, les aérosols dans la haute atmosphère avec la modification du rayonnement, mais nous pensons vraiment qu’il faut éviter les projets fondamentalement pensés pour pousser l’avènement de ces technologies. Les risques associés sont trop importants.

La géo-ingénierie climatique inclut une deuxième approche, celle qui consiste à augmenter l’efficacité des puits de carbone naturels, par exemple les forêts, les tourbières ou les océans qui absorbent naturellement du carbone. En quoi est-ce fondamentalement différent de la modification du rayonnement solaire ?

L. B. : Il ne s’agit plus de refroidir la Terre pour compenser un réchauffement qui serait lié à l’augmentation des gaz à effet de serre, mais d’éliminer du CO₂ qui est déjà présent dans l’atmosphère. Le terme consacré est celui d’« élimination du dioxyde de carbone », ou Carbon Dioxide Removal (CDR) en anglais.

D’abord, soyons clairs : la priorité des priorités reste de réduire les émissions actuelles de façon drastique. Ces « puits de carbone » additionnels ne doivent intervenir que comme un complément, après la réduction des émissions de façon massive et immédiate.

Pour stabiliser le climat et répondre aux objectifs de l’accord de Paris à 1,5 ou 2 °C de réchauffement par rapport à l’époque préindustrielle, nous avons besoin d’aller collectivement vers des émissions nettes nulles !

Comme il y aura sans doute des secteurs difficiles à décarboner, comme la sidérurgie ou le transport aérien, nous savons qu’il y aura sans doute besoin d’un peu de ces puits de carbone pour compenser ces émissions résiduelles.

On est donc sur une ligne de crête compliquée à tenir : ne pas mettre ces techniques d’élimination du CO₂ en avant, pour ne pas décourager la réduction des émissions – en raison du potentiel de décarbonation limité de ces techniques, nous allons y revenir – et en même temps continuer à soutenir la recherche sur ces technologies parce qu’elles pourraient se révéler utiles, au moins dans une certaine mesure.

En augmentant l’efficacité des puits de carbone naturels, si on reprend l’analogie avec le pansement et la blessure, on ne s’attaque toujours pas à la cause (l’émission de gaz à effet de serre), mais on remonte dans la chaîne de causalité en s’attaquant à quelque chose de plus amont que dans le cas de la modification du rayonnement solaire.

Il existe de nombreux types de méthodes d’élimination du CO₂, à la fois naturelles et technologiques. Présentent-elles toutes le même potentiel et les mêmes risques ?

L. B. : Pour éliminer du CO₂ déjà dans l’atmosphère, il y a une très grande diversité de techniques, en partie parce qu’il existe plusieurs « réservoirs » dans lesquels il serait possible de stocker le CO₂ retiré de l’atmosphère : dans le sous-sol, dans l’océan, dans la biomasse continentale.

Pour simplifier, je dirais qu’il y a une série de techniques qui sont aujourd’hui considérées comme « gagnant-gagnant » : elles permettent de retirer du CO₂ de l’atmosphère et elles ont d’autres bénéfices.

Prenons par exemple la restauration et la conservation des écosystèmes côtiers, comme les mangroves ou les herbiers marins : ces actions permettent un stockage de carbone et, par exemple, de mieux protéger les côtes contre la montée du niveau marin et les épisodes de submersion côtière. D’autres techniques, en foresterie, en agroforesterie ou en stockant le carbone dans les sols, permettent aussi de développer des pratiques agricoles qui sont plus vertueuses.

Malheureusement, comme évoqué dans le rapport, ces approches sont difficiles à mettre à l’échelle, en raison des surfaces souvent limitées et des quantités phénoménales de carbone qu’il faudrait pouvoir stocker dans ces réservoirs naturels pour avoir un effet significatif.

Et puis il y a, à l’autre bout du spectre, des techniques qui sont jugées peu efficaces et dont on sait qu’elles ont sans doute des effets dommageables sur les écosystèmes. Compte tenu des connaissances actuelles, l’Académie des sciences recommande de ne pas poursuivre dans ces directions-là.

L’exemple le mieux documenté est celui de la fertilisation par le fer du plancton marin, car elle a été envisagée il y a déjà longtemps, à la fin des années 1980. L’idée est d’aller en pleine mer, dans des régions où le développement du phytoplancton est limité par la faible abondance d’un nutriment bien particulier : le fer. Dans ces régions, il n’y a pas besoin d’ajouter beaucoup de fer pour fertiliser le plancton, qui va se développer davantage, et pour cela absorber plus de CO₂. Une partie de la matière organique produite coule ensuite vers les profondeurs de l’océan, emportant avec elle le carbone qu’elle contient. Ce carbone est ainsi isolé de l’atmosphère dans l’océan profond, potentiellement pour des centaines d’années.

Plusieurs expériences scientifiques ont été menées en pleine mer dans les années 1990 et 2000. À court terme, elles ont effectivement mis en évidence une augmentation du flux de carbone de l’atmosphère vers l’océan.

Toutefois, des travaux plus récents, notamment fondés sur la modélisation, montrent que cette technique est probablement beaucoup moins efficace qu’on ne l’imaginait initialement. Surtout, en modifiant fortement les écosystèmes marins pour capter du carbone, elle entraîne toute une série d’effets indésirables : l’émission d’autres gaz à effet de serre, une diminution de l’oxygène dans les eaux profondes, ou encore l’épuisement de certains nutriments essentiels, qui ne sont alors plus disponibles pour d’autres écosystèmes.

Ces constats ont conduit la communauté internationale à réagir. En 2008, les États ont amendé le protocole de Londres afin d’y introduire une interdiction de ce type de pratiques en haute mer.

Dans le cas de la fertilisation des océans, les risques sont donc bien documentés – ils ne concernent pas directement le climat mais des dommages collatéraux ?

L. B. : Oui. Malheureusement, on voit en ce moment une résurgence de certains projets poussés par certains chercheurs qui continuent à défendre ce type de techniques, par exemple aux États-Unis. Mais pour nous, il semble clair qu’il ne faut pas recommander ces techniques aux effets collatéraux bien documentés.

À lire aussi :

Géo-ingénierie marine : qui développe ces grands projets, et qu’y a-t-il à y gagner ?

Entre les techniques trop risquées, comme la fertilisation des océans, et les techniques de conservation et de restauration, que j’appelais « gagnant-gagnant » tout à l’heure, il y a d’autres techniques, pour lesquelles on a besoin de davantage de recherche – c’est le cas, par exemple, des techniques d’alcalinisation de l’océan.

Il s’agit d’une technique chimique cette fois : on augmente le pouvoir tampon de l’océan en ajoutant du matériel alcalin. Un des points positifs, c’est que cette technique consiste en l’accélération d’un phénomène naturel qui est l’altération des roches sur les continents. Quand les roches s’altèrent, elles apportent de l’alcalinité à l’océan, donc elles augmentent le pouvoir tampon de l’océan qui absorbe plus de CO₂ – c’est un processus très lent, qui a un rôle très important sur les échelles de temps très, très longues et qui régule en partie le cycle du carbone sur les échelles de temps géologiques.

Deuxième avantage : le CO2 ainsi stocké dans l’océan l’est de manière très durable, bien plus que dans des approches reposant sur du carbone organique (comme la fertilisation des océans) où le stockage est beaucoup plus incertain. Troisième point positif, cette augmentation de l’alcalinité permet aussi de réduire partiellement l’acidification des océans.

Mais ces bénéfices s’accompagnent de nombreuses incertitudes et de risques. Ajouter des matériaux alcalins modifie parfois fortement la chimie de l’eau de mer. Quels effets cela pourrait-il avoir sur les écosystèmes marins, le plancton ou les espèces côtières dont dépendent de nombreuses populations humaines ? À ce stade, nous manquons encore de données pour répondre clairement à ces questions.

L’efficacité même de la technique reste également incertaine. Pour qu’elle fonctionne, l’alcalinité ajoutée doit rester dans les couches de surface de l’océan, là où les échanges avec l’atmosphère ont lieu. Si elle est rapidement entraînée vers les profondeurs, son impact sur l’absorption du CO₂ devient très limité.

Enfin, il y a beaucoup de questions sur le coût de ces techniques. En particulier, un certain nombre de start-up et d’entreprises s’orientent vers des méthodes électrochimiques, mais c’est très coûteux d’un point de vue énergétique. Il faut faire le bilan sur l’ensemble du cycle de vie de ces techniques.

En somme, on a une gamme de techniques, parfois appelées abusivement « solutions » : certaines que l’on ne recommande pas aujourd’hui parce que les risques sont énormes ; d’autres qu’il faut prioriser et recommander, mais qui ont une efficacité somme toute limitée. Et puis entre les deux, des méthodes sur lesquelles il faut continuer à travailler.

À l’échelle internationale, où et quand se discutent les nouveaux risques des techniques de géo-ingénierie climatique ?

L. B. : La question des puits de carbone est déjà largement débattue dans le cadre des COP Climat, notamment parce que les gouvernements peuvent les intégrer dans leurs objectifs de réduction des émissions. C’est le cas, par exemple, des stratégies d’afforestation (boisement) et de reforestation. En revanche, il reste encore beaucoup de travail à faire sur les modalités concrètes de mise en œuvre de certaines techniques d’élimination du CO₂ que nous avons évoquées. En particulier, les questions de mesure et de vérification du CO₂ réellement retiré de l’atmosphère sont complexes et loin d’être résolues. Le Giec a d’ailleurs été mandaté par les gouvernements pour produire un rapport méthodologique spécifiquement consacré à ces enjeux.

En ce qui concerne la modification du rayonnement solaire, mon inquiétude est nettement plus forte. Certains pays affichent désormais ouvertement leur intérêt pour un déploiement potentiel de ces techniques.

Dans le prochain rapport du Giec, la géo-ingénierie occupera une place plus importante que dans les précédents. J’espère que cela permettra de documenter de façon précise et convaincante les risques potentiels associés à ces approches.

Propos recueillis par Elsa Couderc.

![]()

Bopp Laurent a reçu des financements du CNRS, de l’Agence Nationale de la Recherche, de la Fondation pour la Recherche sur la Biodiversité, du Programme Horizon Europe de la Commission Européenne, et de la Fondation Schmidt Sciences.

– ref. Géo-ingénierie climatique : de quoi parle-t-on ? Pour quelle efficacité et quels nouveaux risques ? – https://theconversation.com/geo-ingenierie-climatique-de-quoi-parle-t-on-pour-quelle-efficacite-et-quels-nouveaux-risques-272387