Source: The Conversation – in French – By Michelle Lynn Kahn, Associate Professor of History, University of Richmond

Avant l’ère d’Internet, l’extrême droite la plus radicale utilisait déjà la propagande imprimée et les premiers ordinateurs pour se connecter et recruter. Aujourd’hui, l’intelligence artificielle et le Web sont ses nouvelles armes pour atteindre un public mondialisé.

Comment la société peut-elle contrôler la propagation mondiale de l’extrémisme d’extrême droite en ligne tout en protégeant la liberté d’expression ? C’est une question à laquelle les décideurs politiques et les organisations de surveillance ont déjà été confrontés dans les années 1980 et 1990 – et elle n’a pas disparu.

Des décennies avant l’intelligence artificielle, Telegram et les streams du nationaliste blanc Nick Fuentes, les extrémistes d’extrême droite avaient déjà adopté les premiers ordinateurs personnels et Internet. Ces nouvelles technologies leur offraient un bastion de liberté d’expression et une plate-forme mondiale. Ils pouvaient y diffuser leur propagande, répandre la haine, inciter à la violence et gagner des adeptes dans le monde entier comme jamais auparavant.

Avant l’ère numérique, les extrémistes d’extrême droite se radicalisaient principalement entre eux grâce à la propagande imprimée. Ils rédigeaient leurs propres bulletins et réimprimaient des textes d’extrême droite tels que le Mein Kampf d’Adolf Hitler ou Les Carnets de Turner de l’Américain néonazi William Pierce, une œuvre de fiction dystopique décrivant une guerre raciale. Ils envoyaient ensuite cette propagande à leurs partisans, tant dans leur pays qu’à l’étranger.

Je suis historienne et j’étudie les néonazis et l’extrémisme d’extrême droite. Comme mes recherches le montrent, la plupart de la propagande néonazie saisie en Allemagne entre les années 1970 et 1990 provenait des États-Unis. Les néonazis américains exploitaient leur liberté d’expression garantie par le Premier Amendement pour contourner les lois allemandes sur la censure. Les néonazis allemands reprenaient ensuite cette propagande imprimée et la distribuaient dans tout le pays.

Cette stratégie n’était cependant pas infaillible. La propagande imprimée pouvait se perdre dans le courrier ou être confisquée, notamment lors de son arrivée en Allemagne. La production et l’expédition étaient également coûteuses et chronophages, et les organisations d’extrême droite manquaient souvent de personnel et de moyens financiers.

Passage au numérique

Les ordinateurs, qui se sont démocratisés en 1977, promettaient de résoudre ces problèmes. En 1981, Matt Koehl, dirigeant du National Socialist White People’s Party aux États-Unis, sollicite des dons pour « aider le parti à entrer dans l’ère informatique ». Le néonazi américain Harold Covington réclame, lui, une imprimante, un scanner et un « PC performant » capable de faire tourner le logiciel de traitement de texte WordPerfect. « Nos multiples ennemis possèdent déjà cette technologie », note-t-il alors, en faisant référence aux Juifs et aux responsables gouvernementaux.

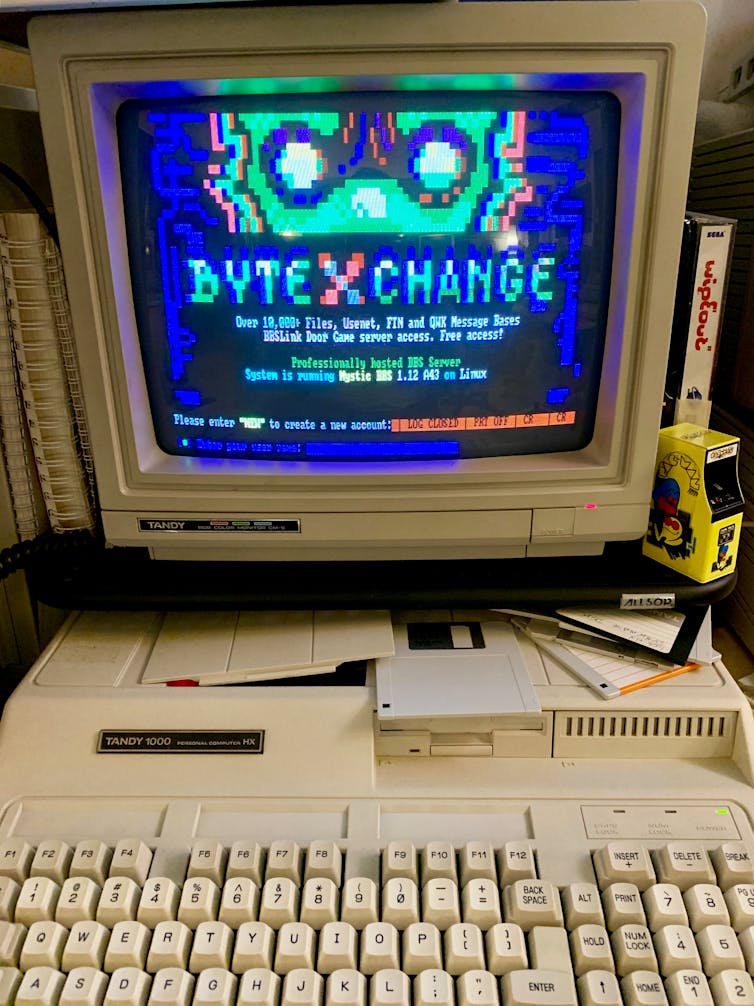

Rapidement, les extrémistes d’extrême droite ont trouvé comment connecter leurs ordinateurs entre eux. Ils utilisaient pour cela des Bulletin board system (pour systèmes de tableaux d’affichage en ligne), ou BBS, un précurseur d’Internet. Le BBS était hébergé sur un ordinateur personnel, et d’autres ordinateurs pouvaient se connecter à lui via un modem et un logiciel, permettant aux utilisateurs d’échanger messages, documents et logiciels.

Blake Patterson/Flickr, CC BY

Avec les BBS, toute personne souhaitant accéder à la propagande d’extrême droite pouvait simplement allumer son ordinateur et composer le numéro de téléphone annoncé par une organisation. Une fois connectée, elle pouvait lire les publications publiques, échanger des messages et télécharger ou téléverser des fichiers.

Le premier système de tableaux d’affichage d’extrême droite, le Aryan Nations Liberty Net, a été créé en 1984 par Louis Beam, un membre haut placé du Ku Klux Klan et des Aryan Nations. Beam expliquait : « Imaginez, si vous le pouvez, un seul ordinateur auquel tous les dirigeants et stratèges du mouvement patriotique sont connectés. Imaginez encore que tout patriote du pays puisse accéder à cet ordinateur à volonté afin de bénéficier de tout le savoir et de toute l’expérience accumulés par les dirigeants. “Un jour peut-être”, direz-vous ? Et pourquoi pas aujourd’hui ? »

Puis sont apparus des jeux néonazis violents pour ordinateurs. Les néonazis aux États-Unis et ailleurs pouvaient téléverser et télécharger ces jeux via les BBS, les copier sur des disquettes et les distribuer largement, notamment aux enfants.

Dans le jeu allemand KZ Manager, les joueurs incarnaient un commandant d’un camp de concentration nazi qui assassinait des Juifs, des Sintés et des Roms ainsi que des immigrants turcs. Un sondage du début des années 1990 révélait que 39 % des lycéens autrichiens connaissaient l’existence de tels jeux et que 22 % en avaient déjà vu.

Arrivée du Web

Au milieu des années 1990, avec l’arrivée du World Wide Web plus facile d’accès, les BBS ont perdu de leur popularité. Le premier site majeur de haine raciale sur Internet, Stormfront, a été fondé en 1995 par le suprémaciste blanc américain Don Black. L’organisation de défense des droits civiques Southern Poverty Law Center a établi que près de 100 meurtres étaient liés à Stormfront.

En 2000, le gouvernement allemand avait découvert et interdit plus de 300 sites web allemands à contenu d’extrême droite – soit une multiplication par dix en seulement quatre ans.

En réponse, les suprémacistes blancs américains ont de nouveau exploité leurs droits à la liberté d’expression pour contourner les interdictions de censure allemandes. Ils ont offert aux radicaux d’extrême droite du monde entier la possibilité d’héberger leurs sites web en toute sécurité et anonymat sur des serveurs américains non régulés – une stratégie qui perdure encore aujourd’hui.

L’IA, nouvelle frontière

La prochaine frontière pour les radicaux d’extrême droite est l’IA. Ils utilisent des outils d’intelligence artificielle générative pour créer de la propagande ciblée, manipuler images, sons et vidéos, et échapper à la détection. Le réseau social d’extrême droite Gab a même créé un chatbot Hitler avec lequel les utilisateurs peuvent discuter.

Des chatbots adoptent également les vues d’extrême droite des utilisateurs des réseaux sociaux. Grok, le chatbot d’Elon Musk, s’est récemment appelé MechaHitler, a diffusé des propos antisémites et a nié l’Holocauste.

Lutte contre l’extrémisme

Combattre la haine en ligne est une urgence mondiale. Cela nécessite une coopération internationale étroite entre gouvernements, organisations non gouvernementales, associations de surveillance, communautés et entreprises technologiques.

Les radicaux d’extrême droite sont depuis longtemps à la pointe de l’exploitation des avancées technologiques et de la liberté d’expression. Les efforts pour contrer cette radicalisation doivent constamment tenter de garder une longueur d’avance sur leurs innovations technologiques.

![]()

Michelle Lynn Kahn a reçu des financements du National Humanities Center, du United States Holocaust Memorial Museum, de l’American Historical Association et des American Jewish Archives.

– ref. Les néo-nazis n’ont pas attendu Internet pour s’organiser en ligne – https://theconversation.com/les-neo-nazis-nont-pas-attendu-internet-pour-sorganiser-en-ligne-272356