Source: The Conversation – (in Spanish) – By Antonio García-Amate, Lecturer in Finance, Universidad Pública de Navarra

Las cifras extraídas de la base de datos LSEG (London Stock Exchange Group) indican un incremento significativo en el tránsito de petróleo ruso por aguas españolas. Antes de las sanciones que la Unión Europea (UE) impuso a Rusia con motivo de la invasión de Ucrania, el puerto de Ceuta ocupaba la posición 90.ª en el ranking europeo de descargas de petróleo ruso. Hoy, está en la 11.ª posición.

Mientras Bruselas trata de bloquear este tráfico, la “flota fantasma” rusa utiliza puertos españoles para exportar crudo a Europa. El objetivo es eludir las sanciones impuestas por la UE. Las consecuencias son económicas y geopolíticas, pero también medioambientales.

El sur de Europa como vía de entrada

Las sanciones a Rusia han redefinido el mapa de flujos de petróleo y gas rusos hacia la UE. La normativa vigente prohíbe la entrada de los barcos de la “flota fantasma” en puertos europeos. Sin embargo, la realidad es otra. Aunque en diciembre de 2025 el número de buques sancionados ascendía a casi 600, la lentitud en trasponer la Directiva UE 2024/1226 y en aplicar de forma efectiva las restricciones aprobadas por la UE genera una laguna jurídica que es aprovechada por la flota rusa.

Así, se han detectado violaciones de las sanciones europeas por entradas de buques sancionados en países como Chipre, España, Estonia, Grecia, Malta y Países Bajos.

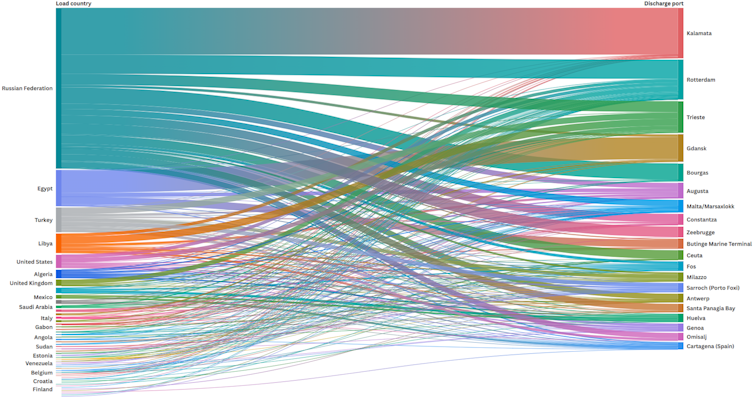

Al cerrarse el norte de Europa, la flota rusa ha encontrado una vía alternativa de entrada en los países del sur. Entre 2022 y 2025, los países con más descargas de buques con petróleo de origen ruso fueron Italia, Grecia y España. La mayoría de estos buques han sido sancionados en algún momento posterior a su atraque en puertos europeos.

Pese a las prohibiciones, el crudo ruso sigue llegando a la UE, a menudo haciendo escalas en otros países. Los cargamentos provienen principalmente de Rusia, pero también de Egipto y Turquía, que actúan como intermediarios.

Esta infraestructura operativa no surgió de la noche a la mañana. La Unión Europea no empezó a sancionar oficialmente a buques de la “flota fantasma” hasta junio de 2024. Ese retraso hizo que Rusia tuviera tiempo suficiente para reorganizar su estrategia logística para exportar petróleo a la UE.

En el sur se han dado cada vez más casos de traspase de petróleo de un barco a otro en alta mar, con los daños medioambientales que esto pueda ocasionar. Eligen el sur porque necesitan aguas tranquilas y una ubicación estratégica para conectar con Asia, algo que el mar del Norte no ofrece.

Así actúa la “flota fantasma”

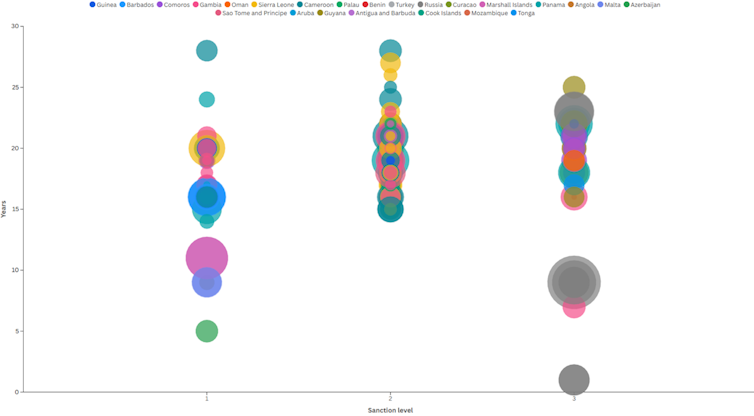

Las implicaciones de la operación de la “flota fantasma” van más allá de cuestiones económicas o geopolíticas. Estos buques generan riesgos físicos y medioambientales significativos. Se trata de una flota con barcos de gran edad y una operación insegura y precaria. Los petroleros con una antigüedad de entre 16 y 22 años son los más sancionados. Según el KSE Institute ucraniano, a partir de los 15 años decae el mantenimiento y las aseguradoras de primer nivel retiran su cobertura.

Para operar sorteando las restricciones legales, los buques suelen cambiar su bandera, su nombre o el armador. Las cinco banderas más sancionadas son las de Rusia, Gambia, Sierra Leona, Camerún y Omán. Los buques más antiguos, con máximo riesgo físico y medioambiental, utilizan principalmente la bandera rusa, seguida por la de países con regulación laxa como Curazao, Benín, Comoras, Guyana y Omán.

Además, la propiedad del buque se esconde para evitar posibles sanciones: las tres compañías con el mayor número de buques sancionados tienen su sede en UAE (Emiratos Árabes Unidos).

Leer más:

Guerra silenciosa en alta mar: ¿cómo operan los barcos fantasma?

España como centro logístico

España ha pasado a ser un enclave protagonista en la red de flujos del petróleo ruso. Entre los 20 puertos de la UE donde se han producido más atraques de buques posteriormente sancionados se encuentran Ceuta (11.º), Huelva (17.º) y Cartagena (20.º).

Los autores, CC BY-SA

El riesgo físico y medioambiental en estos puertos derivado de la operación de la “flota fantasma” es elevado. Los buques sancionados por dos jurisdicciones (por ejemplo, UE y EE. UU.) tienen entre 15 y 30 años de antigüedad, con banderas de países variados. Por otro lado, la flota de buques sancionados por tres jurisdicciones destaca por su alto volumen de comercialización y la utilización de la bandera rusa.

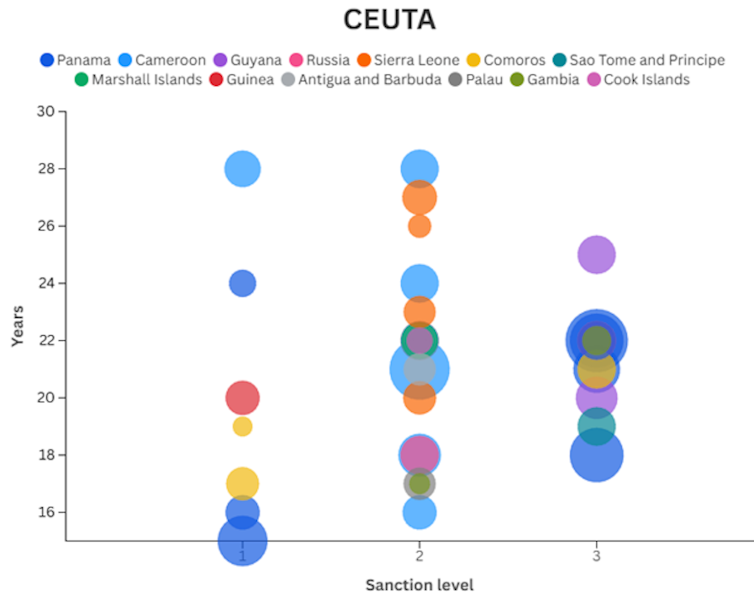

Los autores, CC BY-SA

El caso de Ceuta presenta el escenario más preocupante desde el punto de vista medioambiental. Se trata de un puerto con un alto volumen de descargas, la mayoría desde buques posteriormente sancionados por hasta dos y tres jurisdicciones, con antigüedad de entre 15 y 28 años y banderas como las de Sierra Leona, Camerún y Panamá. Estos buques operan con estándares de seguridad poco estrictos.

Los autores, CC BY-SA

Un problema creciente

Los datos revelan un caso flagrante. Se trata de un buque con bandera de Camerún, sancionado el 25 de febrero de 2025 por la UE, que descargó en Ceuta casi 900 000 barriles de crudo el 12 de septiembre de 2025. Este barco provenía del puerto de Murmansk (Rusia).

Además, la “flota fantasma” rusa busca nuevas entradas a la UE. Puertos como los de El Hierro, Motril y Vilagarcía de Arousa, que no habían recibido cargamentos antes de las sanciones a Rusia, sí lo han hecho tras el estallido de la guerra. En 2023, por ejemplo, fueron descargados en ellos más de 1 800 000 barriles por buques provenientes de Rusia con una antigüedad de entre 15 y 23 años.

El volumen de operaciones de la “flota fantasma” rusa en aguas españolas está aumentando. España importa millones de barriles de petróleo ruso transportados en buques antiguos e inseguros. Esto no solo contraviene la normativa europea sobre las sanciones a Rusia, sino que genera riesgos medioambientales y físicos que no pueden ignorarse.

La solución a este problema implica no solo aplicar las sanciones vigentes a los buques de la “flota fantasma” rusa, sino también buscar vías para impedir el atraque y las operaciones de trasvase de buques sospechosos. Si no se actúa ya, la próxima noticia podría ser una catástrofe ecológica como la ocurrida a finales de 2002 frente las costas de Galicia.

![]()

Orkestra-Instituto Vasco de Competitividad se financia en parte a través de convenios de investigación sobre temas diversos relacionados con energía y medioambiente firmados con el Ente Vasco de la Energía, Iberdrola, Petronor e Ihobe-Agencia Vasca del Medioambiente.

Antonio García-Amate no recibe salario, ni ejerce labores de consultoría, ni posee acciones, ni recibe financiación de ninguna compañía u organización que pueda obtener beneficio de este artículo, y ha declarado carecer de vínculos relevantes más allá del cargo académico citado.

– ref. La “flota fantasma” rusa incrementa su operación en puertos españoles para burlar el bloqueo de la UE – https://theconversation.com/la-flota-fantasma-rusa-incrementa-su-operacion-en-puertos-espanoles-para-burlar-el-bloqueo-de-la-ue-273250