Source: The Conversation – USA (2) – By Ramesh Agarwal, Professor of Engineering, Washington University in St. Louis

As AI data centers spring up across the country, their energy demand and resulting greenhouse gas emissions are raising concerns. With servers and energy-intensive cooling systems constantly running, these buildings can use anywhere from a few megawatts of power for a small data center to more than 100 megawatts for a hyperscale data center. To put that in perspective, the average large natural gas power plant built in the U.S. generates less than 1,000 megawatts.

When the power for these data centers comes from fossil fuels, they can become major sources of climate-warming emissions in the atmosphere – unless the power plants capture their greenhouse gases first and then lock them away.

Google recently entered into a unique corporate power purchase agreement to support the construction of a natural gas power plant in Illinois designed to do exactly that through carbon capture and storage.

So how does carbon capture and storage, or CCS, work for a project like this?

I am an engineer who wrote a 2024 book about various types of carbon storage. Here’s the short version of what you need to know.

How CCS works

When fossil fuels are burned to generate electricity, they release carbon dioxide, a powerful greenhouse gas that remains in the atmosphere for centuries. As these gases accumulate in the atmosphere, they act like a blanket, holding heat close to the Earth’s surface. Too high of a concentration heats up the Earth too much, setting off climate changes, including worsening heat waves, rising sea levels and intensifying storms.

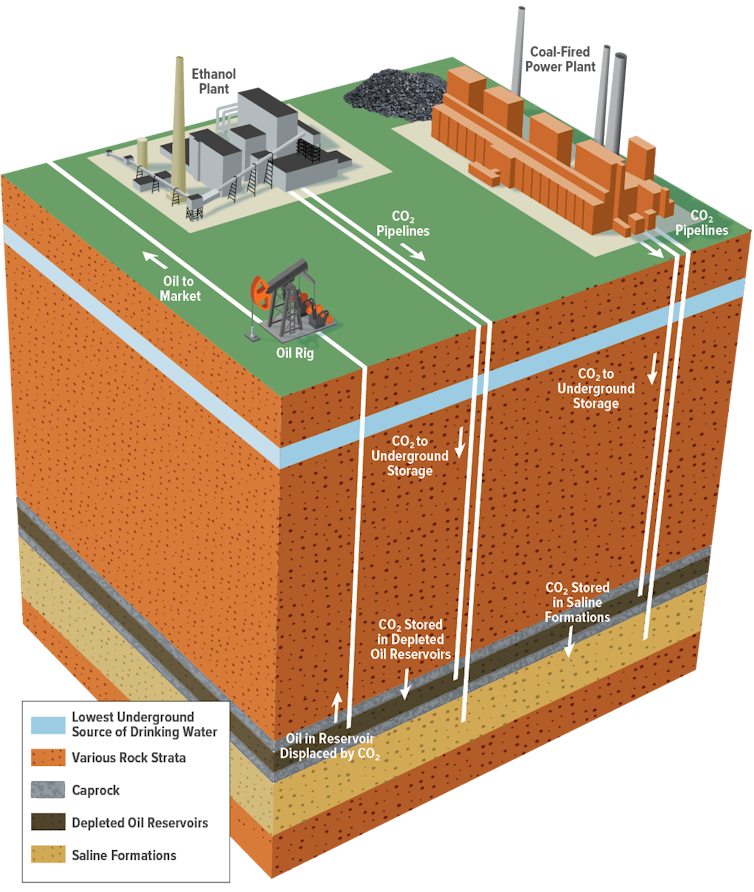

Carbon capture and storage involves capturing carbon dioxide from power plants, industrial processes or even directly from the air and then transporting it, often through pipelines, to sites where it can be safely injected underground for permanent storage.

Congressional Budget Office, U.S. Federal Government

The carbon dioxide might be transported as a supercritical gas – which is right at the phase change from liquid to gas and has the properties of both – or dissolved in a liquid. Once injected deep underground, the carbon dioxide can become permanently trapped in the geologic structure, dissolve in brine or become mineralized, turning it to rock.

The goal of carbon storage is to ensure that carbon dioxide can be kept out of the atmosphere for a long time.

Types of underground carbon storage

There are several options for storing carbon dioxide underground.

Depleted oil and natural gas reservoirs have plentiful storage space and the added benefit that most are already mapped and their limits understood. They already held hydrocarbons in place for millions of years.

Carbon dioxide can also be injected into working oil or gas reservoirs to push out more of those fossil fuels while leaving most of the carbon dioxide behind. This method, known as enhanced oil and gas recovery, is the most common one used by carbon capture and storage projects in the U.S. today, and one reason CCS draws complaints from environmental groups.

Volcanic basalt rock and carbonate formations are considered good candidates for safe and long-term geological storage because they contain calcium and magnesium ions that interact with carbon dioxide, turning it into minerals. Iceland pioneered this method using its bedrock of volcanic basalt for carbon storage. Basalt also covers most of the oceanic crust, and scientists have been exploring the potential for sub-seafloor storage reservoirs.

In the U.S., a fourth option likely has the most potential for industrial carbon dioxide storage – deep saline aquifers, which is what Google plans to use. These widely distributed aquifers are porous and permeable sediment formations consisting of sandstone, limestone or dolostone. They’re filled with highly mineralized groundwater that cannot be used directly for drinking water but is very suitable for storing CO2.

Deep saline aquifers also have large storage capacities, ranging from about 1,000 to 20,000 gigatons. In comparison, the nation’s total carbon emissions from fossil fuels in 2024 were about 4.9 gigatons.

As of fall 2025, 21 industrial facilities across the U.S. used carbon capture and storage, including industries producing natural gas, fertilizer and biofuels, according to the Global CCS Institute’s 2025 report. Five of those use deep saline aquifers, and the rest involve enhanced oil or gas recovery. Eight more industrial carbon capture facilities were under construction.

Google’s plan is unique because it involves a power purchase agreement that makes building the power plant with carbon capture and storage possible.

Google’s deep saline aquifer storage plan

Google’s 400-megawatt natural gas power plant, to be built with Broadwing Energy, is designed to capture about 90% of the plant’s carbon dioxide emissions and pipe them underground for permanent storage in a deep saline aquifer in the nearby Mount Simon sandstone formation.

The Mount Simon sandstone formation is a huge saline aquifer that lies underneath most of Illinois, southwestern Indiana, southern Ohio and western Kentucky. It has a layer of highly porous and permeable sandstone that makes it an ideal candidate for carbon dioxide injection. To keep the carbon dioxide in a supercritical state, that layer needs to be at least half a mile (800 meters) deep.

A thick layer of Eau Claire shale sits above the Mount Simon formation, serving as the caprock that helps prevent stored carbon dioxide from escaping. Except for some small regions near the Mississippi River, Eau Claire shale is considerably thick – more than 300 feet (90 meters) – throughout most of the Illinois basin.

The estimated storage capacity of the Mount Simon formation ranges from 27 gigatons to 109 gigatons of carbon dioxide.

The Google project plans to use an existing injection well site that was part of the first large-scale carbon storage demonstration in the Mount Simon formation. Food producer Archer Daniels Midland began injecting carbon dioxide there from nearby corn processing plants in 2012.

Carbon capture and storage has had challenges as the technology developed over the years, including a pipeline rupture in 2020 that forced evacuations in Satartia, Mississippi, and caused several people to lose consciousness. After a recent leak deep underground at the Archer Daniels Midland site in Illinois, the Environmental Protection Agency in 2025 required the company to improve its monitoring. Stored carbon dioxide had migrated into an unapproved area, but no threat to water supplies was reported.

Why does CCS matter?

Data centers are expanding quickly, and utilities will have to build more power capacity to keep up. The artificial intelligence company OpenAI is urging the U.S. to build 100 gigawatts of new capacity every year – doubling its current rate.

Many energy experts, including the International Energy Agency, believe carbon capture and storage will be necessary to slow climate change and keep global temperatures from reaching dangerous levels as energy demand rises.

![]()

Ramesh Agarwal does not work for, consult, own shares in or receive funding from any company or organization that would benefit from this article, and has disclosed no relevant affiliations beyond their academic appointment.

– ref. Google plans to power a new data center with fossil fuels, yet release almost no emissions – here’s how its carbon capture tech works – https://theconversation.com/google-plans-to-power-a-new-data-center-with-fossil-fuels-yet-release-almost-no-emissions-heres-how-its-carbon-capture-tech-works-270425