Source: The Conversation – France (in French) – By Thierry Gauquelin, Professeur émérite, Institut méditerranéen de biodiversité et d’écologie marine et continentale (IMBE), Aix-Marseille Université (AMU)

C’est un arbre pourvoyeur de multiples ressources depuis des millénaires et à la résilience remarquable lorsqu’il est confronté aux flammes. Le chêne-liège est cependant aujourd’hui menacé, d’un côté comme de l’autre de la Méditerranée, par le changement climatique ainsi que par sa surexploitation ou son abandon.

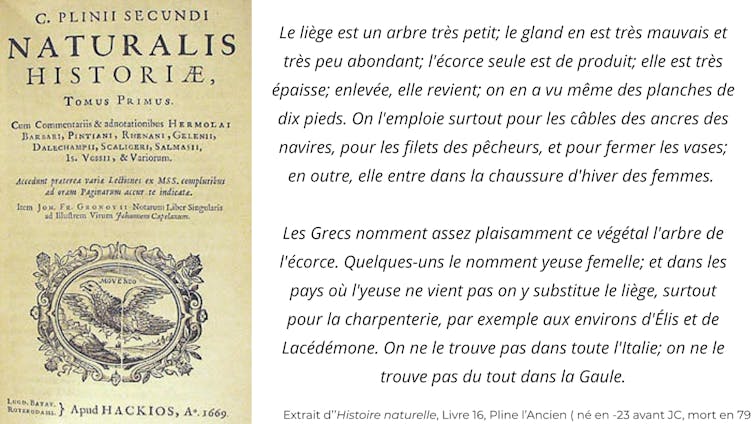

Alcornoque, surera, ballot, leuge, rusque, surier, suve, corcier… tous ces noms renvoient en fait à un seul et même arbre, le chêne-liège (Quercus suber) dont Pline l’Ancien (Ier siècle de notre ère) vantait déjà tous les mérites et utilisations.

Thierry Gauquelin, Fourni par l’auteur

Ce chêne d’une hauteur moyenne de 10 mètres à 15 mètres, dont le feuillage persistant est assez semblable à celui du chêne vert (Quercus ilex), en diffère par son houppier étalé, ses grosses branches maîtresses – les charpentières – relativement horizontales et surtout par son écorce exubérante – le liège – un matériau exceptionnel à l’origine de l’intérêt que cet arbre a pu susciter et suscite encore.

C’est bien sûr l’utilisation du liège pour les bouchons, mais aussi dans le BTP en tant qu’isolant phonique et thermique avec aujourd’hui des avancées prometteuses dans le domaine de l’écoconstruction des bâtiments ou encore pour les fusées Ariane.

Gallica

Ainsi, les forêts de chêne-liège, qualifiées de systèmes socio-écologiques, ont été exploitées, soignées et modifiées depuis plus de trois mille ans, principalement pour ce liège, mais aussi pour leurs fruits, les glands, qui nourrissent ou ont nourri autant les humains que le bétail.

Dans sa région d’origine, la suberaie – c’est ainsi qu’on nomme une forêt de chêne-liège – a ainsi été largement favorisée par l’être humain. Observez nombre de suberaies des Albères, dans les Pyrénées ; vous verrez que les arbres sont peu ou prou alignés, c’est là le signe de la main humaine.

Malgré cette exploitation millénaire, ces suberaies peuvent héberger une biodiversité remarquable, notamment une faune spécifique et inféodée au bois mort et aux microhabitats que forment les vieux arbres souvent présents dans ces suberaies exploitées. La suberaie représente aussi l’habitat de prédilection de la tortue d’Hermann, unique espèce de tortue terrestre présente en France hexagonale et en Corse.

Au Maroc, ces écosystèmes abritent des petites mares temporaires, les dayas, à la biodiversité exceptionnelle, malheureusement menacées par le changement climatique et la surexploitation.

Thierry Gauquelin, Fourni par l’auteur

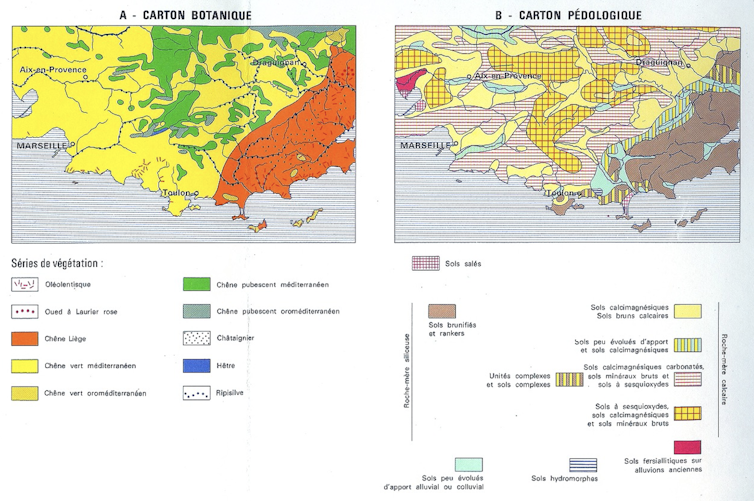

Une répartition liée au climat et au sol

Le chêne-liège est endémique du bassin occidental de la Méditerranée, présent sur les deux rives sud et nord, du Maroc à l’Italie, mais il n’est pas limité au seul climat méditerranéen. On le trouve ainsi en grande quantité au Portugal, un des principaux producteurs de liège, mais aussi sur tout le littoral aquitain, comme dans la forêt des Landes. En France, ces suberaies recouvrent environ 70 000 hectares (ha) sur trois principaux secteurs : les massifs provençaux des Maures et de l’Esterel, le sud de la Corse et les Pyrénées-Orientales.

Autre caractéristique de ce chêne-liège, c’est une espèce exclusivement calcifuge, c’est-à-dire qu’elle fuit littéralement les terrains calcaires. C’est ce qui va régir sa répartition dans ce domaine méditerranéen. Ainsi, en Provence marseillaise calcaire, vous ne trouverez pas de chêne-liège. En revanche, passé Toulon, vers l’est, dans l’Esterel ou les Maures, le chêne-liège apparaît spontanément.

CNRS, Fourni par l’auteur

Les suberaies, derniers remparts contre l’incendie

Le chêne-liège est un arbre qui résiste fort bien à l’incendie du fait de cette couche épaisse d’écorce isolante, le liège, qui entoure le tronc. Si un incendie balaie une suberaie, le liège pourra être consumé sur plusieurs centimètres, mais rapidement des bourgeons dormants sous cette écorce se développeront et l’arbre repartira.

La périodicité de ces incendies doit évidemment rester raisonnable, sinon la biodiversité, notamment du sol, sera trop profondément affectée par ces perturbations récurrentes, compromettant ainsi le bon fonctionnement de ces forêts ; et la récolte de liège, qui ne peut se faire que tous les 8 ans à 15 ans, est dans tous les cas plus que compromise.

Dans le massif landais, où cette essence était autrefois bien représentée et exploitée, cette résilience à l’incendie et le rôle de pare-feu que peuvent jouer les suberaies doivent ainsi encourager des plantations massives de chêne-liège. Cela permet aussi de constituer des peuplements plus diversifiés donc plus résilients que les plantations monospécifiques de pin maritime.

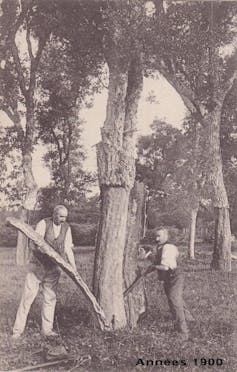

Démasclage et subériculture

Collectif Forêt Vivante Sud Gironde

La récolte du liège, essence même de la subériculture, est une affaire de spécialistes. Le chêne-liège est caractérisé par le développement exubérant de l’écorce, boursouflée et crevassée, ce fameux liège aux caractéristiques exceptionnelles. Mais cette écorce épaisse, observable sur les arbres qui n’ont pas été exploités, et qualifiée de « liège mâle », est inutilisable pour la fabrication de bouchons bien denses et réguliers. Elle sera par contre utilisée comme matériau isolant. Dans tous les cas, il faut donc enlever ce liège mâle ; cette opération s’appelle le « démasclage ».

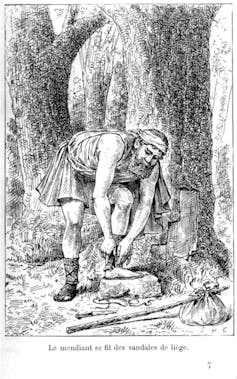

Le rusquier (l’ouvrier qui lève l’écorce du chêne-liège) l’ôte à l’aide d’incisions verticales faites avec une hachette particulière, sur une hauteur d’environ deux mètres à partir du sol, séparant ainsi deux moitiés de l’écorce.

Thierry Gauquelin, Fourni par l’auteur

Thierry Gauquelin, Fourni par l’auteur

Il faut procéder d’une manière très précautionneuse, de façon à ne pas abîmer l’assise qui donne naissance au liège. C’est un travail de spécialistes – lesquels se font de plus en plus rares et donc convoités. Le liège mâle enlevé, le tronc apparaît rouge vif.

Thierry Gauquelin, Fourni par l’auteur

Un nouveau liège, bien dense, de très belle qualité, appelé le liège femelle, se forme alors. Au bout d’une période de huit à douze ans, on le récoltera quand son épaisseur permettra d’en extraire à l’emporte-pièce des bouchons de belle longueur.

À chaque démasclage, on montera un peu plus haut dans l’arbre. Quand des arbres présentent un démasclage très haut, jusqu’aux branches charpentières qui partent directement du tronc, on peut en déduire qu’ils sont très anciens, qu’ils ont 150 ans ou 200 ans, rarement plus d’ailleurs, car le chêne-liège n’est quand même pas une espèce très longévive.

C’est ensuite terminé sur le terrain. Les plaques de liège récoltées vont approvisionner les bouchonneries, comme les Bouchons Abel du Boulou (Pyrénées-Orientales), l’une des dernières en France à encore se fournir en liège local des Albères.

Thierry Gauquelin, CC BY

Des suberaies aujourd’hui dépérissantes et menacées

Bien que particulièrement résilientes face aux incendies, les suberaies sont menacées dans toute leur aire de répartition du fait à la fois, selon les pays concernés, de leur surexploitation, de leur abandon ou encore du changement climatique.

Thierry Gauquelin, Fourni par l’auteur

Ainsi au Maroc, la forêt de la Maamora, au nord-est de Rabat, considérée comme la plus grande suberaie d’un seul tenant au monde, est aujourd’hui réduite à 60 000 ha (sa surface était de plus de 100 000 ha dans les années 1950). Elle a subi de très fortes dégradations au cours de ces dernières décennies, notamment du fait de l’essor des plantations d’eucalyptus privilégié pour sa croissante rapide, sa résistance à la sécheresse et son utilisation pour la pâte à papier.

Thierry Gauquelin, Fourni par l’auteur

Cette suberaie reste néanmoins pourvoyeuse de nombreuses ressources pour les populations environnantes. Les dimanche de printemps dans la Maamora, près de Rabat, on verra comme cela tout à la fois le démasclage à la sauvette des arbres encore préservés, mais aussi le gaulage : les branches des chênes sont battues avec une longue perche pour faire tomber les fruits – des glands doux vendus ensuite bouillis à quelques dirhams le kilo pour le plus grand plaisir des enfants. On apercevera également le pâturage avec des bovins prélevant les feuilles encore tendres jusqu’à la hauteur que leur encolure tendue permet, la coupe par les bergers des branches afin de faciliter la tâche des animaux. Se joignent à ce tableaux quelques Rabatis pique-niquant sous les plus gros arbres à l’ombre cependant légère, après la récolte sauvage de bois mort pour cuire les brochettes.

Autant d’usages qui, au même titre que la biodiversité, sont menacés aujourd’hui par la sécheresse récurrente liée au changement climatique sur l’ensemble des suberaies allant de Rabat à Ben Slimane.

En France, c’est au contraire d’abord l’abandon progressif de l’exploitation des suberaies lié pour partie à la faible rentabilité de cette activité de subériculture qui menace ces écosystèmes. Cet abandon a rendu notamment les peuplements embroussaillés plus sensibles aux incendies.

D’autres facteurs aggravent ce déclin, comme une régénération naturelle très faible, des blessures dues à des démasclages mal réalisés ou l’installation d’insectes xylophages, tels que le coléoptère Platypus cylindrus qui peut localement pulluler et rapidement tuer des chênes-lièges. Et ce sont aussi aujourd’hui les canicules et sécheresses répétées liées au changement climatique qui aggravent ce dépérissement.

Tout ceci explique le classement comme vulnérables (VU) par l’UICN des suberaies méditerranéennes.

Relancer la subériculture en France en s’appuyant sur la science et sur la formation

Le maintien de ces systèmes socio-écologiques particuliers, à la biodiversité remarquable et jouant un rôle écologique majeur, notamment dans la lutte contre les incendies ou le maintien de sols fonctionnels, ne peut s’envisager qu’en intégrant une dimension socio-économique, tant ces deux composantes écologiques et économiques sont ici liées. Il s’agit alors de relancer économiquement la filière pour permettre notamment de préserver ces écosystèmes multifonctionnels. Différentes structures (Institut du liège, Subéraie varoise…) s’attachent aujourd’hui à cet objectif.

Ceci peut s’envisager notamment en privilégiant des circuits courts, économiquement rentables, en ciblant sans doute la production de bouchons haut de gamme, tout en explorant des nouvelles filières de valorisation du liège mâle.

Il s’agit aussi de favoriser la biodiversité, garante du bon fonctionnement de l’écosystème et de la qualité du liège récolté, et la résilience des peuplements aux aléas climatiques et notamment aux incendies.

Des travaux de recherche préliminaires menés par l’Institut méditerranéen de biodiversité et d’écologie marine et continentale (IMBE) dans le massif des Albères (Pyrénées) ont ainsi pu mettre en évidence qu’un débroussaillage et un pâturage des parcelles exploitées pour le liège favorisait une biodiversité floristique et faunistique caractéristique des milieux plus secs et plus lumineux et différente de celle que l’on retrouvait dans les parcelles laissées en libre évolution.

Cependant la pression exercée sur les suberaies doit rester raisonnée autant que possible. En effet, d’autres travaux menés par l’IMBE en collaboration avec l’Université Hassan-II de Casablanca ont montré quant à eux qu’une surexploitation de parcelles de chênes-lièges dans la région de Ben Slimane conduisait à une perte de biodiversité du sol et de sa capacité à séquestrer du carbone.

Mais la science seule ne suffit pas, et les suberaies nous montrent que nous avons de plus en plus besoin de professionnels et de chercheurs capables de travailler dans plusieurs disciplines et avec divers acteurs, en combinant les connaissances issues de différentes disciplines afin de contribuer à cet objectif commun de préservation et de valorisation.

Du point de vue académique, comprendre la suberaie comme système socio-écologique est un exercice complexe qui demande l’analyse des relations économiques, sociales et institutionnelles internationales, des savoir-faire traditionnels, sous des contraintes écologiques et climatiques profondément impactées par les particularités du XXIe siècle.

Ces écosystèmes constituent ainsi aujourd’hui « un terrain de jeu » idéal pour des formations universitaires académiques dispensées conjointement à Aix-Marseille Université et à l’Université Hassan-II de Casablanca où l’enseignement de la transdisciplinarité est réalisé en ancrant les apprentissages dans un problème concret.

Thierry Gauquelin, Fourni par l’auteur

Cependant, dans l’Hexagone, malgré la banalité des bouchons de liège, les relations étroites que les habitants des Albères, des massifs des Maures et des Landes entretiennent avec ces suberaies sont aujourd’hui anecdotiques, alors qu’une meilleure connaissance de ce patrimoine, à la fois biologique et culturel, est un préalable à ce nouvel essor.

![]()

Anne Bousquet-Mélou a reçu des financements de la fondation amidex et de l’institut méditerranéen pour la transition environnementale de l’université d’Aix-Marseille

Irene Teixidor-Toneu a reçu des financements de l’agence nationale de la recherche (ANR).

Mathieu Santonja a reçu des financements de l’Agence nationale de la recherche (ANR), France 2030 et l’Union Européenne.

Thierry Gauquelin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Le chêne-liège, un arbre victime de la surexploitation de ses forêts comme de leur abandon – https://theconversation.com/le-chene-liege-un-arbre-victime-de-la-surexploitation-de-ses-forets-comme-de-leur-abandon-269747