Source: The Conversation – Indonesia – By Faustine Rousselot, Docteure en sciences de l’éducation et de la formation, Université de Lille

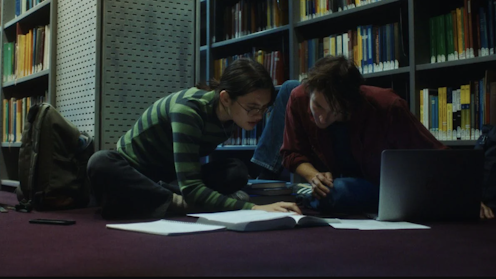

Véritable cheminement intellectuel, le doctorat peut aussi, par la précarité qu’il induit, devenir un véritable parcours du combattant au quotidien, fragilisant durablement les jeunes chercheurs sur le plan psychologique comme économique. Retour sur les enseignements d’une enquête autour de 15 parcours en sciences humaines et sociales.

Avec le Vacataire, publié en 2025, l’économiste Thomas Porcher a mis un coup de projecteur sur la précarité de ces enseignants non fonctionnaires. Souvent doctorants ou jeunes docteurs, ils sont payés à l’heure de cours, n’ont pas accès aux protections sociales et leur salaire peut leur être versé plusieurs mois après leur intervention.

Ces vacataires représenteraient aujourd’hui près de deux tiers des personnes assurant des cours dans les universités françaises, estime Thomas Porcher. Mais cette précarité ne commence pas avec les vacations : elle s’installe dès la thèse. En France, le doctorat dure en moyenne de quatre à six ans en sciences humaines et sociales, avec pour objectif la production de savoirs nouveaux. Dans ces disciplines, certains doctorants obtiennent un contrat doctoral ou une bourse, mais cela reste minoritaire : beaucoup d’entre eux doivent travailler à côté de leurs recherches pour subvenir à leurs besoins.

À lire aussi :

Des enseignants-chercheurs à la recherche du temps perdu : regard sur le malaise universitaire

Nombre de vacataires sont encore doctorants, et les heures mal rémunérées s’ajoutent à une surcharge de travail (manuscrit à rédiger, préparation de cours, publication à produire), à un manque de reconnaissance (peu de valorisation institutionnelle, faible intégration dans les équipes de recherche) et à une forte solitude. Loin d’être une exception, ces vacations s’inscrivent dans un système plus vaste de fragilisation du monde académique, qui oblige nombre de doctorants à consentir des sacrifices invisibles pour simplement rester dans la course.

En parallèle de mon activité d’attachée temporaire d’enseignement et de recherche (Ater), j’ai mené une enquête auprès de 15 jeunes docteurs en sciences humaines et sociales, récemment diplômés. Leurs récits ne racontent pas tant une réussite académique qu’un chemin marqué par l’incertitude, les renoncements et l’épuisement. Plusieurs évoquent des projets personnels reportés, un isolement prolongé ou un sentiment de vide à l’issue de la soutenance. Ces témoignages soulèvent une question : que nous dit le doctorat sur la manière dont l’université forme, encadre et, parfois, fragilise ses futurs chercheurs ?

Une vie mise entre parenthèses

Tout le monde le sait, faire une thèse est difficile. Mais souvent, on imagine que cette difficulté sera d’abord intellectuelle. Or, dans les 15 récits que j’ai recueillis, personne ne se plaint d’exigences intellectuelles trop élevées. Les difficultés sont ailleurs. Les renoncements sont d’ordre personnel.

Clotilde a mené toute sa thèse sans financement : elle a travaillé en tant que « nanny », puis a enchaîné des vacations tout au long de son parcours doctoral. Elle a reporté le projet d’avoir un enfant et vécu dans une incertitude permanente liée à ses ressources financières : elle ne savait si elle pourrait subvenir à ses besoins les mois suivants, comme elle le dit : « J’ai mis ma vie en pause. »

Alice, de son côté, s’est volontairement isolée pour rester concentrée, elle s’enfermait plusieurs jours dans des logements temporaires pour écrire, jusqu’à couper ses liens sociaux. Amandine parle d’un emploi du temps saturé : « Il y avait soixante-dix heures par semaine ou plus qui étaient consacrées au travail, donc après, je mangeais, je dormais. »

Une autre personne interrogée évoque une période de tension continue entre charge professionnelle et vie personnelle : « Je faisais deux heures et demie de route, matin et soir, pour donner mes cours avec mes deux enfants à gérer. J’étais épuisée, mais je ne pouvais pas lâcher. »

Ces témoignages disent que le doctorat, ce n’est pas seulement une surcharge de travail. C’est une pression continue qui efface progressivement ce qui fait la vie autour du travail : les projets, les relations, le soin de soi. Et cet effacement s’aggrave encore lorsque les conditions économiques sont précaires. Toutes les personnes interrogées n’ont pas connu la même stabilité financière, mais pour beaucoup, le manque de ressources est venu renforcer la tension permanente : il rend chaque choix plus lourd. Une personne participant à l’enquête raconte :

« Financièrement, c’était très dur. C’est aussi pour ça que j’ai songé à arrêter. Je dis que c’est à cause de mon directeur, mais c’est à cause de… moi, je mettais la pression à mon directeur pour la finir rapidement cette thèse parce que ça a duré longtemps et j’avais besoin de gagner de l’argent, en fait. Et ce n’est pas les vacations à la fac qui me faisaient gagner un salaire normal. »

Un autre évoque la pression qui s’ajoute à celle du quotidien :

« Ma famille me disait : “Quand est-ce que tu vas te mettre à travailler ?”, parce qu’il faut rentrer de l’argent. Donc, il y avait aussi cette notion-là qui mettait un poids en plus. »

Le doctorat devient un espace de fragilité totale, où l’incertitude matérielle alimente l’usure mentale et l’effacement de soi.

Une mobilisation mentale continue

Les récits recueillis évoquent rarement un burn out au sens clinique. Mais tous parlent d’une tension psychique consentante : fatigue extrême, pensées envahissantes, culpabilité de ne jamais en faire assez.

Amandine décrit cette spirale mentale avec lucidité : « C’est que j’étais tout le temps en train de réfléchir à ce que j’avais à faire, à ce que je n’avais pas fait. C’est un truc qui te quitte pas. »

Chez Sebastian, cette pression se traduit par une culpabilité omniprésente :

« Au début, je culpabilisais beaucoup. Après, il y a un moment où je culpabilisais des fois d’aller au ciné ou de regarder Friends. Et, bien sûr, le sentiment de culpabilité, il va structurer tout ton état d’esprit quand tu es en thèse. »

Jean, lui, parle de pensées intrusives qui se poursuivent bien au-delà de la fin de la thèse : « Pendant un an, j’avais encore des pensées intrusives de thèse. Genre : “Il faut que tu bosses sur ta thèse.” Alors qu’elle était finie. »

Du lundi au vendredi + le dimanche, recevez gratuitement les analyses et décryptages de nos experts pour un autre regard sur l’actualité. Abonnez-vous dès aujourd’hui !

Un autre témoignage montre comment cette pression glisse vers une anxiété aiguë, presque corporelle :

« Pendant les moments où j’écrivais ma thèse, j’avais de plus en plus des moments de panique. De temps en temps, je sentais des crises d’anxiété qui montaient. »

Ces formes de fragilités ne sont pas isolées. Elles traduisent un système qui demande une mobilisation mentale permanente, sans droit au relâchement. Pour plusieurs, c’est après la soutenance que le corps lâche. Quand la pression tombe enfin, le vide s’installe. L’une raconte :

« J’ai cassé le plafond de verre, mais je continue à enlever les morceaux qui sont plantés dans ma peau. »

Troubles de la concentration, fatigue chronique, perte d’élan : la thèse ne s’arrête pas avec le manuscrit. Elle se poursuit dans le corps, la mémoire, le silence.

Et après tant de sacrifices, que reste-t-il ? Certains ont décroché un poste, d’autres enchaînent les contrats précaires. Mais certains ont renoncé, ils ne veulent plus faire partie du monde académique. Ces récits disent la fatigue d’un système qui épuise ses propres chercheurs avant même leur entrée dans la carrière.

![]()

Faustine Rousselot ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Doctorat : Les coûts invisibles de la thèse, entre surmenage et anxiété – https://theconversation.com/doctorat-les-couts-invisibles-de-la-these-entre-surmenage-et-anxiete-258119