Source: The Conversation – in French – By Maximiliano Marzetti, Associate Professor of Law, IESEG School of Management, Univ. Lille, CNRS, UMR 9221 – LEM – Lille Économie Management, IÉSEG School of Management

Aux États-Unis, un premier jugement autorise l’usage d’œuvres légalement acquises pour l’apprentissage des modèles d’intelligence artificielle, mais le recours à des contenus piratés est, lui, explicitement condamné. Un coup d’arrêt pour les auteurs, et un bouleversement juridique aux enjeux internationaux ?

En 2024, les auteurs Andrea Bartz, Charles Graeber et Kirk Wallace Johnson ont porté plainte contre Anthropic, l’un des géants de l’intelligence artificielle (IA), l’accusant d’avoir utilisé leurs ouvrages pour entraîner son modèle de langage Claude.

Cette affaire s’inscrit dans une série de litiges similaires : au moins 47 procès ont déjà été engagés aux États-Unis, visant différentes entreprises consacrées à l’IA. La question principale ? Les modèles d’IA auraient été entraînés à partir d’œuvres protégées par le droit d’auteur, sans autorisation préalable des auteurs, en violation ainsi de leurs droits exclusifs.

Une problématique universelle

Mais ce type de conflit ne se limite pas aux États-Unis : des contentieux similaires émergent dans le monde entier.

Partout, ce sont donc les juges qui, faute de précédents juridiques clairs, doivent trancher des affaires complexes (les hard cases, comme les appellent les auteurs états-uniens). Le droit d’auteur varie d’un pays à l’autre, certes, mais le cœur du conflit reste universel : des créateurs humains confrontés à une technologie non humaine qui bouscule leur place, leur légitimité et leur avenir.

Du côté des entreprises d’IA, l’argument est tout autre : selon elles, l’utilisation de contenus protégés dans le cadre de l’entraînement de modèles relève du fair use (usage équitable), c’est-à-dire une exception aux droits exclusifs des auteurs existant dans le droit américain. En d’autres termes, elles estiment ne pas avoir à demander la permission ni à verser de droits aux auteurs.

Cette position alimente une crainte croissante chez les auteurs humains : celle d’être dépossédés de leurs œuvres ou, pire encore, d’être remplacés par des IA capables de produire des contenus en quelques secondes, parfois de qualité comparable à celle d’un humain.

Guerre de récits

Ce débat est désormais au cœur d’une guerre de récits, relayée à la fois dans les médias et sur les réseaux sociaux. D’un côté, les défenseurs du droit d’auteur traditionnel et des créateurs humains ; de l’autre, les partisans des technologies disruptives et des avancées rapides de l’IA. Derrière ces récits, on assiste à une véritable confrontation entre modèles économiques, celui des auteurs humains et des industries fondées sur le droit d’auteur « traditionnel » (éditeurs, producteurs cinématographiques et musicaux, entre autres), et celui des entreprises et investisseurs développant des technologies de l’IA « révolutionnaires ».

Du lundi au vendredi + le dimanche, recevez gratuitement les analyses et décryptages de nos experts pour un autre regard sur l’actualité. Abonnez-vous dès aujourd’hui !

Bien que le copyright ait été conçu au début du XVIIIᵉ siècle en Angleterre, dans un paradigme technologique qu’on peut appeler « analogique », jusqu’à présent il a su s’adapter et aussi profiter des technologies à l’époque considérées comme « disruptives », telles que la photographie, le phonographe, le cinéma et, plus tard, le paradigme numérique et Internet. Cependant, aujourd’hui il se retrouve mis à l’épreuve à nouveau, peut-être plus sérieusement que jamais, par l’IA générative. Le droit d’auteur pourra-t-il aussi s’adapter à l’IA ou est-il, cette fois, en menace de disparition, de changements radicaux ou encore condamné à l’insignifiance ?

Des intérêts publics, géopolitiques et géoéconomiques pèsent aussi sur ces cas juridiques. Dans l’actuel ordre mondial multipolaire et conflictuel, des pays ne cachent pas leurs ambitions de faire de l’intelligence artificielle un atout stratégique.

C’est le cas des États-Unis de Donald Trump, lequel n’hésite pas à recourir aux politiques publiques pour soutenir le leadership des entreprises états-uniennes en matière d’IA, vraie « raison d’État ». Cela engendre une politique de dérégulation pour éliminer des règles existantes considérées comme des obstacles à l’innovation nationale. Pour des raisons similaires, l’Union européenne a décidé d’aller dans la direction contraire, en assignant à l’innovation en IA un cadre juridique plus contraignant.

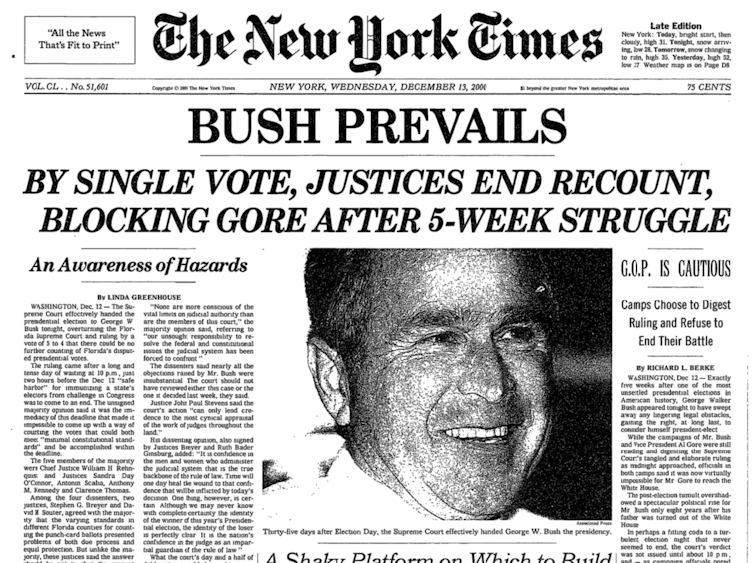

Les décisions des tribunaux états-uniens servent de boussole

Le 23 juin 2025, le juge Alsup du Tribunal du district nord de Californie a rendu la première décision, dans le cadre d’un procès en procédure sommaire introduit par les auteurs mentionnés précédemment contre l’entreprise Anthropic, par laquelle il a établi que l’utilisation d’œuvres protégées par des droits d’auteur, acquises de manière légale, pour entraîner des modèles de langage à grande échelle (LLM), constitue un usage légitime (« fair use ») et ne viole donc pas les droits d’auteur de leurs titulaires.

De même, cette décision a également établi que le téléchargement d’œuvres protégées par le droit d’auteur depuis des sites pirates ne pourra jamais être considéré comme un usage légitime, constituant ainsi une violation du droit d’auteur (même si ces œuvres ne sont pas utilisées pour entraîner des LLM et sont simplement stockées dans une bibliothèque à usage général).

Les décisions rendues par les tribunaux états-uniens en matière de droits d’auteur, bien qu’elles ne produisent d’effets juridiques que sur le territoire des États-Unis, servent généralement de boussole quant à l’évolution de la régulation des nouvelles technologies disruptives. Cela est dû non pas tant au prestige de la culture juridique nord-américaine, mais au fait que les plus grandes entreprises technologiques ainsi que les industries culturelles du cinéma, de la télévision et de la musique sont implantées aux États-Unis.

C’est la jurisprudence nord-américaine qui a établi en son temps que les enregistreurs à cassette (affaire Betamax (Sony)) ne violaient pas les droits d’auteur. Ce sont également les tribunaux américains qui ont statué que les réseaux de partage de fichiers peer-to-peer contrevenaient au droit d’auteur (affaires Napster et Grokster), entraînant la fermeture massive de ces sites.

Actuellement, la technologie accusée de porter atteinte au droit d’auteur est donc l’intelligence artificielle générative.

Les affaires pour violation présumée des droits d’auteur contre les géants états-uniens de l’IA générative (comme OpenAI, Anthropic, Microsoft, etc.) peuvent être regroupées en deux catégories :

-

l’utilisation d’œuvres protégées pour entraîner les algorithmes (problème des « inputs »),

-

et la reproduction totale ou partielle d’œuvres protégées dans les résultats générés par l’IA générative (problème des « outputs »).

Une victoire à la Pyrrhus pour les entreprises d’IA ?

Le litige opposant Bartz à Anthropic relève de la première catégorie. Bartz et d’autres auteurs accusent Anthropic d’avoir utilisé leurs œuvres pour entraîner ses algorithmes sans paiement ni autorisation. Il convient de rappeler que, tant aux États-Unis qu’ailleurs dans le monde, l’ensemble des droits d’exploitation d’une œuvre revient à son auteur. De son côté, Anthropic a fait valoir que cette utilisation devait être considérée comme un usage légitime ne nécessitant ni rémunération ni autorisation préalable.

La doctrine du fair use, codifiée à la section 107 du 17 US Code (recueil des lois fédérales), prévoit que, pour déterminer si l’utilisation d’une œuvre est conforme à la loi, le juge doit apprécier au cas par cas si les quatre critères posés par la loi favorisent le titulaire du droit d’auteur (le demandeur) ou la personne qui a utilisé l’œuvre (le défendeur).

Ces quatre critères sont :

-

le but et la nature de l’utilisation, notamment si elle est de nature commerciale ou à des fins éducatives sans but lucratif ;

-

la nature de l’œuvre protégée ;

-

la quantité et la substance de la partie utilisée par rapport à l’ensemble de l’œuvre ;

-

l’effet de l’utilisation sur le marché potentiel ou la valeur de l’œuvre protégée.

Dans l’affaire en question, le juge Alsup a opéré une distinction entre les usages légitimes d’œuvres légalement acquises et ceux qui ne le sont pas.

Dans le premier cas, Anthropic affirmait avoir acheté des œuvres protégées en format papier, les avoir scannées, converties au format numérique, puis avoir détruit les copies physiques (ce point étant juridiquement important car il s’agit alors d’un simple changement de format, sans reproduction de l’œuvre originale), afin de les utiliser pour entraîner son modèle LLM. Le juge Alsup a estimé que cet usage était légitime, compte tenu de l’acquisition licite des œuvres et en donnant la priorité au premier critère, avec le soutien de la jurisprudence relative au « transformative use » (plus l’usage d’une œuvre est novateur, plus il est probable qu’il soit considéré comme du fair use).

Concernant les œuvres acquises illégalement, soit environ 7 millions d’œuvres téléchargées depuis des bibliothèques pirates telles que Library Genesis et Pirate Library Mirror, le fair use n’a pas été retenu. D’une part, Anthropic ne pouvait ignorer la provenance illicite de ces œuvres, ce qui empêche tout usage légitime ultérieur. D’autre part, le simple fait de les conserver dans un dépôt numérique, même sans les avoir utilisées pour entraîner ses algorithmes, ne constitue pas une défense recevable, car Anthropic n’a aucun droit à leur copie ou à leur stockage.

En conséquence, s’agissant des œuvres téléchargées depuis des sites pirates, la procédure se poursuit, et Anthropic devra faire face à un procès sur le fond, qui pourrait lui coûter très cher, la législation américaine en matière de droit d’auteur autorisant l’octroi de dommages-intérêts forfaitaires (« statutory damages ») pouvant aller jusqu’à 150 000 dollars américains par œuvre en cas d’infraction commise de mauvaise foi.

Des réactions divergentes

Certains commentateurs ont salué cette décision comme une victoire éclatante pour les entreprises de l’IA. Une lecture plus nuancée s’impose. S’il s’agit bien de la première décision reconnaissant comme légitime l’utilisation d’œuvres protégées, acquises légalement, pour l’entraînement d’un système d’IA, elle établit également que l’usage d’œuvres issues de sites pirates, même transformé, ne pourra jamais être considéré comme légitime. En d’autres termes, l’utilisation d’œuvres piratées restera toujours illégale. Cette décision pourrait accélérer la négociation de licences permettant l’acquisition légale d’œuvres à des fins d’entraînement de LLM, une tendance déjà amorcée.

Les critiques à l’encontre de cette décision n’ont pas tardé. Certains reprochent au juge Alsup une mauvaise interprétation du droit fédéral et de la jurisprudence, en particulier de l’arrêt Warhol v. Goldsmith rendu en 2023 par la Cour suprême, qui a établi que le premier critère pouvait être écarté s’il compromettait fortement le quatrième : à savoir, si une œuvre dérivée concurrence ou diminue la valeur de l’œuvre originale.

En outre, il convient de souligner que cette décision est celle d’un tribunal de première instance. Il faudra attendre l’avis de la cour d’appel, voire, en dernier ressort, de la Cour suprême des États-Unis, en tant qu’interprète ultime de la loi. En tout cas, cette décision semble avoir une valeur symbolique importante.

La situation en Europe

Des litiges similaires ont également été engagés en Europe et dans d’autres pays. Bien que les législations sur le droit d’auteur soient proches de celle des États-Unis, elles présentent des différences notables.

En Europe continentale, il n’existe pas d’équivalent à la doctrine du fair use : le droit y repose sur un système d’exceptions et de limitations strictement énumérées par la loi, dont l’interprétation est restrictive pour les juges, à la différence de la souplesse dont jouissent leurs homologues états-uniens.

Par ailleurs, bien que la directive européenne de 2019 ait instauré une exception spécifique pour la fouille de textes et de données, sa portée semble plus limitée que celle du fair use nord-américain. En outre, dans le cadre d’usages commerciaux, les titulaires de droits d’auteur peuvent y faire opposition (« opt-out »).

Enfin, l’Union européenne dispose d’autres instruments susceptibles d’encadrer les IA, tels que le règlement sur l’IA, qui établit diverses garanties pour le respect des droits d’auteur, sans équivalent dans la législation états-unienne.

Répercussions internationales ?

Pour conclure, il convient de noter que le conflit entre droit d’auteur et IA dépasse les seules considérations juridiques.

La course au leadership en matière d’IA revêt aussi une forte dimension nationale. À cette fin, les pays rivalisent entre eux pour favoriser leurs entreprises par tous les moyens à leur disposition, y compris juridiques.

Compte tenu de la politique de régulation minimaliste et des directives émises par le gouvernement Trump, il ne serait donc pas surprenant que des juges idéologiquement proches du président adoptent des interprétations allant dans ce sens, privilégiant les intérêts des entreprises d’IA au détriment des titulaires de droits d’auteur. Une perspective qui relève du pragmatisme juridique états-unien.

Richard Posner, ancien juge fédéral, a d’ailleurs suggéré que, face à des « affaires difficiles », les juges ne suivent pas aveuglément les règles logiques et procédurales, mais qu’ils les résolvent de manière pragmatique, en tenant compte des conséquences possibles de leurs décisions et du contexte politique et économique.

Sous l’angle du « lawfare », le droit d’auteur pourrait bien devenir un nouveau champ de bataille dans la course mondiale à la domination technologique entre les États-Unis, l’Union européenne et la Chine.

Maximiliano Marzetti ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Les droits d’auteur en danger ? Ce que l’affaire « Bartz contre Anthropic » risque de changer aux États-Unis… et ailleurs – https://theconversation.com/les-droits-dauteur-en-danger-ce-que-laffaire-bartz-contre-anthropic-risque-de-changer-aux-etats-unis-et-ailleurs-261182

![]()