Source: The Conversation – (in Spanish) – By Antonio Figueras Huerta, Profesor de investigación del Consejo Superior de Investigaciones Científicas, Instituto de Investigaciones Marinas (IIM-CSIC)

Las olas de calor marinas, períodos de calentamiento extremo del océano que duran días o meses, han duplicado su frecuencia y duración desde 1982. Estos eventos invisibles están remodelando los ecosistemas marinos de todo el mundo. Sus efectos ya se sienten desde la Gran Barrera de Coral hasta los bancos marisqueros del noroeste de España.

Ocurren cuando las temperaturas del agua del mar superan el percentil 90 de los registros históricos durante al menos cinco días consecutivos. Lo que hace que estos eventos sean particularmente peligrosos es su naturaleza compleja: cuando las temperaturas del mar aumentan, los niveles de oxígeno bajan, creando zonas muertas donde la vida marina lucha por sobrevivir.

Las cifras son escalofriantes. Si las temperaturas globales aumentan 3,5° C hacia 2100 –nuestra trayectoria actual–, estas olas de calor podrían ser 41 veces más frecuentes que en tiempos preindustriales. Algunas podrían persistir durante más de 100 días, con anomalías térmicas que superarían los 2,5° C por encima de lo normal.

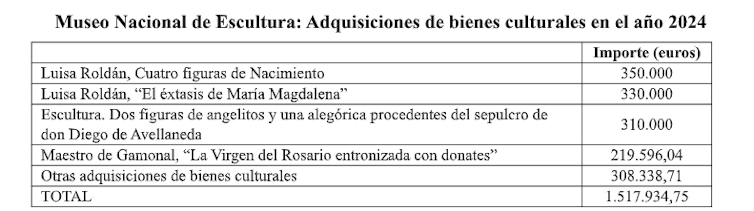

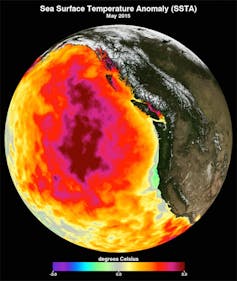

Laura Naranjo / NASA.

Estragos en la industria pesquera

Las consecuencias ya son visibles. La ola de calor marina del Pacífico de 2013-2016, conocida como The Blob, mató 100 millones de larvas de bacalao y 4 millones de aves marinas.

Otra ola de calor, en 2016, blanqueó el 30 % de los corales de la Gran Barrera de Coral en un solo evento. En 2019-2020, otra causó en el Pacífico una disminución del 70 % en las poblaciones de cangrejo, con lo que afectó gravemente a la industria pesquera.

Calor unido a bajo oxígeno

Quizás lo más preocupante es la combinación mortal de calor y oxígeno escaso –hipoxia–. En 2017, un evento de baja concentración de oxígeno en el golfo de Omán creó una zona sin vida del tamaño de Florida.

La evidencia científica muestra que, cada vez más con más frecuencia, las olas de calor marinas y los eventos de bajo oxígeno ocurren juntos, lo que amplifica sus efectos negativos.

Mediterráneo, una trampa de calor

Una investigación reciente reveló que, entre 2015 y 2019, el Mediterráneo experimentó cinco años consecutivos de eventos de mortalidad masiva que afectaron miles de kilómetros de costa desde la superficie hasta 45 metros de profundidad.

Los datos de este estudio señalan que las olas de calor marinas afectaron más del 90 % de la superficie mediterránea y alcanzaron temperaturas que superaron los 26 °C. En total, 50 taxones (grupos biológicos) de 8 filos diferentes fueron afectados por estos eventos de mortalidad, desde corales hasta esponjas y otros organismos bentónicos.

En concreto, el verano de 2022 marcó un punto de inflexión cuando se registró uno de los eventos de mortalidad masiva más intensos jamás documentados en el Mediterráneo noroccidental. Por primera vez, las profundidades de 25-30 metros estuvieron expuestas a temperaturas superiores a 25° C, considerado un umbral potencialmente letal para muchas especies mediterráneas.

Wikimedia Commons., CC BY

Los estuarios cambiantes de Galicia

También lleva años sucediendo en las partes más internas de las rías de Galicia, el corazón de la industria marisquera de España. La ría de Arousa, epicentro del marisqueo gallego, está experimentando olas de calor marinas estuarinas (EMHW, por sus siglas en inglés) que amenazan tanto el equilibrio ecológico como el sustento de miles de familias.

La investigación del grupo EPhysLab identificó condiciones de calentamiento sin precedentes en 2023. Durante este año extremo, el océano Atlántico Norte sufrió condiciones casi permanentes de ola de calor marina, afectando también al sistema de afloramiento canario, que incluye las costas gallegas.

El estudio reveló que, a excepción de febrero, todos los meses de 2023 mostraron una franja distintiva de temperaturas superficiales máximas en una gran área del océano Atlántico Norte, desde 30°W hasta las regiones costeras. Los análisis muestran que más del 80 % de los días fueron considerados como calurosos en zonas oceánicas.

Pero el calentamiento no es solo resultado de temperaturas cálidas del aire. Las condiciones extremas fueron impulsadas por anomalías térmicas oceánicas, con temperaturas superficiales que superaron 1,5° C por encima del promedio en amplias regiones del área de estudio.

Cwmhiraeth / Wikimedia Commons., CC BY

El coste humano

El exceso de calor afecta directamente a las especies clave del marisco gallego: almejas (Ruditapes decussatus y R. philippinarum), berberechos (Cerastoderma edule) y almejas babosas (Venerupis pullastra). Todos estos bivalvos viven enterrados en sedimentos blandos en zonas intermareales y someras, y su bienestar depende de que las temperaturas se mantengan en un rango concreto.

Cuando el mar se calienta más allá de su tolerancia, todo se complica. Su metabolismo se acelera, su sistema inmune no responde, la reproducción sufre y la mortalidad aumenta. Las proyecciones usando el escenario climático más pesimista sugieren que las partes interiores y poco profundas de los estuarios se volverán demasiado cálidas para estas especies.

También afectará a los humanos. Más de 7 000 personas, en su mayoría mujeres mariscadoras, dependen del marisqueo intermareal. Si estas zonas desaparecen como áreas productivas, muchas tendrán que abandonar su actividad tradicional. Trasladar los bancos marisqueros a zonas más profundas no es sencillo: cambian las condiciones, cambian las herramientas, cambian los permisos, cambian los costes y muchas especies no sobrevivirían.

Carrera contra reloj

Las olas de calor marinas no solo ocurren en verano. Los datos muestran que octubre, diciembre y febrero son los meses con más días de EMHW. Estos cambios térmicos fuera de temporada alteran los ciclos reproductivos de los bivalvos.

Las especies dependen de señales de temperatura para liberar los gametos que darán lugar a las larvas, comenzando el ciclo. Si estas aparecen cuando no hay suficiente alimento, no hay reclutamiento para las poblaciones, la producción es menor y la recuperación puede ser muy lenta.

Basándose en proyecciones científicas recientes, las condiciones térmicas dejarán de ser adecuadas para las especies de bivalvos en áreas poco profundas e interiores entre 2040 y 2055, si no se reducen las emisiones de gases de efecto invernadero. A corto plazo (2025-2035), aumentarán los episodios extremos, lo que afectará a su reproducción y supervivencia.

Una ventana crítica

A mediados de siglo (2035-2050), muchas zonas marisqueras actuales podrían volverse térmicamente inviables. Pero no es un caso aislado. La historia del marisco gallego ilustra una verdad global: las olas de calor marinas no son solo un problema ambiental, sino una crisis socioeconómica que afecta a comunidades de todo el mundo. Desde los ostricultores del Pacífico noroeste hasta los buceadores de oreja de mar de Australia, los medios de vida marinos tradicionales están bajo una presión sin precedentes.

El océano se acerca a un punto crítico. Sin intervención, las olas de calor marinas y la desoxigenación empujarán a los ecosistemas más allá de sus límites de resistencia, causando cambios irreversibles.

La ciencia ha cumplido su parte: identificar el problema y señalar soluciones. Ahora necesitamos voluntad política, recursos y compromiso. Porque esto no se trata solo de mariscos o arrecifes de coral. Se trata del futuro de nuestros océanos y de todos los que dependen de ellos.

![]()

Antonio Figueras Huerta no recibe salario, ni ejerce labores de consultoría, ni posee acciones, ni recibe financiación de ninguna compañía u organización que pueda obtener beneficio de este artículo, y ha declarado carecer de vínculos relevantes más allá del cargo académico citado.

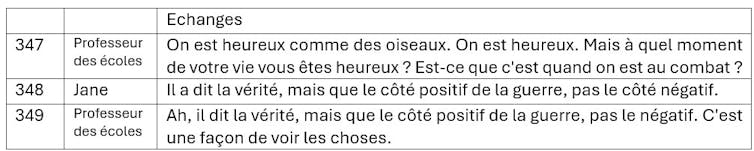

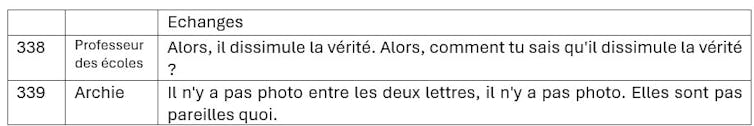

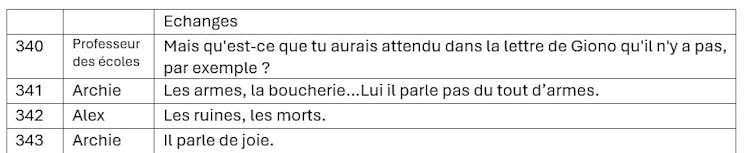

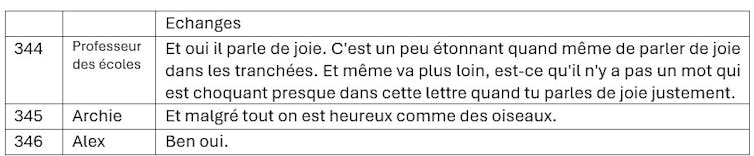

– ref. El océano se sofoca – https://theconversation.com/el-oceano-se-sofoca-250429