Source: The Conversation – in French – By Anthony Schrapffer, PhD, EDHEC Climate Institute Scientific Director, EDHEC Business School

Élévation du niveau de la mer, intensification des tempêtes… La concentration d’infrastructures sur le littoral les place en première ligne face au changement climatique. Les risques sont nombreux : paralysie des transports, coupures d’électricité, ruptures d’approvisionnement. De quoi inviter à mieux mesurer ces vulnérabilités pour mieux anticiper et prévenir les impacts. Ce travail est aujourd’hui compliqué par des données souvent partielles, des méthodes trop diverses et l’absence d’un cadre commun pour bien appréhender le risque.

La fin du mois d’octobre 2025 a été marquée par le passage dévastateur, dans les Caraïbes, de l’ouragan Melissa. Le changement climatique a rendu ce type d’événement quatre fois plus probable, selon une étude du Grantham Institute de l’Imperial College London. En plus de la soixantaine de morts déplorés à ce stade, le coût des dégâts engendrés a déjà été estimé à 43 milliards d’euros.

De nombreuses grandes agglomérations, ainsi que des ports, des zones industrielles et des infrastructures critiques, se trouvent en milieu littoral. 40 % de la population mondiale vit à moins de 100 kilomètres des côtes et 11 % dans des zones côtières de faible altitude – à moins de 10 mètres au-dessus du niveau marin. Ce phénomène s’explique en partie par la facilité d’accès aux échanges maritimes ainsi qu’aux ressources naturelles telles que l’eau et la pêche, et au tourisme.

Mais avec l’élévation du niveau de la mer et l’intensification des tempêtes, cette concentration d’infrastructures sur le littoral se retrouve en première ligne face au changement climatique. Transports paralysés, coupures d’électricité, ruptures d’approvisionnement… les risques sont plus divers et amplifiés.

La mesure de ces vulnérabilités s’impose pour anticiper les effets économiques, environnementaux et sociaux et, surtout, prévenir les ruptures. Mais comment prévoir l’impact du changement climatique sur les infrastructures côtières sans adopter un référentiel commun du risque ?

Des catastrophes climatiques de plus en plus coûteuses

Sous l’effet du changement climatique, de la montée du niveau des mers et de l’érosion qui rend les côtes plus fragiles, les tempêtes, cyclones et inondations côtières gagnent en fréquence et en intensité. Les infrastructures littorales sont particulièrement exposées à ces phénomènes extrêmes, avec des bilans humains et économiques toujours plus lourds.

En 2005, l’ouragan Katrina a submergé 80 % de La Nouvelle-Orléans et causé plus de 1 800 morts et 125 milliards de dollars (soit 107,6 milliards d’euros) de dégâts, dévastant des centaines de plates-formes pétrolières et gazières ainsi que plus de 500 pipelines. En 2019, le cyclone Idai a ravagé le Mozambique, entraînant 1 200 victimes, 2 milliards de dollars (1,7 milliard d’euros) de dommages et la paralysie du port de Beira. Deux ans plus tard, des pluies diluviennes en Allemagne, Belgique et Pays-Bas ont inondé villes et campagnes, avec pour conséquences : routes coupées, voies ferrées détruites, réseaux d’eau hors service et les transports ont mis plusieurs semaines à se rétablir.

Au-delà des dommages, ces catastrophes provoquent des interruptions d’activité des services produits par les infrastructures, et laissent moins de temps pour les reconstructions étant donné leur fréquence accrue.

Plus préoccupant encore, il existe des effets en cascade entre secteurs étroitement liés. Une défaillance locale devient le premier domino d’une chaîne de vulnérabilités, et un incident isolé peut tourner à la crise majeure. Une route bloquée par une inondation côtière, une panne d’électricité, sont autant de possibles impacts sur la chaîne d’approvisionnement globale. Faute de mesures adaptées, les dommages engendrés par les inondations côtières pourraient être multipliés par 150 d’ici à 2080.

Il y a donc urgence à mesurer les fragilités des infrastructures côtières de manière comparable, rigoureuse et transparente. L’enjeu étant de mieux anticiper les risques afin de préparer ces territoires économiques vitaux aux impacts futurs du changement climatique.

Vers un langage commun pour mesurer les risques

Estimer les potentiels points de rupture des infrastructures côtières n’est pas évident. Les données sont souvent partielles, les méthodes utilisées dans les études souvent diverses, les critères peuvent être différents et il manque généralement d’un cadre commun. Cela rend la prise de décision plus complexe, ce qui freine les investissements ciblés.

Pour bâtir un référentiel commun, une solution consisterait à mesurer les risques selon leur matérialité financière. Autrement dit, en chiffrant les pertes directes, les coûts de réparation et les interruptions d’activité.

L’agence Scientific Climate Ratings (SCR) applique cette approche à grande échelle, en intégrant les risques climatiques propres à chaque actif. La méthodologie élaborée en lien avec l’EDHEC Climate Institute sert désormais de référence scientifique pour évaluer le niveau d’exposition des infrastructures, mais aussi pour comparer, hiérarchiser et piloter les investissements d’adaptation aux risques climatiques.

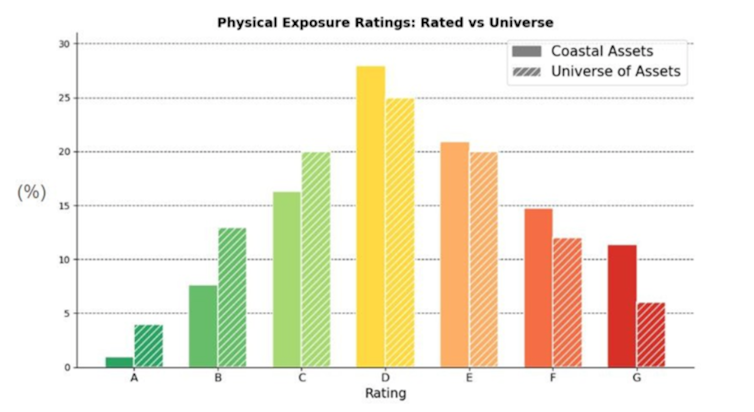

Ce nouveau langage commun constitue le socle du système de notations potentielles d’exposition climatique (Climate Exposure Ratings) développé et publié par la SCR. Celle-ci s’appuie sur cette échelle graduée de A à G pour comparer l’exposition des actifs côtiers et terrestres. Une notation de A correspond à un risque minimal en comparaison avec l’univers d’actifs alors que G est donné aux actifs les plus risqués.

Anthony Schrapffer, Fourni par l’auteur

Les résultats de la SCR montrent ainsi que les actifs côtiers concentrent plus de notations risquées (F, G) et moins de notation à faible risque (A, B). En d’autres termes, leur exposition climatique est structurellement supérieure à celle des autres infrastructures terrestres.

Risque bien évalué, décisions éclairées

Dans le détail, la méthode de quantification du risque physique élaborée par l’EDHEC Climat Institute consiste à croiser la probabilité de survenue d’un aléa avec son intensité attendue. Des fonctions de dommage relient ensuite chaque scénario climatique à la perte potentielle selon le type d’actif et sa localisation. Pour illustrer cela, nous considérons par exemple qu’une crue centennale, autrement dit avec une probabilité d’occurrence de 1 % par an, correspond à une intensité de deux mètres et peut ainsi détruire plus de 50 % de la valeur d’un actif résidentiel en Europe.

Ces indicateurs traduisent la réalité physique en coût économique, ce qui permet d’orienter les politiques publiques et les capitaux privés. Faut-il construire ? Renforcer ? Adapter les infrastructures ? Lesquelles, en priorité ?

L’analyse prend aussi en compte les risques de transition : effets des nouvelles normes, taxation carbone, évolutions technologiques… Un terminal gazier peut ainsi devenir un « actif échoué » si la demande chute ou si la réglementation se durcit. À l’inverse, une stratégie d’adaptation précoce améliore la solidité financière et la valeur de long terme d’une infrastructure exposée aux aléas climatiques.

S’adapter est possible : l’exemple de l’aéroport de Brisbane

La résilience pour une infrastructure représente la capacité à absorber un choc, et à se réorganiser tout en conservant ses fonctions essentielles. En d’autres termes, c’est la capacité pour ces actifs à revenir à un fonctionnement normal à la suite d’un choc.

L’initiative ClimaTech évalue les actions de résilience, de décarbonation et d’adaptation selon leur efficacité à réduire le risque et leur coût. Cette approche permet de limiter le greenwashing : seules les mesures efficaces améliorent significativement la notation d’un actif sur des bases objectives et comparables. Plus on agit, mieux on est noté.

Nate Cull/WikiCommons, CC BY-SA

L’aéroport de Brisbane (Australie), situé entre océan et rivière, en est un bon exemple. Des barrières anti-crues et la surélévation des pistes ont réduit à hauteur de 80 % le risque d’inondations pour les crues centennales. L’infrastructure a ainsi gagné deux catégories sur l’échelle de notation SCR : une amélioration mesurable qui accroît son attractivité.

Le cas de Brisbane révèle qu’investir dans la résilience des infrastructures côtières est possible, et même rentable. Ce modèle d’adaptation qui anticipe les dommages liés aux catastrophes climatiques pourrait être généralisé, à condition que les décideurs s’appuient une évaluation des risques fiable, cohérente et lisible comme celle que nous proposons.

Face au changement climatique, les infrastructures côtières sont à un tournant. En première ligne, elles concentrent des enjeux économiques, sociaux et environnementaux majeurs. Leur protection suppose une évaluation rigoureuse, comparable et transparente des risques, intégrant matérialité financière et évolution climatique. Une telle approche permet aux acteurs publics et privés de décider, d’investir et de valoriser les actions concrètes : rendre le risque visible, c’est déjà commencer à agir.

![]()

Anthony Schrapffer, PhD ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d’une organisation qui pourrait tirer profit de cet article, et n’a déclaré aucune autre affiliation que son organisme de recherche.

– ref. Infrastructures côtières menacées : comment mieux évaluer les risques climatiques pour mieux les anticiper ? – https://theconversation.com/infrastructures-cotieres-menacees-comment-mieux-evaluer-les-risques-climatiques-pour-mieux-les-anticiper-268859