Source: The Conversation – (in Spanish) – By Pau Sendra Pons, Profesor de Contabilidad, Universitat de València

Crear empleo, crecer económicamente, estimular la innovación, atraer inversión o aumentar la competitividad son objetivos comunes y recurrentes de cualquier economía mundial. Aunque las recetas para lograrlo varíen, hay un elemento que contribuye de manera significativa a conseguirlos: el emprendimiento, entendido como la puesta en marcha de proyectos empresariales basados en ideas innovadoras orientadas a la creación de valor.

Pero si preguntamos a cualquier niño o niña qué es lo que quieren ser de mayores, “emprendedor” o “emprendedora” no suele ser una respuesta habitual. Y sin embargo, es importante darles a conocer esta opción profesional y animarles a tenerla en cuenta.

Lo que se conoce como “formación emprendedora” –toda aquella que ayuda a una persona a convertir una idea de negocio innovadora en un proyecto empresarial real– pone al talento joven frente a un itinerario profesional que muchos aún no se habían planteado recorrer. En España, pese a los avances alcanzados en los últimos años, los jóvenes todavía no muestran una preferencia clara por emprender frente a otras alternativas de empleo por cuenta ajena.

Por otro lado, esta formación les dota de competencias y habilidades que, con independencia de que finalmente emprendan o no, favorecen una forma de trabajar ágil, resolutiva y alineada con las exigencias del entorno actual.

Suspensos en formación emprendedora

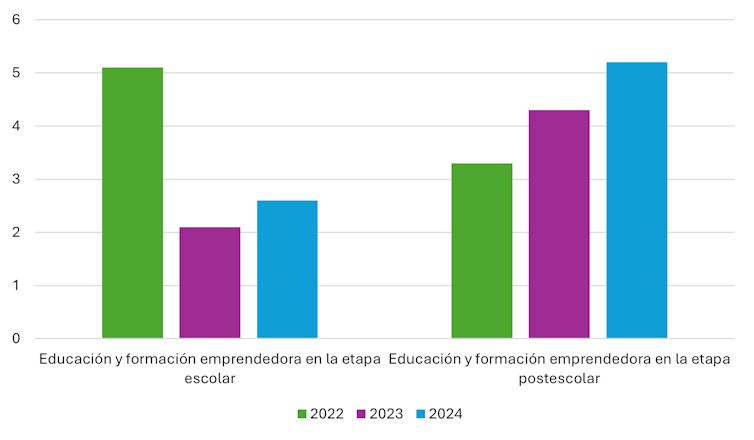

En España la formación emprendedora sigue siendo una asignatura pendiente: en una escala de 1 a 10, la educación y formación emprendedora en la etapa escolar apenas llega a un 2,6 según la valoración experta. Su evolución no está siendo muy prometedora: de un aprobado ajustado (5,1) en 2022 se descendió a un preocupante 2,1 en 2023, seguido del ligero avance citado.

En la etapa universitaria y de formación profesional, la puntuación alcanza un 5,2, una mejora notable respecto al 4,3 de 2023, y sigue una tendencia claramente ascendente. Pese a este avance, se sitúa lejos de niveles considerados sólidos. De hecho, el 68,4 % de los universitarios afirma no haber asistido a cursos de emprendimiento.

Fuente: Informe Global Entrepreneurship Monitor: datos sobre España 2024-25.

Aun así, el emprendimiento ha ganado relevancia dentro de la educación superior en los últimos años: el 92 % de las universidades españolas desarrollan iniciativas para fomentarlo, más del 75 % de las universidades públicas cuentan con estructura propia en este ámbito y casi el 60 % dispone de recursos destinados específicamente a esas acciones.

Situación parecida en el resto del mundo

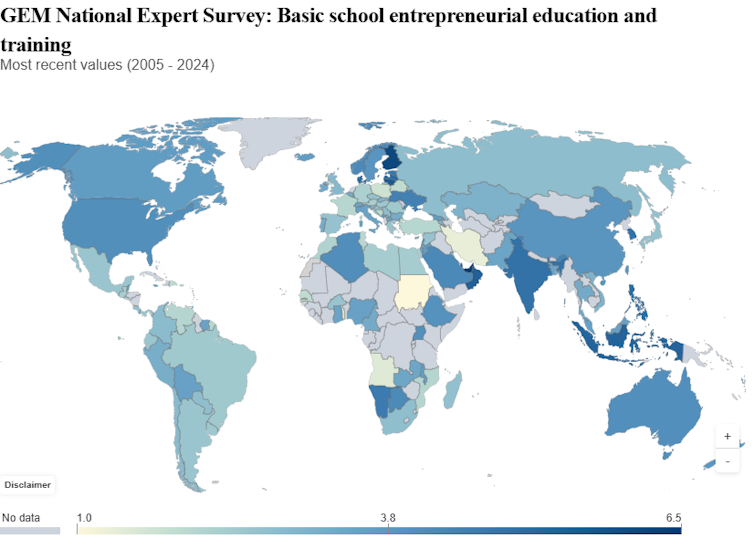

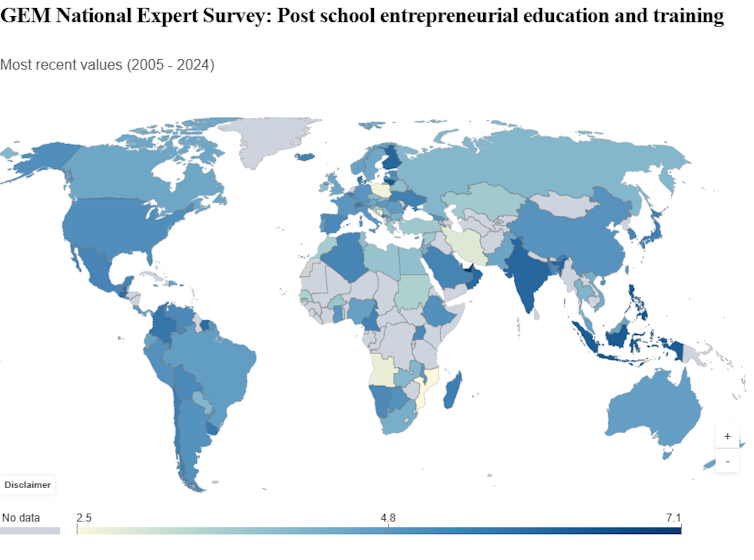

Los países de la Unión Europea obtienen resultados ligeramente superiores a los de España en la formación emprendedora escolar. En cambio, se sitúan por debajo en la formación postescolar: España alcanza un 5,2, frente al 4,5 de la media europea.

¿Y a escala mundial? Tanto en la etapa escolar como en la postescolar, los resultados son heterogéneos y en ningún caso superan el 6,5 en la valoración experta de la formación emprendedora escolar ni el 7,1 en la postescolar.

GEM National Expert Survey (https://www.gemconsortium.org/data/key-nes).

GEM National Expert Survey (https://www.gemconsortium.org/data/key-nes)

Ahora bien, aunque la formación es relevante, no es el único condicionante: la infraestructura comercial de un país, su cultura, la facilidad en el acceso a financiación o la simplificación burocrática, entre otros aspectos, también influyen de forma notable y determinan que unos países presenten mayores tasas de emprendimiento que otros.

Leer más:

Los retos del empleo juvenil en España

¿Un talento innato?

La capacidad de emprender no es algo con lo que se nazca, pero tampoco depende solo de la formación que se reciba. Es el resultado de una combinación de predisposiciones personales, experiencias, aprendizajes y contexto.

La educación primaria, secundaria y superior tienen un papel destacado en dar a conocer el emprendimiento como vocación profesional y, a su vez, en dotar al estudiantado de las herramientas, los conocimientos y las destrezas para poder decantarse por esa opción.

Favorecer la formación emprendedora

Integrar la formación emprendedora en la educación escolar supone introducir desde etapas tempranas cuestiones clave como la innovación, la generación de valor compartido, la creatividad, el pensamiento crítico, la toma de decisiones en contextos de incertidumbre y la iniciativa personal. Existen varias formas de enseñar emprendimiento: de manera transversal, como asignatura obligatoria o como optativa. Integrarlo transversalmente en el currículum representa el enfoque más extendido en etapas tempranas a nivel europeo.

Leer más:

Educación para emprendedores: ¿qué es el enfoque 360?

En la educación superior, lo fundamental ahora es:

-

Consolidar buenas prácticas, reforzando e institucionalizando programas de formación y asesoramiento dirigidos al talento emprendedor universitario.

-

Dotar de mayores recursos, incrementando no solo la financiación, sino también la disponibilidad de espacios seguros de aprendizaje y de infraestructura tecnológica.

-

Comunicar bien lo que hay disponible, haciendo visible la estrategia emprendedora de los centros, su propósito y el alcance esperado de sus iniciativas. Este empeño requiere el compromiso del sector educativo, de los decisores políticos y, en definitiva, de la sociedad.

Todo ello desde un enfoque multidisciplinar, promoviendo equipos de trabajo en los que participe estudiantado de distintas áreas de conocimiento. A mayor diversidad de perfiles, mayor facilidad para identificar oportunidades de emprendimiento que resulten exitosas.

![]()

Pau Sendra Pons no recibe salario, ni ejerce labores de consultoría, ni posee acciones, ni recibe financiación de ninguna compañía u organización que pueda obtener beneficio de este artículo, y ha declarado carecer de vínculos relevantes más allá del cargo académico citado.

– ref. España suspende en formación emprendedora: por qué es importante y cómo mejorar – https://theconversation.com/espana-suspende-en-formacion-emprendedora-por-que-es-importante-y-como-mejorar-272925