Source: The Conversation – (in Spanish) – By Paula Lamo, Profesora e investigadora, Universidad de Cantabria

En los últimos meses se repite una escena llamativa en medios de comunicación especializados en el ecosistema tecnológico: anuncios espectaculares sobre nuevos modelos de inteligencia artificial (IA) que conviven con retrasos en centros de datos, proyectos de computación intensiva paralizados y advertencias crecientes sobre los límites físicos del despliegue de la inteligencia artificial (IA).

La conversación pública suele atribuir estos problemas al consumo energético o al impacto ambiental. Pero el origen del cuello de botella es más específico y menos conocido. Porque la cuestión no es solo cuánta electricidad necesita la inteligencia artificial, sino cómo se gestiona esa electricidad dentro de los propios sistemas de computación avanzada. Y, ahí, entra en juego una disciplina que rara vez aparece en los titulares, pero que condiciona el ritmo real de la IA: la electrónica de potencia.

Control de la potencia

A diferencia de la electrónica digital, que se encarga de procesar información, la electrónica de potencia se ocupa de convertir, regular y controlar la energía eléctrica que alimenta procesadores, aceleradores y sistemas de alto rendimiento. La encontramos en el interior de los equipos, donde la electricidad debe adaptarse de forma extremadamente rápida y precisa a cargas que cambian en microsegundos. Es la tecnología que decide si un sistema puede operar de forma estable o si se convierte en una fuente constante de pérdidas, calor y fallos.

Este aspecto se ha vuelto crítico con la actual carrera por aumentar la capacidad de cálculo. Los aceleradores utilizados para entrenar y ejecutar modelos de IA concentran hoy densidades de potencia inéditas. Alimentarlos ya no es un problema trivial: requiere sistemas capaces de conmutar a muy alta frecuencia, responder a transitorios –variaciones momentáneas de voltaje– bruscos y mantener la estabilidad eléctrica en condiciones límite. Cuando esa conversión falla o se vuelve ineficiente, el problema no se soluciona con más software.

Imprescindible para escalar infraestructuras

Buena parte de las noticias recientes sobre dificultades para escalar infraestructuras de IA apuntan indirectamente a este fenómeno. Se habla de falta de suministro, de saturación de centros de datos o de costes crecientes, pero detrás de muchos de estos titulares hay un reto técnico concreto: la conversión eléctrica interna se ha convertido en un factor limitante del diseño.

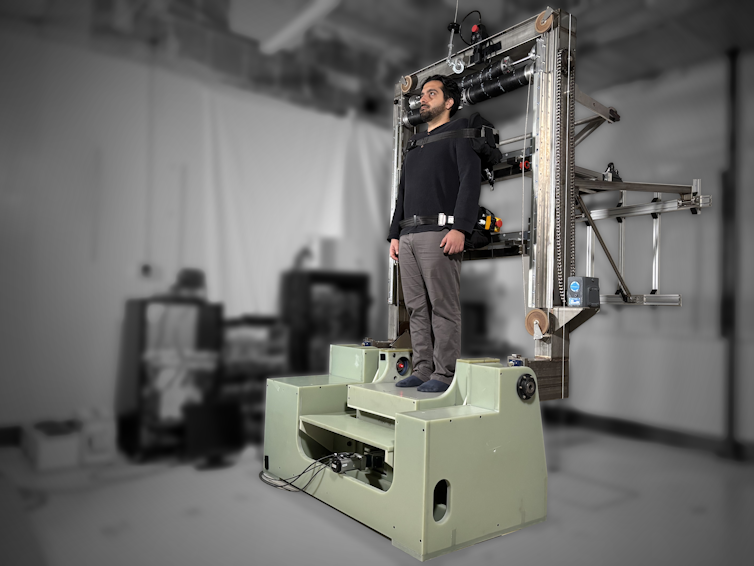

A medida que aumenta la potencia por unidad de volumen, la electrónica que alimenta los sistemas pasa de ser un componente más a condicionar toda la arquitectura.

CC BY-NC-ND

Sin energía, no hay IA

Durante años, el progreso digital se benefició de mejoras continuas en la electrónica convencional que permitían aumentar prestaciones sin replantear el sistema. Sin embargo, este margen se ha reducido. Hoy, cada incremento de capacidad computacional exige rediseñar cómo se entrega la energía, cómo se controla y cómo se disipa el calor generado. En este contexto, la electrónica de potencia deja de ser una tecnología transversal o “de apoyo” y se convierte en una condición de posibilidad para las IAs más avanzadas.

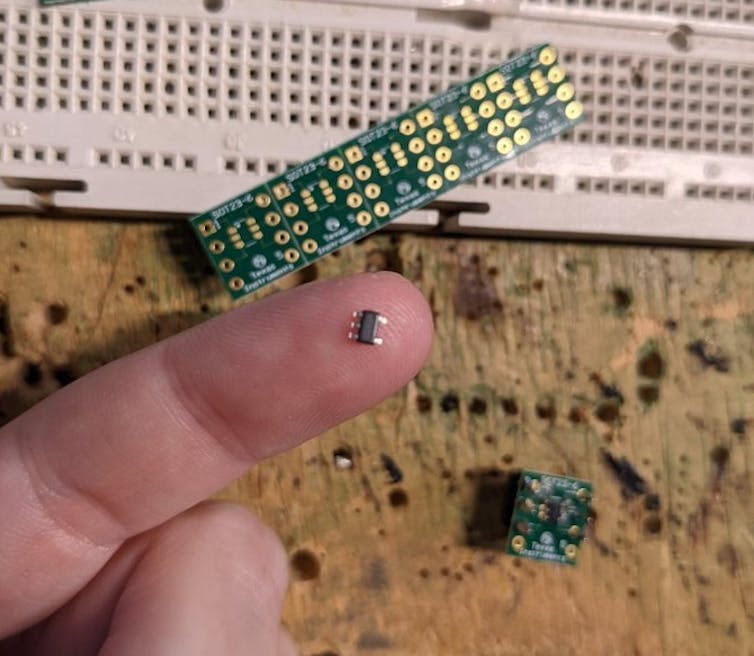

Este giro explica el creciente interés que hay alrededor de los nuevos semiconductores de potencia, capaces de operar a mayores frecuencias, con menos pérdidas y mayor densidad.

No se trata de una mejora incremental, sino de una respuesta directa a los límites físicos que empiezan a aflorar en la computación intensiva. La capacidad de alimentar de forma fiable un sistema de IA determina hoy tanto su viabilidad como la sofisticación del modelo que ejecuta.

CC BY-NC-ND

Choque con los límites físicos

Desde hace décadas, comunidades técnicas internacionales como la IEEE Power Electronics Society y la IEEE Industrial Electronics Society trabajan, precisamente, en este punto de fricción entre computación avanzada y límites físicos. Su experiencia muestra que muchos de los desafíos actuales de la IA no se resolverán únicamente con mejores modelos, sino con avances en la ingeniería que hace posible su operación continua y segura.

A pesar de todo lo anterior, esta dimensión apenas aparece en el relato público sobre inteligencia artificial, que sigue centrado casi exclusivamente en datos, algoritmos y capacidades cognitivas. La IA se presenta como una tecnología abstracta, cuando, en realidad, depende de infraestructuras electrónicas extremadamente exigentes. Ignorar esta capa conduce a expectativas poco realistas sobre la velocidad a la que se puede escalar y desplegar en entornos reales.

Esto no significa que la inteligencia artificial esté “atascada” ni que su desarrollo vaya a detenerse. Significa que su ritmo real está cada vez más condicionado por factores materiales que rara vez se discuten fuera del ámbito especializado.

Una visión integral

La pregunta relevante ya no es solo qué puede hacer un algoritmo, sino qué puede sostener el hardware que lo alimenta durante años, sin fallar y sin disparar los costes.

Tal vez, por eso, el debate actual sobre la IA necesita ampliarse. No para restar importancia al software, sino para incorporar una visión más completa del sistema tecnológico en su conjunto. Porque el avance de la inteligencia artificial no depende únicamente de lo que somos capaces de imaginar en código, sino de lo que la electrónica puede soportar de forma estable, eficiente y fiable. Y, ese límite, hoy, empieza a hacerse visible.

![]()

Este trabajo ha sido apoyado por el Gobierno Regional de Cantabria y financiado por la UE bajo el proyecto de investigación 2023-TCN-008 UETAI. También, este trabajo fue financiado por el Ministerio de Ciencia e Innovación de España MICIU/AEI/10.13039/501100011033 y por FEDER, UE bajo el proyecto de investigación PID2021-128941OB-I00, “Transformación Energética Eficiente en Entornos Industriales”.

La autora es Presidenta del Capítulo conjunto español PELS-IES de IEEE, sociedades mencionadas en este trabajo (http://ieee-pels-ies.es/).

– ref. La electrónica y el límite físico que ignoramos cuando hablamos de IA – https://theconversation.com/la-electronica-y-el-limite-fisico-que-ignoramos-cuando-hablamos-de-ia-272634